Page 231 - 《软件学报》2025年第12期

P. 231

5612 软件学报 2025 年第 36 卷第 12 期

多样本 KGC 方法包括基于张量分解、Trans 距离、神经网络、大模型、多模态以及辅助信息的方法. 张量分

解是矩阵分解在高阶上的泛化, 擅长高维和复杂关系的 KG. 神经网络能获取深度交互特征, 适用于高维复杂的图

数据, 具有很好的表现力. Trans 距离方法简单高效, 适用于大规模 KG. 辅助信息的模型适用于训练样本不足以及

稀疏的 KG, 同时适用于 ZKGC 以及 FKGC 情形. 大模型 KGC 模型能够为 ZKGC 和 FKGC 提供丰富的语义信息

提高表示学习的性能, 也能在 MKGC 情形和多模态 KGC 中表现出优势. 但是, 大模型的幻觉问题和对捕获的事实

缺乏一定的可解释性限制其泛化能力. 多模态 KGC 模型能为张量分解、Trans 距离和神经网络提供丰富的模态特

征以促进 KGC 的性能. 同时, 也适用于 ZKGC 和 FKGC 场景.

从数据规模来说, ZKGC 模型对训练数据规模要求不苛刻, 其中基于描述信息的方法要求高质量的实体描述

才能实现较好的性能. 但现实中高质量的实体描述难以获取, 而大模型的方法对训练样本没有要求且可以提供丰

富的语义信息. FKGC 模型如元学习、度量学习、优化学习这 3 种方法对训练数据的规模有一定的要求, 需要小

规模的标记数据进行初步学习, 而大模型的方法与 ZKGC 模型差不多, 对数据规模没要求. MKGC 模型如 Trans

距离、张量分解、神经网络等需要大量的训练样本, 现实中完全标记的数据难以获取. 因此, 受到一定限制. 而大

模型的方法对训练数据规模没有要求, 因此同时适用 ZKGC、FKGC 和 MKGC 场景.

6 已有知识图谱补全模型比较

本节主要通过实验对已有的 KGC 模型进行比较, 包括常用评估指标、公开实验数据集、实验设计以及结果

分析. 为确保实验公平, 本节涉及所有实验均在服务器上完成, 服务器参数为: NVIDIA RTX 2080S GPU、Intel

Xeon E5-2687W v2 3.40 GHz CPU 和 64 GB RAM, 且实验参数设置与原始文献保持一致.

6.1 知识图谱补全模型常用评估指标

知识图谱补全本质上是给定查询条件下的排序问题, 一般包括: 已知实体预测对应的关系和已知关系预测对

应的缺失的实体, 即 (h, ?, t) 和 (?, r, t) 或 (h, r, ?), 其中 (h, ?, t)、(?, r, t)、(h, r, ?) 为查询 Q. 常用评价指标包括 MR

(mean rank) 表示一系列查询 Q 返回排序的平均值; Hits@k 表示排名在前 k 名中所占的比例取值在 [0, 1] 之间, 取

值越高模型效果越好; MRR (mean reciprocal rank) 表示一系列查询 Q 返回排序取倒数之后的平均值, 取值越大, 模

型预测性能越好.

6.2 知识图谱补全常用公开数据集

● WordNet: 是一种基于认知语言学的大型 KG 数据集, 它通过各种英文单词作为实体, 单词之间不同的语义

关系作为实体间关系构建的知识图谱.

● Freebase: 是一个超大规模的百科类型的知识图谱数据集, 里面涉及了多种学科知识, 可以看成一个由主题

扩展的多个域组成的数据库, 每个主题的图结构都由其类型和类型属性控制.

● NELL: 是一个阅读网络搜集结构化的知识数据集. NELL-One 去除了 NELL 的反向关系.

● Wikidata: 是维基百科数据, 基于此构建 FKGC 数据集 Wiki-One. 表 16 例举了不同补全任务下常用的公开

数据集.

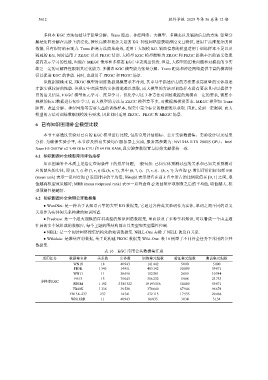

表 16 KGC 常用公共数据集汇总

适用任务 数据集名称 关系数 实体数 训练集元组数 验证集元组数 测试集元组数

WN18 18 40 943 141 442 5 000 5 000

FB5K 1 345 14 951 483 142 50 000 59 071

WN11 11 38 696 112 581 2 609 10 544

FB13 13 75 043 316 232 5 908 23 733

多样本KGC

FB5M 1 192 5 385 322 19 193 556 50 000 59 071

FB40K 1 336 39 528 370 640 67 946 96 678

FB15K-237 237 14 541 272 115 17 535 20 466

WN18RR 11 40 943 86 835 3 034 3 134