Page 228 - 《软件学报》2025年第12期

P. 228

郑修林 等: 知识图谱补全技术及应用 5609

用 KG 连通性而不需要对其进行预处理, 因此适用于规模不断扩大的 KG.

KG 中多跳关系路径可以表示实体间丰富的语义关系, 反映知识图中关系之间复杂的推理模式, 有助于促进

基于路径的关系推理的发展. mh-KGC [94] 旨在基于关系路径推理实现 KGC 任务. PRA [95] 是在大型 KG 中学习推理

路径的方法, 基于深度优先搜索使用随机游走策略生成给定实体对之间的关系路径. 然而, PRA 具有特征爆炸问

题和巨大的计算开销. PRA+ [96] 是 PRA 的扩展, 更高效且更具表现力, 通过预先训练的关系向量表示来缓解特征爆

炸问题, 但他们的核心机制仍然是基于原子路径特征的分类器. PATH-RNN [97] 将路径视为非原子特征, 不仅可以在

路径上联合推理, 还可以推导到向量嵌入空间中, 以非原子和组合的方式对路径的元素进行推理. 将多跳路径信息

引入到经典翻译模型中, PTransE [98] 为每个现有关系创建反向关系, 使 KG 中的边数加倍并且使用路径约束资源分

配算法来选择可靠路径输入. RTransE [99] 把 TransE 中学习的关系组成关系序列, 在路径之间进行推理以达到预期

的结果. PTransD [100] 是一个路径扩充的 TransD, 认为关系路径是 KG 中实体之间的转换. PTransD 将实体和关系考

虑到不同的语义空间中, 对每个实体和关系同时采用两个向量表示.

逻辑规则通过有关专业领域知识的规则来转移特定领域的知识, 使得基于规则的推理实现较高的精度. 此外,

逻辑规则独立于任意实体, 可解释性较好. MLN-based [101] 在最大似然估计下使用 MLN (Markov logic network) 执

行 KGC 任务, 并从理论上讨论了数据缺失情况下从 KG 中学习 MLN 权重的适用性. NeuralLP [102] 是一种端到端可

微框架, 它结合了一阶规则推理和稀疏矩阵乘法, 可以同时学习逻辑规则的参数和结构. 此外, 它通过注意力机制

神经控制器为逻辑规则分配不同的置信分数控制 LSTM 中 TensorLog [103] 的可微运算合成过程, 以学习可变规则

[104]

长度. RLvLR 利用 RESCAL 嵌入技术从 KG 中学习规则, 在谓词和自变量嵌入空间中引入引导规则的挖掘以

解决规则挖掘可扩展性问题. 相对于 NeuralLP, RLvLR 在规则质量和系统可扩展性方面都表现良好. 类似于 NeuralLP,

NTP [105] 专注于神经网络和规则推理的融合, 按照 ProLog 中提到的反向链接对神经网络进行建模. 但是 NTP 计算

复杂, 可扩展性较差. AnyBURL [106] 自下而上地从大型 KG 中学习逻辑规则, 是一个有效的规则挖掘器. 通过学习

模糊、不确定的规则, 候选排名可以通过生成排名的规则来解释, 所以具有很好的解释性. 同时, 运行速度快, 资源

使用较少. ELPKG [107] 将路径信息、嵌入表示和软概率逻辑规则结合在一起实现 KGC 任务, 能够缓解知识不一致

和冲突问题, 具有很高的运行效率和链接预测精度. RPJE [108] 通过 Horn 规则结合路径和语义级别的关联关系, 将逻

辑规则和路径表示结合, 充分利用逻辑规则的准确性和可解释性的优势.

现实的 KG 动态变化具有时序特征, 如 Twitter 中社交 KG, 只有在一定时间段内有效, 这类 KG 的补全称为时

序知识图谱补全 (TKGC). 将时间戳与相应的实体或关系相关联, 以实现实体或关系的演变. T-TransE [109] 扩展了经

典的 TransE 模型, 在同一嵌入空间中引入时间戳一起学习, 认为特定事件的发生时间可以表示事实和关系的特定

时间顺序. 但是, 该模型不是直接学习时间的嵌入, 而是先学习关系之间的时间关系, 然后作为约束. 因此, 该嵌入

不是显示时间感知的. 为此, ST-TransE [110] 进一步提出一种特定的时间嵌入来约束实体和关系的表示学习. T-TransE

和 S-TTransE 都致力于有效地处理时间演变的事实. 受 TransH 的启发, HyTE [111] 将时间戳与对应超平面关联, 显

示地将时间嵌入实体关系空间中, 充分利用时间引导知识推理和预测时间敏感事实关系的有效时间范围. TDG2E [112]

提出一种动态感知时间间隔变化的方法, 既可以保留当前的子图状态, 又可以保留变化的模式. 表 13 总结了基于

辅助信息的 MKGC 模型.

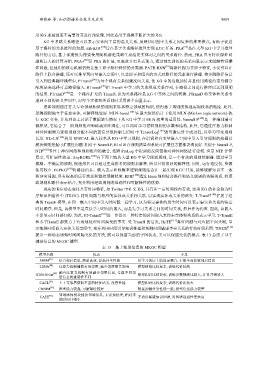

表 13 基于辅助信息的 MKGC 模型

模型名称 优点 不足

NMM [87] 结合邻居信息, 简单高效, 提高补全性能 仅学习邻居上的固定混合, 不能全面获取邻居信息

[88]

LENA 注意力机制捕获有效邻居, 减少邻居噪音影响 模型结构比较复杂, 训练代价较高

[89] 融合注意力机制有效融合邻居信息, 考虑不同邻

G2SKGEatt 模型相对比较复杂, 训练参数规模比较大, 计算开销较大

居信息的重要性不同

[91]

CACL 上下文邻居获取丰富的特征语义, 改善性能 模型相对比较复杂, 训练代价比较大

CNNIM [92] 推理能力较强; 可解释性较好 链接预测任务性能一般; 模型泛化能力较差

邻域感知模块捕获邻域信息, 无需预处理, 相对来

[93]

CAFE 不适用稀疏知识图谱, 对图谱连通性要求高

说时间开销小