Page 224 - 《软件学报》2025年第12期

P. 224

郑修林 等: 知识图谱补全技术及应用 5605

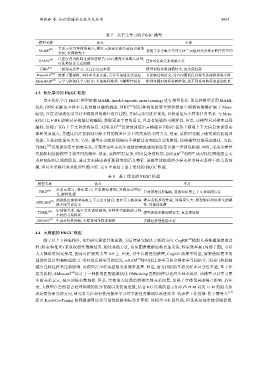

表 7 基于元学习的 FKGC 模型

模型名称 优点 不足

关系元学习实体的嵌入; 梯度元加速更新以适应更新的

MetaR [49] 忽视了参考集中不同实体三元组对关系表示的作用不同

关系; 查询损失少

GANA [50] 门控注意力机制过滤邻居噪音; GAT提高实体嵌入质量; 在N-N复杂关系效果不佳

可处理复杂关系建模

HiRe [51] 三级别关系学习; 交互信息更丰富 模型训练参数规模较大, 复杂度较高

[52]

Meta-iKG 局部子图建模; 多样本关系更新; 元学习加速迭代适应 只提取结构语义, 对有向图的反对称关系建模效果不好

Meta-KGR [53] 元学习和强化学习结合; 多条路径推理, 可解释性较好 推理过程对路径依赖性强, 找不到没有路径的查询结果

4.3 优化学习的 FKGC 模型

基于优化学习 FKGC 模型依赖 MAML (model-agnostic meta-learning) 进行模型优化, 即这种模型采用 MAML

优化 GNN 来解决少样本关系预测问题的挑战. FIRE [54] 使用异构邻居聚合器和搜索空间修剪策略扩展了 Meta-

KGR, 旨在采用强化学习对多跳推理的路径进行建模, 并用元学习进行优化, 以快速适应少样本任务关系. 与 Meta-

KGR 比, FIRE 能够对异构图结构编码, 获取更加丰富的语义, 且具有较强的可解释性. 但是, 该模型只对推理过程

编码, 忽视了 KG 上下文和结构信息. ADK-KG [55] 借助预训练语言模型在 FKGC 任务上获取上下文信息预训练实

体和关系嵌入, 并通过自注意机制分配不同的权重区分不同关系的不同含义. 然而, 该模型受限于硬关系的低推理

性能, 关系训练损失太大. 另外, 模型在训练阶段倾向于推断具有相似语义的路径, 使得模型结果局部最优. 为此,

THML [56] 识别训练集中的硬关系, 并聚类这些关系生成新的硬度感知训练集以进一步训练模型. 同时, 采用多样性

奖励机制鼓励模型寻找不同的路径. 然而, 该模型更复杂, 时间复杂度较高. ZSGAN [57] 利用生成对抗性网络建立文

本和知识图之间的联系, 通过文本描述表征新标签的语义特征. 该模型能够适应少样本和零样本条件下的关系预

测, 但对多条路径关系推理性能不好. 表 8 中总结了基于优化的 FKGC 模型.

表 8 基于优化的 FKGC 模型

模型名称 优点 不足

关系元学习; 强化学习; 多条路径推理; 异构知识图语

[54]

FIRE 只对推理过程编码, 忽视知识图上下文和结构信息

义, 解释性强

[55] 预训练语言模型获取上下文语义信息; 自注意力机制获 硬关系低推理性能, 训练损失大; 模型倾向相似语义的路

ADK-KG

取不同关系语义 径, 局部最优解

识别硬关系, 减少关系训练损失; 多样性奖励机制寻找

THML [56] 模型训练参数规模较大, 复杂度较高

不同的关系路径

ZSGAN [57] 生成对抗性网络, 少样本和多样本情形 多路径推理性能不好

4.4 大模型的 FKGC 模型

除了以上 3 种思路外, 也有研究探索其他思路, 为后续研究提供了新的方向. CogKR [58] 模拟人类推理逻辑的过

程 (检索和推理) 来获取最终预测结果. 相比其他方法, 认知图谱数据结构更加灵活, 检索效率高 (局部子图), 可以

大大降低时间复杂度, 因而可扩展到大型 KG 上. 但是, 对于长路径的推理, CogKR 效果不明显, 需要借助更多的

辅助信息以增强推理能力. 受对抗迁移学习的启发, wRAN [59] 将对抗迁移学习和少样本学习相结合, 采用门控机制

减少迁移过程负迁移影响. 该模型在少样本提取关系效率显著. 但是, 语义相似的不相关样本区分性不强. 基于注

意力机制, AMmodel [60] 设计了一种新的匹配函数优化 GMatching 匹配构件以适应少样本场景. 该模型可以学习更

多的关系表示, 减少训练参数规模. 但是, 实体嵌入仅简单拼接实体关系信息, 忽视了实体邻居的噪音影响. 近年

来, 大模型在自然语言处理领域的优异表现以及快速发展, 结合 KG 结构的显示知识和 PLM 以及 LLM 的隐式知

识是值得研究的方向, 研究者关注如何使用提示学习对下游任务微调以改进效果. 代表性工作包括: 张宁豫等人 [12]

提出 KnowCo-Tuning 协同微调算法学习最优模板和标签计算模. 该模型可扩展性强, 但是其忽视实体邻域信息.