Page 222 - 《软件学报》2025年第12期

P. 222

郑修林 等: 知识图谱补全技术及应用 5603

表 4 基于描述的 ZKGC 模型 (续)

模型名称 优点 不足

无需重新训练模型避免高昂开销; 注意力机制和 对多模态知识图任务效果不明显; 模型相对复杂, 产生额外

[33]

EmReCo

特定关系限制减少无关信息的干扰 时空开销

新实体文本表示与已有图谱建立联系; 特定关系 文本描述信息特征使用不充分; 特定关系的屏蔽器易错过目

[34]

ConMask

屏蔽器减少不相关信息及噪音干扰 标相关词

[35] 多重交互注意力机制充分捕获实体间交互信息; 模型相对复杂, 时间复杂度较大; 不同词的特性没充分考虑,

MIA

充分挖掘文本和图结构语义信息 易受不相关信息影响

3.2 基于大模型的 ZKGC 模型

预训练语言表示模型 (pre-trained language model, PLM) 在自然语言处理中表现出优越的性能. KG-BERT [36] 首

次将 PLM 用于知识图谱补全, 将知识图谱的三元组看成文本序列, 则 KGC 问题被转化成序列分类问题. KG-

BERT 在 KGC 上效果显著, 但在排序指标上不理想. 为此, MTL-KGC [37] 提出了多任务学习框架提高 KG-BERT 的

[38]

性能. MEM-KGC 通过规避频繁的负采样降低时间开销. 扩展已有 PLM 规模对下游任务效果显著. 因此, ChatGPT

和 GPT-4 等大语言模型得到广泛关注. KG-LLM [39] 使用大模型丰富的实体和关系语义描述作为提示, 并利用响应

进行预测, 表现出较好的性能, 尤其对新实体的预测. 然而, 其忽视了 KG 中关键结构语义信息, 严重限制了其推理

能力. KoPA [40] 提出将三元组结构信息融入到 LLM 中, 以促进模型的结构感知推理能力. MPIKGC [41] 从不同角度查

询 LLM 包括推理、解释和总结能力扩展实体描述、理解关系和捕捉结构以弥补其上下文学习的不足. KG-LLM [42]

通过学习实体及关系的表示将结构图谱转化成自然语言提示微调 LLM, 提高其多条链路预测能力. 大模型包含丰

富的知识库, 囊括几乎所有实体对象的名称及其文本描述, 有效缓解传统方法对客观实体描述受限的缺陷. 通过提

供丰富的语义信息和推理性能极大地推动了包括 ZKGC 的补全技术的发展. 然而, 大模型工作类似于黑匣子, 对

捕获的事实缺乏一定的可解释性. 同时, 大模型经常产生幻觉和庞大的参数规模带来的巨大计算开销等问题, 限制

其泛化能力. 表 5 总结了基于大模型的 ZKGC 模型.

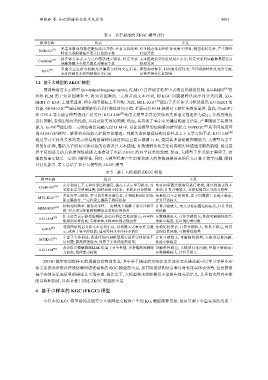

表 5 基于大模型的 ZKGC 模型

模型名称 优点 不足

充分利用上下文和外部语料信息, 提高了表示学习精度; 对 未对知识图关联信息进行建模; 排序性能表现不

[36]

KG-BERT

零样本学习效果显著; 同时适用少样本、多样本补全情形 理想; 计算开销较大; 对相似信息区分能力较差

多任务学习框架, 学习更多的关联信息; 在相似的词汇时也 效果提升不是很明显, 在不同数据上表现不稳定;

MTL-KGC [37]

能正确执行; 一定程度上提高了排序指标 计算开销较大

结构相对简单; 避免负采样, 一定程度上缓解了部分计算开 计算开销较大; 未充分使用图结构信息, 往往导致

MEM-KGC [38]

销; 对未见实体链接预测也具有较好的效果 次优解

扩大语言表示模型的规模, 提高自然语言处理能力; 补全性 参数规模很大, 计算开销较大; 性能可解释性较差;

[39]

KG-LLM

能得到显著提高; 零样本和少样本中都表现良好 效果不稳定, 易出现幻觉问题

利用图结构语义和文本语料信息; 结构嵌入式表示作为提 结构比较复杂, 计算开销较大; 效果不稳定, 时常

[40]

KoPA

示, 改善了补全的性能; 适用零样本和少样本情形 出现幻觉问题; 可解释性较差

丰富了实体描述, 改进传统PLM模型现实世界实体描述不 计算开销较大; 可解释性较差; 大模型幻觉问题,

[41]

MPIKGC

足问题; 提高推理能力; 改善了实体描述的质量; 性能不够稳定

KG-LLM [42] 改善提示模版微调LLM, 提高了补全性能; 多条链路预测能 可解释性较差; 大模型幻觉问题, 性能不够稳定;

力较高; 推理能力较强 参数规模较大, 计算开销大

ZKGC 模型对训练样本的规模没有特别要求, 其中基于描述的方法仅需要部分文本描述就可以学习零样本实

体关系的表示弥补传统依赖图谱连通性的 KGC 模型的不足, 如有限的结构信息难以对长尾实体表示等, 但是获取

每个实体关系高质量的描述是不现实的. 相比之下, 大模型技术能够提供丰富的实体关系语义, 几乎包含所有实体

的名称和描述, 以弥补基于描述 ZKGC 模型的不足.

4 基于少样本的 KGC (FKGC) 模型

少样本的 KGC 模型指的是现实中互联网社交媒体产生的 KG, 数据频繁更新, 最后只剩下少量完备的关系三