Page 225 - 《软件学报》2025年第12期

P. 225

5606 软件学报 2025 年第 36 卷第 12 期

Li 等人 [61] 利用 PLM 在语言理解和生成方面的出色能力, 自动生成知识图谱相关实体关系的文本描述用于少样本

知识图谱补全. GPT-3 [62] 通过在给定训练提示和无输入时估计模型的回答偏差, 然后拟合校准参数, 提高预测的准

确率, 减少不同提示选择之间的差异. 扩大语言模型规模可以极大地提高任务无关性、少样本学习的性能. 然而,

以上基于语言模型的研究未能充分考虑图结构语义信息, 进而限制了其推理能力. KoPA [40] 将结构信息整合到大模

型中, 以促进结构感知推理. 针对少样本知识图的长尾实体问题, MuKDC [63] 使用大模型生成知识弥补少样本情形

下数据稀缺, 通过多级知识蒸馏技术补全少样本知识图谱. 大模型的 FKGC 技术缓解了少样本情形下数据稀缺问

题, 提供更加丰富的语义促进性能的提高. 然而, 大模型工作类似黑匣子, 对捕获和获取事实知识及推理过程缺乏

一定的可解释性. 同时, 还有幻觉问题和巨大的计算开销一定程度上限制了其泛化能力. 表 9 总结了基于大模型

的 FKGC 方法.

表 9 基于大模型等的 FKGC 模型

模型名称 优点 不足

CogKR [58] 结构灵活, 检索效率高, 时间复杂度低, 适应大型图谱 对长路径推理能力差

[12]

KnowCo-Tuning 预训练语言模型提供丰富的语义、可扩展性强 直接使用实体信息, 忽视了实体邻域信息的作用

wRAN [59] 门控机制解决负迁移; 关系提取效果较好, 适合少样本学习 对语义相似的不相关样本的区分能力不是很强

[60]

AMmodel 丰富的关系表示; 训练参数规模小, 训练负担较小 实体嵌入简单拼接, 忽视实体邻域噪音的影响

大模型提供丰富的知识; 解决长尾问题; 提供结构语义, 推 模型参数规模较大, 时空开销较大; 可解释性较

KoPA [40]

理性能 差; 性能因数据而异

MuKDC [63] 提供丰富的知识缓解数据稀缺; 解决长尾问题 计算资源消耗较大; 可解释性较差; 性能不稳定

FKGC 方法包括基于度量学习、元学习、优化学习以及大模型相关的方法, 它们对训练样本数据的规模要求

不是很高. 基于度量的方法聚焦学习丰富的关系嵌入信息和优化匹配算法. 基于元学习的方法侧重于少样本学习

和消除邻居噪音. 优化学习侧重采用优化方案对嵌入学习以及性能进行优化. 结合元学习和优化学习可以实现快

速学习和效果提升, 且能同时适应 ZKGC 和 FKGC 场景. 大模型相关方法为少样本 (训练样本不足) 的 KGC 提供

丰富的语义和推理性能, 因此能够表现出较好的性能, 能够同时适应 ZKGC 和 FKGC 情形.

5 基于多样本的 KGC (MKGC) 模型

基于多样本的 KGC (MKGC) 模型指这些模型在构造过程中, 需要很多训练样本. MKGC 模型可以分为张量

分解、神经网络、Trans 距离、辅助信息、大模型、多模态的方法.

5.1 张量分解的 MKGC 模型

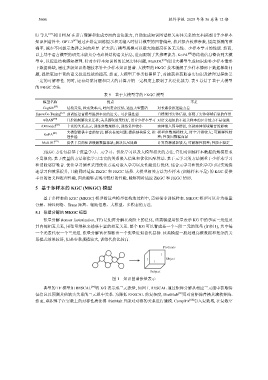

张量分解 (tensor factorization, TF) 是矩阵分解在高阶上的泛化, 该类模型用张量表示 KG 中的事实三元组及

其内部相互关系, 用张量乘积来捕获丰富的相互关系. 整个 KG 可以看成是一个三阶二元的张量 (如图 1), 其中每

一个元素代表一个三元组. 张量分解旨在推断出一个张量近似替代目标. 该类模型一般处理高维数据和复杂的关

系模式效果较好, 但是参数规模较大, 训练代价比较高.

Predicate

1

1 Object

1

Subject

图 1 知识图谱张量表示

典型的 TF 模型如 RESCAL [64] 将 KG 表示成三元张量, 如图 1. RESCAL 通过矩阵分解从相应三元组中获取特

征信息以预测其他缺失关系的三元组中关系. 为降低 RESCAL 的复杂度, DistMult [65] 用对角矩阵替换其满秩矩阵.

然而, 乘积算子在实数上的对称性质使得 DistMult 只能对对称的关系进行建模. ComplEx [66] 引入复数域, 在复数空