Page 221 - 《软件学报》2025年第12期

P. 221

5602 软件学报 2025 年第 36 卷第 12 期

距离、大模型、多模态、辅助信息 (邻居信息、关系路径、逻辑规则和时序特性) 的模型. 根据分类, 本文对 KGC

模型主要研究如表 3 所示.

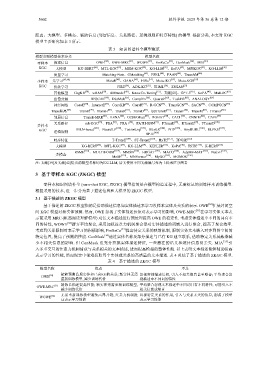

表 3 知识图谱补全模型概览

模型类别模型技术分类 模型名称

零样本 描述信息 OWE [30] 、OWE-MRC [31] 、WOWE [32] 、EmReCo [33] 、ConMask [34] 、MIA [35]

KGC 大模型 KG-BERT [36] 、MTL-KGC [37] 、MEM-KGC [38] 、KG-LLM [39] 、KoPA [40] 、MPIKGC [41] 、KG-LLM [42]

度量学习 Matching-Nets、GMatching [43] 、FSRL [44] 、FAAN [45] 、TransAM [46]

少样本 元学习 [47,48] MetaR [49] 、GANA [50] 、HiRe [51] 、Meta-iKG [52] 、Meta-KGR [53]

KGC 优化学习 FIRE [54] 、ADK-KG [55] 、THML [56] 、ZSGAN [57]

其他模型 CogKR [58] 、wRAN [59] 、AMmodel [60] 、KnowCo-Tuning [12] 、文献[61]、GPT-3 [62] 、KoPA [40] 、MuKDC [63]

张量分解 RESCAL [64] 、DistMult [65] 、ComplEx [66] 、QuarteE [67] 、TuckER [68] 、ANALOGY [69]

神经网络 ConvE [70] 、InteractE [71] 、ConvKB [72] 、ConvR [73] 、R-GCN [74] 、TransGCN [75] 、SACN [76] 、COMPGCN [77]

Trans距离 [78] TransE [79] 、TransH [80] 、TransR [81] 、TransD [82] 、lppTransD [83] 、TransF [84] 、TransM [85] 、ITransF [86]

邻居信息 TransE-MRR [87] 、LENA [88] 、G2SKGEatt [89] 、RGHAT [90] 、CACL [91] 、CNNIM [92] 、CAFE [93]

关系路径 mh-KGC [94] 、PRA [95] 、PRA+ [96] 、PATH-RNN [97] 、PTransE [98] 、RTransE [99] 、PTransD [100]

多样本

[101] [102] [103] [104] [105] [106] [107]

KGC MLN-based 、NeuralLP 、TensorLog 、RLvLR 、NTP 、AnyBURL 、ELPKG 、

逻辑规则 [108]

RPJE

时序特征 T-TransE [109] 、ST-TransE [110] 、HyTE [111] 、TDG2E [112]

大模型 KG-BERT [36] 、MTL-KGC [37] 、KG-LLM [39] 、KEPLER [113] 、KoPA [40] 、TSTR [114] 、K-BERT [115]

RSME [116] 、MULTIFORM [117] 、MMSN [118] 、HRGAT [119] 、MACO [120] 、AdaMF-MAT [121] 、NativE [122] 、

多模态 [123] [124] [125] [126]

MoSE 、MNFormer 、MyGO 、MOMOK

注: 文献[39]及文献[42]提出的模型名称均为KG-LLM, 后文使用不同文献编号作为上标来区分两者

3 基于零样本 KGC (ZKGC) 模型

零样本知识图谱补全 (zero-shot KGC, ZKGC) 模型指的是在模型构造过程中, 无需标记的训练样本训练模型.

根据采用的技术, 进一步分为基于描述信息和大模型的 ZKGC 模型.

3.1 基于描述的 ZKGC 模型

基于描述的 ZKGC 模型指的是借助描述信息如实体描述来学习没样本实体及关系的表示. OWE [30] 扩展封闭空

间 KGC 模型对新实体预测. 然而, OWE 忽视了实体描述长短对表示学习的影响, OWE-MRC [31] 在学习实体文本表

示前采用 MRC (机器阅读理解模型) 对长文本描述进行预处理提高 OWE 的稳定性. 考虑实体描述中不同的词有不

同的特性, WOWE [32] 摒弃平均聚合, 采用加权注意力机制聚合器对实体描述的词嵌入进行聚合, 提高了聚合效率.

考虑到关系限制对表示学习的积极影响, EmReCo [33] 提出特定关系的映射机制, 限制实体文本嵌入对齐到图空间的

特定位置, 提高了预测的性能. ConMask [34] 通过实体名称及部分描述与已有 KG 建立联系, 借助特定关系屏蔽器减

少不相关信息的影响. 但 ConMask 没充分挖掘实体描述特征, 一些潜在的语义和统计信息易丢失. MIA [35] 引

入多重交互的注意力机制捕获与关系相关的文本描述, 进而提高模型的整体性能. 以上表明文本描述能够辅助提高

表示学习的性能, 然而现实中很难获取每个实体或关系的高质量的文本描述. 表 4 总结了基于描述的 ZKGC 模型.

表 4 基于描述的 ZKGC 模型

模型名称 优点 不足

能够预测凸现实体和已有KG的关系; 新实体无需 忽视实体描述长短, 引入不相关信息甚至噪音; 平均聚合忽

[30]

OWE

重新训练模型, 减少训练代价 视描述中不同词的特性

[31] 精炼长描述提高性能; 新实体无需重新训练模型, 平均聚合忽视文本描述中不同词具有不同特性; 可能引入不

OWE-MRC

减少训练代价 相关信息或噪音

无需重新训练模型避免高昂开销; 注意力机制提 忽视特定关系的作用, 引入与关系无关的信息, 削弱了模型

[32]

WOWE

高表示学习性能 表示学习性能