Page 226 - 《软件学报》2025年第12期

P. 226

郑修林 等: 知识图谱补全技术及应用 5607

间对实体进行向量化, 能够对复杂的非对称关系进行建模. 因此, 该模型能同时处理好对称和非对称关系. QuateE [67]

创造性地引入超复数表示, 表现力更强, 通过四元组空间中的旋转来表示关系. QuarteE 是 ComplEx 在超复杂空间

上的推广, 几何解释性更好, 也满足对称、反对称等复杂关系的建模. TuckER [68] 分解模型和张量分解诸多模型都

是基于三阶二元张量对 KG 中三元组进行补全, 而 TuckER 模型用 TuckER 分解技术处理张量分解问题. TuckER

分解是一个强大的线性模型, 对二元张量表示, 参数较少, 效果好. 因此, 它能跨关系进行多任务学习. 然而,

TuckER 分解并不唯一, 如果对矩阵进行逆变换, 核心张量在不影响拟合的情况下也进行变换. 不同于 TuckER 分

[69]

解, DEDICOM 分解能够检测多个互连节点之间的相关性. 另外, ANALOGY 是 RESCAL 的扩展, 它对实体和关

系嵌入的类比特性进行显式建模, 应用了 RESCAL 中的双线性评分函数, 但受限于关系映射矩阵必须是正规且正

交的. 表 10 总结了基于张量分解的 MKGC 模型.

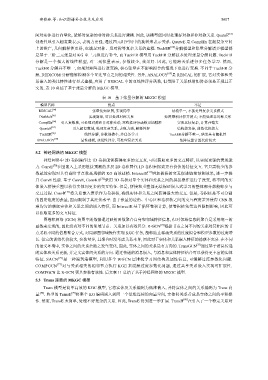

表 10 基于张量分解的 MKGC 模型

模型名称 优点 不足

[64]

RESCAL 张量化知识图, 实现简单 结构单一, 不能处理复杂关系模式

[65]

DistMult 实现简单, 可以处理对称关系 矩阵乘积计算开销大; 不能处理非对称关系

[66]

ComplEx 引入复数域, 可处理对称和非对称关系; 双线性评分函数更加精准 实现比较复杂, 计算开销大

[67]

QuarteE 引入超复数域, 处理复杂关系, 表现力强, 解释性好 结构较复杂, 训练代价较大

[68]

TuckER 线性分解, 参数规模小, 多任务学习 TuckER分解不唯一, 结果具有随机性

[69]

ANALOGY 显性建模, 双线性评分, 可处理复杂关系 矩阵运算计算代价较大

5.2 神经网络的 MKGC 模型

神经网络中 2D 卷积操作比 1D 卷积能够获得更多的交互点, 可以获取更多的交互特征, 以实现更强的表现能

力. ConvE [70] 在图嵌入上采用链接预测的多层 2D 卷积替代 1D 卷积来探索更有价值的特征交互. 它只需较少的参

数就能实现对具有高阶节点数高规模的 KG 高效建模. InteractE [71] 增加捕获的交互促进链接预测效果, 进一步提

升 ConvE 性能. 基于 ConvE, ConvKB [72] 采用 1D 卷积对单个实体和关系之间的拼接操作进行了改变, 将不同的实

体嵌入拼接重塑以获得实体间更多的交互特征. 但是, 拼接和重塑都无法保证嵌入式学习的整体部分都能够参与

交互过程. ConvR [73] 将关系嵌入表示作为卷积核, 确保实体和关系之间获得最大的交互. 但是, 卷积核是不可分割

的固定维度的张量, 因而限制了其泛化水平. 由于张量的边角、中心区和卷积核之间的交互程度差异使得 CNN 很

难均匀的获取实体和关系之间的嵌入特征, 而 InteractE 基于循环卷积计算, 使卷积核免受边界限制影响, 因此可

以获取更多的交互特征.

图卷积网络 (GCN) 将图中的数据通过映射函数聚合自身和邻域特征信息, 但对邻域信息的聚合是采用统一的

函数来实现的, 因此没有对不同的邻域节点、关系加以有效区分. R-GCN [74] 根据节点之间不同的关系对其相应的节

点采取不同的信息聚合方式, 对局部图邻域操作实现 KGC 任务, 能够防止稀疏关系的过度拟合和模型参数的过度增

长. 但它的训练代价较大, 参数量多, 且聚合时没考虑关系本身, 因此对于实体和关系嵌入特征的捕获不充分. 在不同

的语义环境中, 实体之间的关系会随之发生变化, 因此, 实体之间的关系是有方向的. TransGCN [75] 通过基于消息传递

的实体和关系更新, 并定义实体间关系的方向. 通过传递的消息嵌入, 与消息和实体特征结合可以获得更丰富的实体

特征. SACN [76] 是一种端到端模型, 利用多个 WGCN 层堆栈学习图结构及属性信息, 可缓解过度参数化问题.

COMPGCN [77] 对与关系相关的相邻节点执行 KGE 来缓解过度参数化问题, 通过共享关系嵌入实现可扩展性.

COMPGCN 比 R-GCN 更具参数有效性. 后文表 11 总结了基于神经网络的 MKGC 模型.

5.3 Trans 距离的 MKGC 模型

Trans 模型是简单高效的 KGC 模型, 它将实体及关系编码为低维嵌入, 并将实体之间的关系编码为 Trans 向

量 [78] . 典型的 TransE [79] 将整个 KG 编码嵌入到同一个低维连续的向量空间, 实体间关系看成是实体之间的平移操

作. 然而, TransE 太简单, 处理不好复杂的关系. 因此, TransE 得到进一步扩展. TransH [80] 在引入了一个特定关系对