Page 230 - 《软件学报》2025年第12期

P. 230

郑修林 等: 知识图谱补全技术及应用 5611

MMKGC 可能存在实体模态特征缺失或者模态信息不平衡导致模态间交互能力及融合效果减弱. MACO [120] 采用

模态对抗训练生成器和判别器生成缺失的模态特征. AdaMF-MAT [121] 通过自适应模态权重实现多模态信息融合和

模态对抗训练产生对抗样本以增强不平衡的模态信息, 而 NativE [122] 使用关系引导的双自适应融合模块实现任意

[123]

模态的自适应融合, 并借助协作模态对抗训练来改善模态信息间的不平衡. MoSE 模态分割关系表示学习, 采用

集成推理框架结合不同权重的预测以动态调整模态重要性, 减少传统 MNFormer [124] 共享关系表示引起训练过程

模态相互干扰. 然而, 上述方法忽略了模态间特征细粒度的语义差别及其交互. MyGO [125] 从细粒度模态信息对模

态信息进行融合. MOMOK [126] 使用关系引导的混合模态知识专家学习自适应多模态实体表示, 并整合来自多模态

的预测, 以实现联合决策. Chen 等人 [127] 只融合特定任务相关的多模态特征, 使用当前任务微调过的编码器获取不

同模态的特征表示, 过滤无关模态的信息, 以提高模态融合的性能. 然而, 现实多模态知识图更加复杂, 各模态之间

的信息如何有效协同才能达到更好的效果仍是一大挑战. 表 15 总结了基于多模态的 MKGC 模型.

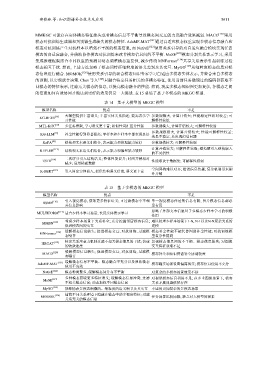

表 14 基于大模型的 MKGC 模型

模型名称 优点 不足

大模型提供丰富语义; 丰富实体关系描述; 提高表示学 参数规模大, 计算开销大; 性能稳定性相对较差; 可

[36]

KG-BERT

习性能 解释性较低

MTL-KGC [37] 多任务框架, 学习语义更丰富; 相似性词汇区分性强 参数规模大, 计算开销较大; 可解释性较弱

参数规模很大, 计算开销较大; 性能可解释性较差;

KG-LLM [39] 补全性能得到显著提高; 零样本和少样本中都表现良好

效果不稳定, 易出现幻觉问题

[40]

KoPA 结构和文本语义相结合, 表示能力和推理能力较好 参数规模较大; 可解释性较弱

计算开销较大; 可解释性较弱; 避免硬引入结构嵌入

[113]

KEPLER 结构和文本语义相结合, 表示能力和推理能力较好

的不灵活性

二次评分引入结构语义; 整体性能提升; 时间开销相对

[114]

TSTR 性能取决于数据集; 可解释性较弱

减少; 适用稀疏数据

空间异构难以对齐; 错误信息传播; 复杂机制带来额

K-BERT [115] 引入固定实体嵌入, 提供结构语义信息, 语义更丰富

外开销

表 15 基于多模态的 MKGC 模型

模型名称 优点 不足

引入视觉模态, 获取更多特征语义; 可过滤模态中不相 单一视觉模态传达的信息有限; 图片模态信息部总

[116]

RSME

关信息影响 是有用

忽略了外部文本信息对于多模态少样本学习的积极

[117]

MULTIFORM 适合少样本学习场景; 长尾实体表示学习

作用

考虑少样本场景下关系补全; 充分挖掘邻居模态信息; 难以处理少样本场景下1-N, N-1以及N-N复杂关系的

[118]

MMSN

促进模态间的交互 建模

缓解模态信息缺失; 促进模态交互; 对抗训练; 过滤模 模态补全性能不能代替图谱补全性能; 对抗训练模

[124]

MNFormer

态噪音 型复杂性提高

特定关系注意力机制过滤不相关模态信息的干扰; 快速 忽视模态信息间的不平衡、模态信息缺失; 对图像

[119]

HRGAT

的收敛速度 交互特征获取不足

缓解模态信息缺失; 促进模态交互; 对抗训练; 过滤模

[120]

MACO 模态补全和知识图谱补全协调较差

态噪音

[121] 缓解模态信息不平衡、模态融合不充分以及原始模态

AdaMF-MAT 模态确实场景设置偏离现实; 模态信息使用不充分

使用不高效

[122]

NativE 模态种类繁多, 缓解模态间分布不平衡 对复杂的多模态场景效果不好

多种模态获取更多特征语义; 缓解模态信息冲突; 过滤 对视觉模态信息利用不足; 在多重图像场景下, 模态

MoSE [123]

不相关模态信息; 动态加权不同模态信息 关系矛盾问题依然存在

MyGO [125] 能够捕获多模态细微的、细粒度的语义细节及其交互 不适用更加复杂的多模态场景

捕获不同关系环境下隐藏在模态中的多视角特征; 过滤

[126]

MOMOK 任务场景比较局限; 缺乏对大模型的探索

关系无关的模态信息