Page 232 - 《软件学报》2025年第12期

P. 232

郑修林 等: 知识图谱补全技术及应用 5613

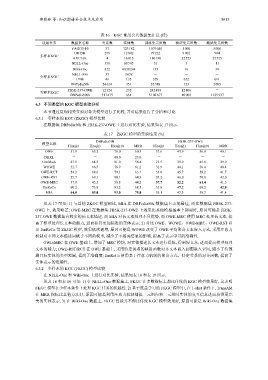

表 16 KGC 常用公共数据集汇总 (续)

适用任务 数据集名称 关系数 实体数 训练集元组数 验证集元组数 测试集元组数

YAGO3-10 37 123 182 1 079 040 5 000 5 000

DB15K 279 12 842 79 222 9 902 904

多样本KGC

KVC16K 4 16 015 180 190 22 523 22 525

NELL-One 358 68 545 51 5 11

Wiki-One 822 4 838 244 133 16 34

NELL-995 37 3 078 - - -

少样本KGC

Umls 46 135 329 652 661

DBPedia50k 24 624 351 32 388 123 2 095

FB5K-237-OWE 12 324 235 242 489 12 806 -

零样本KGC

DBPedia500k 517 475 654 3 102 677 10 000 1 155 937

6.3 不同类型的 KGC 模型实验分析

本节通过复现相关实验对各类模型进行了比较, 并对结果进行了分析和讨论.

6.3.1 零样本的 KGC (ZKGC) 模型比较

在数据集 DBPedia50k 和 FB5K-237-OWE 上进行对比实验, 结果如表 17 所示.

表 17 ZKGC 模型的实验结果 (%)

DBPedia50k FB5K-237-OWE

模型名称

Hits@1 Hits@3 Hits@10 MRR Hits@1 Hits@3 Hits@10 MRR

OWE 51.9 65.2 76.0 60.3 31.6 43.9 56.0 40.1

DKRL - - 40.0 23.0 - - - -

ConMask 47.1 64.5 81.0 58.4 21.5 39.9 45.8 29.9

WOWE 52.7 66.5 76.9 61.2 31.9 44.1 56.4 40.4

OWE-RCT 54.2 68.6 79.1 63.1 33.0 45.7 58.2 41.7

OWE-RST 55.7 69.1 80.1 64.3 33.2 46.0 58.8 42.0

OWE-MRC 37.8 45.5 58.8 44.2 37.7 52.2 61.4 41.5

EmReCo 60.2 73.8 83.2 68.5 33.8 47.2 60.2 42.9

MIA 64.0 83.0 93.0 75.0 35.1 47.3 58.7 41.4

从表 17 可知: 1) 与其他 ZKGC 模型相比, MIA 在 DBPedia50k 数据集上表现最佳, 而在数据集 FB5K-237-

OWE 上, 效果略差; OWE-MRC 在数据集 FB5K-237-OWE 上效果比其他模型基本上都要好, 原因可能是 FB5K-

237-OWE 数据集有较多的长文本描述, 而 MIA 对长文本处理不具优势, 而 OWE-MRC 使用 MRC 处理长文本, 提

高了模型处理长文本的能力, 进而获得更加精准的实体表示; 2) 对比 OWE、WOWE、OWE-MRC、OWE-RST 以

及 EmReCo 等 ZKGC 模型, 效果依次递增, 原因可能是 WOWE 改变了 OWE 平均聚合文本嵌入方式, 采用注意力

机制对不同文本描述词赋予不同的权重, 减少了不相关信息的影响, 提高了表示学习的准确性.

OWE-MRC 在 OWE 基础上, 增加了 MRC 模块, 对实体描述长文本进行提炼, 得到短文本, 进而提高模型处理

文本的能力; OWE-RST/RCT 在 OWE 基础上, 采用特定关系的映射函数对齐文本嵌入到图嵌入空间, 缩小了待预

测目标实体的类型范围, 提高了准确度; EmReCo 使用基于注意力机制的聚合方式、特定关系的对齐函数, 提高了

实体表示的准确性.

6.3.2 少样本的 KGC (FKGC) 模型比较

在 NELL-One 和 Wiki-One 上进行对比实验, 结果如表 18 和表 19 所示.

从表 18 和表 19 可知: 1) 在 NELL-One 数据集上, FKGC 在多数指标上都比传统的 KGC 模型效果好, 这表明

FKGC 模型在少样本条件下处理 KGC 任务的优越性. 2) 基于度量学习的 FKGC 模型中, 在 1-shot 条件下, TransAM

在 MRR 指标比其他方法好, 原因可能是利用注意力机制捕捉三元组内和三元组间实体的交互信息进而获得更完

美的实体表示. 3) 在 Wiki-One 数据上, FKGC 性能并不都比传统 KGC 模型效果好, 原因可能是 Wiki-One 数据集