Page 227 - 《软件学报》2025年第12期

P. 227

5608 软件学报 2025 年第 36 卷第 12 期

应的矩阵 (一个超平面), 基于矩阵相乘执行投影操作实现实体到超平面的映射, 然后在该超平面上执行向量平移

操作. 由于实体在不同语义关系下有不同的语义, 但 TransH 只考虑了一个语义环境, 因此获取的上下文语义不够

丰富, 表现力较弱. 考虑到实体及关系之间存在语义差异, TransR [81] 分别在不同的实体、关系空间中构建实体和关

系的嵌入. 然后, 对实体和关系一一建立映射得到相同实体在不同语义环境中的关系表示. 尽管 TransR 处理复杂

关系表现较好, 但涉及太多额外参数导致对大型 KG 学习的鲁棒性和可扩展性较差. TransD [82] 通过给头尾实体分

配不同的关系映射矩阵来进一步提高 TransR 性能, 并通过矩阵乘法替换为向量乘法以加速计算效率. lppTransD [83]

进一步扩展 TransD, 认为传递性和对称性等关系的逻辑性质不能通过对头部和尾部实体使用相同的投影矩阵来

表示. 与 lppTransD 类似, TransF [84] 用相同的思想分别计算头/尾实体的投影矩阵. 不同的是, TransF 使用独立的矩

阵对投影矩阵建模以减轻关系投影的负担. 相比于 TransR, TransF 具有健壮和轻量级的特点, 可以处理大规模的

KG. 针对 TransE 不灵活, TransM [85] 根据训练集中三元组对优化目标的作用大小为每个三元组分配不同的权重. 充

分利用关系的共享特性, ITransF [86] 使用稀疏注意力机制来发现共享规律来充分捕捉关系和共享概念之间的隐藏

关联. 表 12 总结了基于 Trans 距离的 MKGC 模型.

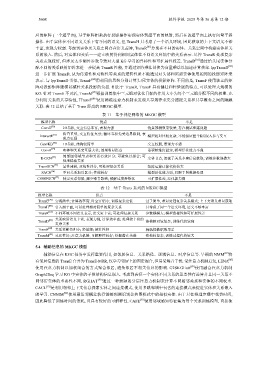

表 11 基于神经网络的 MKGC 模型

模型名称 优点 不足

ConvE [70] 2D卷积, 交互信息丰富, 表现力强 链接预测效果较差; 存在测试泄露问题

检查重塑, 交互特征充分; 循环卷积免受边界限制, 表

InteractE [71] 模型相对比较复杂; 不能保证整个KG嵌入参与交互

现力更强

ConvKB [72] 1D卷积, 结构较简单 交互较弱, 表现力不强

[73]

ConvR 实体和关系交互最大化; 效果明显提高 卷积核维度固定, 模型泛化能力不强

局部图邻域节点和关系有效区分; 可避免过拟合; 可

[74]

R-GCN 实体节点, 忽视了关系本身信息获取; 训练参数规模大

处理稀疏关系

[75]

TransGCN 显性建模, 双线性评分, 可处理复杂关系 矩阵运算计算代价较大

SACN [76] 不同关系加以区分; 性能较好 模型泛化能力弱, 局限于图数据处理

[77]

COMPGCN 特定关系邻居, 减少噪音影响; 缓解过度参数化 可扩展性差, 泛化能力弱

表 12 基于 Trans 系列的 MKGC 模型

模型名称 优点 不足

TransE [79] 实现简单; 计算效率高; 时空开销小; 训练复杂度低 过于简单, 难以处理复杂关系模式; 上下文语义难以获取

TransH [80] 引入超平面, 可以处理相对简单的复杂关系 只考虑了同一个语义环境, 语义不够丰富

TransR [81] 不同环境不同语义表示, 语义更丰富; 可处理复杂关系 参数规模大; 模型鲁棒性和可扩展性差

[82] 关系映射语义丰富, 表现力强, 计算效率高; 处理较丰富的

TransD 结构相对较复杂; 训练代价较高

复杂关系

TransF [84] 关系投影负担小; 轻量级; 健壮性好 稀疏性数据效果差

TransM [85] 灵活性好; 注意力机制; 可解释性较好; 挖掘潜在关联 结构较复杂, 训练过程代价较大

5.4 辅助信息的 MKGC 模型

辅助信息在 KGC 任务中发挥重要作用, 如邻居信息、关系路径、逻辑信息、时序信息等. 早期的 NMM [87] 将

有邻居信息的 TransE 合并为 TransE-MRR, 仅学习邻居上的固定混合, 但易受噪音干扰. 受注意力机制启发, LENA [88]

使用注意力机制以加权组合的方式聚合邻居, 避免邻居不相关信息的影响. G2SKGEatt [89] 使用融合注意力机制

Graph2Seq 学习 KG 中实体的子图结构信息嵌入. 考虑到表征一个实体不同关系的重要性有差异并且同一关系不

同邻居实体的重要性不同, RGHAT [90] 通过一种新颖的分层注意力机制来计算不同相邻关系和实体的不同权重.

CACL [91] 是利用相邻上下文信息探索实体之间连接模式, 使用多跳邻域中包含的连接模式来促进实体和关系嵌入

的学习. CNNIM [92] 使用最近邻概念执行链接预测识别公共图模式中的相似实体. 由于只在推理步骤中花费时间,

因此降低了训练时间的消耗, 且具有较好的可解释性. CAFE [93] 使用邻域感知特征集为每个关系训练模型, 直接使