Page 54 - 《软件学报》2024年第4期

P. 54

1632 软件学报 2024 年第 35 卷第 4 期

策略目标, 其算法在多个任务上的收敛效果显著优于 E-MAML. 为了解决 DDPG 探索较弱的问题, Xu 等人构

建了类似的元探索策略(又称教师策略)并设计其特有的内在奖励函数, 该策略的目标是为 DDPG 的训练采样

优质经验数据 [105] .

还有一些相关工作从其他角度切入: Gupta 等人希望结合不同但结构相似的先前任务的经验来学习探索

策略, 他们提出的算法 MAESN 通过向策略模型注入带有时间相关性的噪声来促使策略进行随机化的探索,

该噪声的利用和采样方式由历史经验和元学习过程共同决定 [106] ; Alet 等人设计了一种元学习的好奇心模块来

为强化学习策略提供每一步的“伪奖励”, 并设计了丰富的面向深度网络的组件用于该模块的元架构搜索 [107] ;

Hu 等人利用任务表征的不确定性引导策略的探索学习 [108] .

总的来说, 目前探索策略的元学习方法较分散, 尚未形成体系和核心方法. 表 6 总结了上述算法的技术特

点和源码链接.

表 6 探索策略元学习算法小结

算法名称 技术特点 源码

E-MAML [103] 分离探索-利用阶段并设计训练目标 https://github.com/episodeyang/e-maml

2

E-RL 2[103] 探索-利用两阶段训练+RL https://github.com/episodeyang/e-maml

MAME [104] 建立单独的探索策略 −

Meta-DDPG [105] 元探索策略改进 DDPG −

MAESN [106] 引入时间相关的元学习策略噪声 −

Meta-Learning Curiosity Algorithms [107] 采用特定语言组成的好奇心模块 https://github.com/mfranzs/meta-learning-curiosity-algorithms

TID [108] 任务表征不确定性引导探索 −

3.2.2 优化目标元学习方法

在深度强化学习中, 尽管已有许多数学推导得到的策略优化目标和更新公式, 如经典的 DQN [23] 和 PG [109]

算法, 但这些算法在实际优化中的稳定性和效果不尽人意, 并有诸多的优化目标改进工作, 其中包括

D3QN [24] , PPO [28] , SAC [29] 等久经考验的优秀算法. 然而, 当前优秀的优化目标均依赖人工实验改进, 缺少理

论指导优化目标改进方向, 并因此很可能存在一些尚未被发现的更优秀的优化目标. 为寻找更好的优化目标,

可以利用深度学习自动优化强化学习的优化目标. 该过程正符合 MAML 框架“学习如何学习”的概念, 即是强

化学习优化目标的元学习.

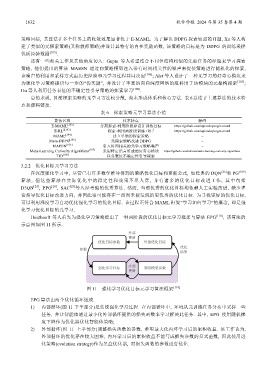

Houthooft 等人首先为强化学习策略提出了一种两阶段的优化目标元学习框架与算法 EPG [110] , 该算法的

示意图如图 11 所示.

图 11 强化学习优化目标元学习算法框架 [110]

EPG 算法由两个优化循环组成.

1) 内部循环(图 11 下半部分)是传统强化学习过程. 在内部循环中, 环境从元训练任务分布中采样一些

任务, 并让智能体通过最小化外部循环提供的损失函数来学习解决此任务. 其中, EPG 使用随机梯

度下降作为优化器优化智能体策略;

2) 外部循环(图 11 上半部分)调整损失函数的参数, 希望最大化内环学习后的累积收益. 该工作认为,

外部循环的优化存在较大困难, 内环学习后的累积收益不能写成损失参数的显式函数, 因此使用进

化策略(evolution strategy)作为黑盒优化器, 对损失函数的参数进行优化.