Page 52 - 《软件学报》2024年第4期

P. 52

1630 软件学报 2024 年第 35 卷第 4 期

在 MAML 的内层更新中模型的线性分类层参数变动较大, 而特征提取层参数变动较小 [91] . Kao 等人更进一步

发现, MAML 算法在内层更新中冻结特征提取层时等同于带噪声的有监督对比学习器, MAML 学习通用特征

表示的能力得益于其内在的对比学习特性, 并给出了理论与实验分析 [92] . 该工作拓宽了对比学习在元学习中

的边界, 本文猜测, 对比学习在元强化学习中的应用还有更多开发潜力, 对比学习有望成为元强化学习的关

键方法, 并可能具备优于 MAML 的泛化能力. 表 4 总结了上述算法的技术特点和源码链接.

表 4 基于对比学习的元策略学习算法小结

算法名称 技术特点 源码

CCM [88] 正负样本按任务类型划分 −

TCL [89] 正负样本按采样轨迹划分 −

DOMINO [90] 互信息分解优化 https://github.com/YaoMarkMu/DOMINO_Mindspore

supervised contrastiveness of MAML [91] 使用带噪对比学习代替 MAML https://github.com/IandRover/MAML_noisy_contrasive_learner

3.1.4 易泛化策略模型的构建方法

在元强化学习中, 一种直观的思路是构建可有效迁移泛化的策略模型. 相比于前述元策略学习方法, 该

类方法利用任务先验知识进行设计, 更加有效且具有可解释性. 相关工作可能不带有“元学习”关键词, 但其

目的、思想与元学习一致.

一种常见思路是构建分层策略模型, 使模型中某些模块功能可跨任务泛化, 从而实现元学习. 已有许多

分层强化学习工作 [93] , 以下仅介绍一些元强化学习代表工作. 在《我的世界》游戏中, Tessler 等人提出的

H-DRLN 算法首先将策略分为顶层策略和技能策略两部分, 其中, 顶层策略可选择自主行动或采用已有技能

策略, 而技能策略可理解为游戏中通用的挖矿、合成、放置等操作, 由半马尔科夫决策过程(semi-Markov

decision process, SMDP)相关工作训练给出 [94] . Lin 等人提出的 JueWu-MC 算法同样将策略分为高层控制策略

和子任务策略, 其额外采用表征学习和自模仿学习加速子任务策略的训练, 最终算法获得遥遥领先的测试分

数 [58] . Fu 等人提出的 MGHRL 算法同样在机械臂模拟环境中将策略分为两部分, 基于 PEARL 框架培训高级元

策略, 并将如何实现子目标的其余部分作为独立的强化学习子任务 [95] . 在导航任务中可构建类似的分层策略

模型, Li 等人提出的 ULTRA 算法将导航策略分为任务上层策略和通用子策略两层, 其中子策略由训练得到

[96] . 为使交互机器人完成各类自然语言任务, Lu 等人将子任务策略(文中称为原子技能)分为 3 种: 导航、问答

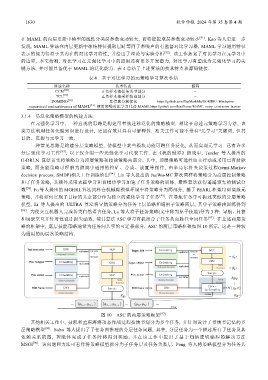

和场景交互并针对性设计损失函数, 使其算法 ASC 学习有机组合子任务从而胜任全局任务 [97] . 在上述两层策

略的框架中, 底层技能策略通常为任务间共享的可迁移部分. ASC 的两层策略框架如图 10 所示, 这是一种较

为通用的两层次策略结构.

图 10 ASC 的两层策略框架 [97]

其他相关工作中, 聂凯和孟庆海将动态作战过程按情节划分为多个任务, 并针对设计了带情节记忆的多

层策略模型 [98] . Sohn 等人提出了子任务图推理的分层任务问题, 其中, 分层任务为一个描述所有子任务及其

依赖关系的图, 智能体完成子任务时将得到奖励, 并在该工作中提出了基于归纳逻辑编程的解决方法

MSGI [99] . 该问题和方法可看作将策略模型拆分为子任务层及任务关系层. Peng 等人将策略模型分为任务共