Page 50 - 《软件学报》2024年第4期

P. 50

1628 软件学报 2024 年第 35 卷第 4 期

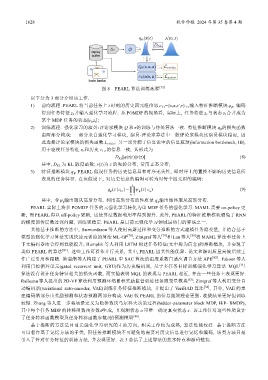

图 8 PEARL 算法训练流程 [32]

以下分为 3 部分介绍该工作.

1) 前向流程. PEARL 将当前任务上 t 时刻的历史四元组信息 c 1:t ={s,a,s′,r} 1:t 输入特征推断模块 q φ , 编码

得到任务特征 z t 并输入强化学习流程. 从 POMDP 的视角看, 实际上, 任务特征 z t 与状态 s t 合并成为

某个 MDP 任务的状态[s t ,z t ];

2) 训练流程. 强化学习的演员-评论家模块 Q 和π的训练与传统算法一致. 特征推断模块 q φ 的损失函数

由两部分构成: 一部分来自强化学习模块, 演员-评论家算法中一般评论家模块比演员模块稳定, 因

此选择评论家模块的损失函数 L critic ; 另一部分源于信息论中的信息瓶颈(information bottleneck, IB),

用于驱使任务特征 z t 和历史 c 1:t 的信息一致, 其形式为

D KL [q(z|c)||r(z)] (8)

其中, D KL 为 KL 散度函数; r(z)为 z 的先验分布, 常用正态分布;

3) 特征推断模块 q φ . PEARL 假设任务的历史信息具有时序无关性, 即时序上的置换不影响历史信息所

表现的任务特征. 在该假设下, 对历史信息的编码可转为对每个四元组的编码:

t

q φ (| z c 1:t ) = ∏ ψ φ (| z c n ) (9)

n= 1

其中, 令ψ φ 输出服从高斯分布, 利用高斯分布的性质使 q φ 输出始终服从高斯分布.

PEARL 实际上将多 POMDP 任务的元强化学习转化为单 MDP 任务的强化学习. MAML 需要 on-policy 更

新, 而 PEARL得以 off-policy 更新, 这使算法数据利用率得到提升. 此外, PEARL 的特征推断模块避免了 RNN

的梯度回传层数过深问题, 训练更稳定. PEARL 是目前元强化学习领域最热门的算法之一.

其他基于推断的方法中, Sæmundsson 等人使用高斯过程和变分推断的方式建模任务隐变量, 并结合基于

模型的强化学习算法实现快速元训练的算法 ML-GP [78] ; Zintgraf 等人 [79] 和 Lan 等人 [80] 将 MAML 算法和任务上

下文编码器结合得到性能提升; Humplik 等人利用 LSTM 构建任务特征(文中称为信念)的推断模块, 并实现了

类似 PEARL 的算法 [81] . 这些工作可看作并行关系, 其中, PEARL 因其性能优异、论文和源码质量高被后续工

作广泛引用和跟随. 陆嘉猷等人构建了 PEARL 中 SAC 算法的温度系数自适应调节方法 APE [82] . Fakoor 等人

利用门控循环单元(gated recurrent unit, GRU)作为历史编码器, 基于多任务目标训练强化学习算法 MQL [33] .

算法没有设计任务特征相关的损失函数, 而实验表明 MQL 的表现与 PEARL 相近, 并在一些任务上表现更好.

Raileanu 等人提出的 PD-VF 算法利用预测环境累积奖励监督训练任务隐变量模块 [83] ; Zintgraf等人利用变分自

动编码器(variational auto-encoder, VAE)训练任务特征推断模块, 并提出了 VariBAD 算法 [34] , 其中, VAE 的重

建编码器部分由奖励预测和状态预测两部分构成. VAE 较 PEARL 的信息瓶颈理论更强、收敛结果更好但训练

较慢. Zhang 等人进一步将场景定义为隐参数块马尔科夫决策过程(hidden-parameter block MDP, HiP- BMDP),

其中每个任务 MDP 的转移函数由参数θ生成, 且观测状态 o 可唯一确定真实状态 s. 该工作针对这些性质设计

了任务转移函数模型及任务转移函数参数θ的预测模型 [84] .

基于推断的方法是目前元强化学习研究的主流方向, 相关工作较为成熟, 算法性能较好. 基于推断方法

可以看作基于记忆方法的子类, 因任务推断模块不可避免地需要对历史信息进行记忆和编码, 该类方法只是

引入了针对任务特征的训练方法, 并表现更好. 表 3 总结了上述算法的技术特点和源码链接.