Page 49 - 《软件学报》2024年第4期

P. 49

陈奕宇 等: 元强化学习研究综述 1627

MAML 和 FO-MAML 提供了收敛性分析 [68] , 并提出了具有与 MAML 相同理论性质的一阶算法 Hessian-free

MAML 以替代 FO-MAML; Khodak 等人在在线凸环境下分析了 MAML 和 Reptile 算法的泛化边界 [69] ; Molybog

和 Lavaei 分析了 MAML 在线性二次控制(linear quadratic regulator, LQR)决策任务集上的全局收敛性 [70] ; Wang

等人建立了具有非凸元目标的 MAML 在强化学习中的全局最优性分析 [71] ; Fallah 等人指出 MAML-RL 的分析

更具挑战性, 构建了随机梯度下降的 MAML-RL 变体算法 SG-MRL 并数学分析 SG-MRL 的收敛性 [72] ; Ji 等人

在监督学习和强化学习两个场景中分析了多步 MAML 在一般非凸条件下的收敛速度和计算复杂性 [73] . 这些

工作提供了 MAML 在强化学习各场景中的理论保障.

总的来说, 基于 MAML 的元强化学习方法具有较强的理论基础和完善的研究脉络, 但相关工作的性能仍

与基于推断和分层的元强化学习方法有一定距离, 因此, 近年来 MAML 多用于二阶求导目标的优化需求而不

是模型泛化性能需求. 表 2 总结了上述算法的技术特点和源码链接.

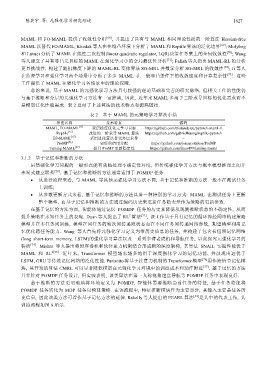

表 2 基于 MAML 的元策略学习算法小结

算法名称 技术特点 源码

MAML, FO-MAML [13] 双层梯度优化元学习目标 https://github.com/tristandeleu/pytorch-maml-rl

Reptile [35] 改进的一阶求导 MAML 算法 https://github.com/gabrielhuang/reptile-pytorch

ES-MAML [65] 采用进化算法替代外层求导 −

ProMP [66] 更好的信用分配 https://github.com/jonasrothfuss/ProMP

Taming MAML [67] 提升 ProMP 更新稳定性 https://github.com/lhao499/taming-maml

3.1.2 基于记忆和推断的方法

虽然强化学习问题的一般形式能有效地处理不确定性环境, 但传统强化学习方法与概率模型推理之间并

未显式建立联系 [20] . 基于记忆和推断的方法通常适用于 POMDP 任务.

• 从运行流程来看, 与 MAML 等其他元强化学习方法不同, 基于记忆和推断的方法一般不在测试任务

上训练;

• 从参数更新方式来看, 基于记忆和推断的方法具备一种特别的学习方式: MAML 在测试任务上更新

整个模型, 而基于记忆和推断的方法通过编码历史来更新任务隐变量作为策略的更新参数.

在基于记忆的方法方面, 智能体通过记忆 POMDP 任务的历史来降低从观测推断状态的不确定性, 从而

2

提升策略在未知任务上的表现. Duan 等人提出了 RL 算法 [51] , 该工作基于具有记忆的循环神经网络构建策略

模型并在多任务间训练, 模型在同任务的轮次间传递隐状态而在不同任务间传递网络参数, 期望模型利用记

忆优化跨任务能力. Wang 等人首先将元强化学习定义为带历史信息的任务, 并构建了包含长短期记忆网络

(long short-term memory, LSTM)的强化学习算法以及一系列多臂老虎机和导航任务, 以此探究元强化学习的

特质 [74] . Mishra 等人提出将时序卷积和软注意力机制结合形成新的深度架构, 其算法 SNAIL 实验性能优于

MAML 和 RL 2[75] . 近年来, Transformer 模型越来越多地用于深度强化学习的记忆功能, 并展现出远优于

LSTM, GRU 等传统记忆网络的泛化性能. Parisotto 将基于注意力机制的 Transformer模型 [76] 用作跨情节记忆模

块, 其开发的算法 CMRL 可以显著降低模型在元强化学习环境中的训练成本和动作时延 [77] . 基于记忆的方法

并非针对 POMDP 任务设计, 但实验表明, 该类算法在第一人称视角迷宫导航等 POMDP 任务中表现良好.

基于推断的方法更明确地将环境定义为 POMDP, 智能体需要推断当前任务的特征, 基于任务特征将

POMDP 任务转化为 MDP 任务以构建策略. 在该流程中, 特征推断模块作为主要部分, 其输入主要是任务历

史信息, 因此该类方法可看作基于记忆方法的延伸. Rakelly 等人提出的 PEARL 算法 [32] 是其中的代表工作, 其

训练流程如图 8 所示.