Page 48 - 《软件学报》2024年第4期

P. 48

1626 软件学报 2024 年第 35 卷第 4 期

问题上的迁移效果或泛化性能. 该部分研究分别对应第 3.4 节的元强化学习结合其他领域和第 3.5 节的元强化

学习算法应用, 其中, 第 3.4 节的相关工作多基于第 3.1 节的元策略学习方法和第 3.2 节的强化学习模块元学

习方法, 与第 3.3 节的元强化学习设定的新问题的结合方面还有待进一步研究.

3.1 元策略学习方法

本节总结并介绍强化学习策略的元学习方法. 策略模块是强化学习智能体端到端模型的核心, 因此训练

元策略的方向最受关注, 其中很多方法也成为其他元强化学习工作的基础. 本节内容按技术路线将现有工作

分为基于 MAML 的方法、基于记忆和推断的方法、基于对比学习的方法、易泛化策略模型的构建方法这 4

个方面展开.

3.1.1 基于 MAML 的方法

模型无关的元学习算法 [13] 是 Finn 等人提出的一种基于元目标梯度优化的元学习方法, 其能够同时适用于

监督学习和强化学习. 该算法的目标是训练任务公共的元参数θ, 使新任务上的初始化模型仅用少量数据就

能实现快速收敛. 这一目标形式化为公式(6). MAML 采用梯度下降的方式优化参数θ, 其优化过程分为两层:

1 ) 内层在每个任务 T i 上迭代任务参 数 θ i , 其中典型的迭代方式为单步 梯

θ α∇

度下降, 即 θ′ = − θ L i T ()θ ; 2) 外层基于内层得到的参数θ i 优化公式(6), 若迭代方式为梯度下降优化, 则:

i

θ′ θ β∇ θ∑ i T ∼ p ()T L θ .

() ′ = −

i T

i

在强化学习中, 内层的损失函数是策略在任务上的期望累积奖励:

L T () θ = − E , T θ R x a t ∑ (7)

( , )

t

T

t

内层损失函数的相关工作由强化学习算法完成, 并使用可微优化器以保留从θ i 到θ的梯度计算图; 外层优

化可使用随机梯度下降(stochastic gradient descent, SGD). MAML 算法用于强化学习中的伪代码如图 7 所示.

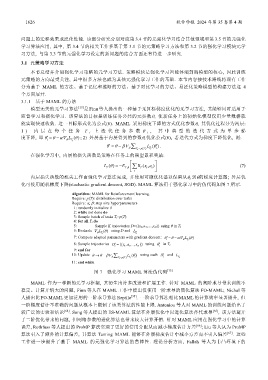

Algorithm: MAML for Reinforcement learning.

Require: p(T): distribution over tasks

Require: α, β: step size hyperparameters

1: randomly initialize θ

2: while not done do

3: Sample batch of tasks T i~p(T)

4: for all T i do

5: Sample K trajectories D={(x 1,a 1,…,x H)} using θ in T i

6: Evaluate ∇ () θ using D and L

θ i T L i T

7: Compute adapted parameters with gradient descent: θ′ = θ α∇− () θ

i θ i T L

1 a

8: Sample trajectories D′ = {(x 1 , ,...,x )} using θ′ in T i

i H i

9: end for

10: Update θ → − β∇ θ∑ i T ∼ p T () i T L ()θ′ using each D′ and L

θ

i T

i

i

11: end while

图 7 强化学习 MAML 算法伪代码 [13]

MAML 作为一种新的元学习框架, 其衍生出许多改进和扩展工作. 针对 MAML 的高阶求导带来训练不

稳定、计算开销大的问题, Finn 等人在 MAML 工作中提出仅使用一阶求导的简化算法 FO-MAML; Nichol 等

人提出比 FO-MAML更加泛用的一阶求导算法 Reptile [35] . 一阶求导算法相比 MAML的计算效率显著提升, 但

一阶梯度估计不准确的问题从根本上限制了该类算法的性能上限. Antoniou 等人对 MAML 的训练问题给出了

较广泛的实验和结论 [64] . Song 等人提出的 ES-MAML 算法在外层优化中以进化算法替代求导 [65] , 该方法避开

了二阶优化带来的问题, 但网络参数的进化算法也带来较大计算开销. 针对 MAML 应用在强化学习中的计算

误差, Rothfuss 等人提出的 ProMP 算法实现了更好的信用分配从而减小梯度估计方差 [66] ; Liu 等人认为 ProMP

算法引入了额外的计算偏差, 其算法 Taming MAML 能够在外层梯度估计中减小方差而不引入偏差 [67] . 这些

工作进一步提升了基于 MAML 的元强化学习算法的鲁棒性. 理论分析方面, Fallah 等人为非凸环境下的