Page 45 - 《软件学报》2024年第4期

P. 45

陈奕宇 等: 元强化学习研究综述 1623

展开研究. 对于域适应 [46] 和域泛化 [47] , 若将强化学习的每个任务看作单独的域, 则域适应对应源任务和目标

任务存在一定差异的迁移强化学习, 而域生成对应源任务和目标任务存在一定差异的元强化学习. 在域生成

的定义中, 模型在有明显域差异的测试任务上直接测试而不进行迭代更新, 这与元强化学习学习元知识的目

标相符, 而与其快速适应新任务的目标有所差异; 除此之外, 结合域生成的强化学习在任务层级上的定义和

元强化学习非常相似, 因此可将结合域生成的强化学习研究看作元强化学习研究的一部分, 后文提到的一些

相关工作即属于该范畴. 上述元强化学习相关领域对比总结见表 1.

表 1 元强化学习相关领域对比

领域名称 源任务数量 训练时目标任务可见 与元强化学习的其他不同

元强化学习 多个 不可见 −

迁移强化学习 不定 可见 −

多任务强化学习 多个 可见 源任务与目标任务相同

连续强化学习 多个 可见 目标任务持续到来

结合域生成的强化学习 不定 可见 任务间存在域差异

结合域泛化的强化学习 多个 不可见 不在目标任务上学习

2.2 场景设置

在元强化学习流程中, 元训练和元测试任务集的每个任务都作为独立的强化学习任务与智能体算法交互

运行. 因此, 元强化学习以强化学习任务为基本单元. 本节介绍已有的元强化学习场景设置, 以便后续对比分

析相关工作.

早期的元强化学习工作大多从状态、动作、奖励函数、转移函数等任务浅层特征入手构建任务. MAML

工作 [13] 在 MuJoCo 机械仿真平台 [48] 上以半猎豹(half-cheetah)和蚂蚁(ant)两个模型作为智能体平台, 设定平台

运动的目标速度不同或目标方向不同, 环境的奖励函数随之改变, 从而作为不同的任务. 与该设定相似, 有工

作 [49] 将模型的一条腿质量或长度改变, 物理环境的状态转移随之改变, 从而获得不同的任务. 该类环境由传

统强化学习环境简单修改得到, 部署方便且易于实验, 因此受到后续工作效仿 [35,36] . Benjamins 等人发布的

CARL 环境集 [50] 整合了一系列经典环境, 如平衡杆和蚂蚁, 并将单环境中的一系列可控参数提取作为任务上

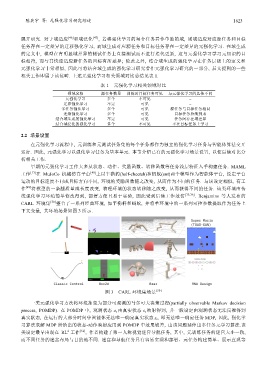

下文变量, 其环境场景如图 3 所示.

图 3 CARL 环境集场景 [50]

一类元强化学习方法将环境抽象为部分可观测的马尔可夫决策过程(partially observable Markov decision

process, POMDP). 在 POMDP 中, 观测状态 o t 由真实状态 s t 映射得到, 并一般设定由观测状态无法反推得到

真实状态, 在运行的大部分时间中智能体无法唯一确定真实状态 s t , 即无法唯一确定任务 MDP, 因此, 强化学

习算法求解 MDP 所给出的状态-动作映射应用到 POMDP 中效果较差, 由该问题延伸出多任务元学习算法.该

2

类设定最早出现在 RL 工作 [51] , 作者构建了第一人称视觉迷宫导航任务, 其中, 元训练任务的迷宫大小一致,

而不同任务的迷宫布局与目的地不同. 迷宫和导航任务具有容易实现和部署、元任务构建简单、展示直观等