Page 53 - 《软件学报》2024年第4期

P. 53

陈奕宇 等: 元强化学习研究综述 1631

享层和任务特有层, 其中, 任务特有层仅为一层神经网络, 并进一步设计适配器模型输出任务特有层参数以

替代传统的梯度下降更新. 该工作采用多任务目标训练, 并在 MuJoCo 环境中取得了超越 PEARL, MAML 和

MQL 的效果 [100] . 本文认为, 该工作的策略模型设计之所以有效, 其原因可能类似第 3.1.3 节所述的 Raghu 等

人 [91] 和 Kao 等人 [92] 关于 MAML算法的发现. Chua等人提出了一种具有理论保证的层次化元强化学习过程 [101] .

总的来说, 根据任务特性设计易泛化的功能模块并迁移是非常实用的思路, 其中以分层策略架构最为常

用. 表 5 总结了上述算法的技术特点和源码链接.

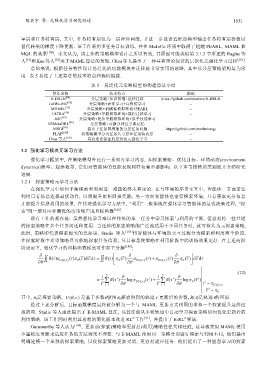

表 5 易泛化元策略模型的构建算法小结

算法名称 技术特点 源码

H-DRLN [94] 分层策略+知识蒸馏+选择迁移 https://github.com/tesslerc/H-DRLN

JueWu-MC [58] 分层策略+表征学习+自模仿学习 −

MGHRL [95] 分层策略+机械臂模拟环境+PEARL −

ULTRA [96] 分层策略+导航模拟环境+课程迁移学习 −

ASC [97] 分层策略+复杂导航模拟环境+原子技能学习 −

HEMetaDRL [98] 分层策略+可微分神经字典记忆 −

MSGI [99] 提出子任务图推理的分层任务问题 https://github.com/srsohn/msgi

FLAP [100] 将策略模型分为任务共享层和任务特有层 −

Chua 等人 [101] 具有理论保证的层次化元强化学习 −

3.2 强化学习模块元学习方法

强化学习框架中, 在策略模型外还有一系列可学习内容, 如探索策略、优化目标、环境动态(environment

dynamics)模型、超参数等, 它们对智能体的性能表现同样有着重要影响. 以下本节按模块类别展开介绍研究

进展.

3.2.1 探索策略元学习方法

在强化学习中如何平衡探索和利用这一难题始终未有定论. 在与环境的序贯交互中, 智能体一方面需要

利用已有信息选择最优动作, 以期提升累积回报奖励; 另一方面智能体也需要探索环境, 只有获取充分信息

才能提升信息利用的效果. 在传统强化学习方法中, “利用”一般体现在强化学习智能体的最优决策过程, “探

索”则一般对应非最优的决策噪声或目标函数 [102] .

现有工作的观点是: 虽然强化学习难以在传统的单一任务中学习探索与利用的平衡, 但容易将一些共通

的探索策略在多个任务间迁移复用. 当迁移的探索策略能广泛地适用于不同任务时, 就可称其为元探索策略,

此时, 策略即代表探索相关的元知识. Stadie 等人 [103] 将智能体与环境的交互过程分为探索和利用两个阶段,

在探索阶段中希望策略尽可能地探索任务信息, 其目标是使策略在利用阶段中的训练效果更好. 在上述两阶

段设定下, 强化学习的目标函数梯度可作如下分解 [103] :

∂ R ()τ π ()τ πτ R ()τ πτ ∂ π ()τ + π ()τ ∂ πτ

( )

( ) d dτ τ

( )d dτ τ =

∂ θ U (, )θτ θ ∫∫ ∫∫ θ ∂ θ U (, )θτ U (, )θτ ∂ θ θ

(12)

1 T R ()τ≈ i ∂ logπ ()τ i 1 ∑ T R ()τ+ ∑ i ∂ logπ ( )τ i

T i= 1 ∂ θ U (, )θτ T i= 1 ∂ θ θ τ i π ∼ U (, )θτ

τ i π ∼ θ

其中, π θ 是探索策略, U (, )θτ 是基于参数θ使用π θ 探索得到的轨迹τ 更新后的参数, R(τ)是轨迹τ的回报.

经过上述分解后, 目标函数梯度最终被分解为一个与 MAML 更新方式相同的项和一个探索提升最终回

报的项. Stadie 等人由此提出了 E-MAML 算法, 该算法能从多轮轨迹中自动学习探索策略如何优化更新后的

2

2

利用策略. 该工作同时利用其思想的简化版本改进 RL 工作 [51] , 并提出了 E-RL 算法.

Gurumurthy 等人认为 [104] , 更新前(探索)策略和更新后(利用)策略往往大相径庭, 这导致类似 MAML 使用

少量梯度更新来适应任务的方法效果不理想. 与 E-MAML 使用同一策略分别进行探索与利用不同, 他们提出

明确建模一个单独的探索策略, 以使探索策略更加灵活, 更容易适应任务. 他们提出了一种监督学习的探索