Page 55 - 《软件学报》2024年第4期

P. 55

陈奕宇 等: 元强化学习研究综述 1633

基于同样的两阶段优化思想, Kirsch 等人为 Actor-Critic 框架的强化学习算法设计了一种可微的神经网络

目标函数 L α (τ,π φ ,V), 其算法 MetaGenRL 因此得以结合 MAML 算法, 来完全基于梯度元训练优化目标预测网

络 [111] . 进一步地, Xu 等人基于 MetaGenRL 将基于值函数和基于策略梯度强化学习算法的优化目标一并设计

为带参可微的网络预测目标 g η (τ) [112] . Zhou 等人基于 off-policyActor-Critic 框架设计了与 Critic 模块并行的

Meta-Critic 模块, 并针对单任务训练设计了 Meta-Critic 的训练方法 [113] . Oh 等人改进利用 LSTM 对历史的动作

和未来预测编码来生成优化目标, 额外的预测输入为其算法 LPG 带来了更强的泛化能力 [114] . 特别地, Veeriah

[1]

等人基于广义值函数(generalized value functions, GVFs) 设计了未来奖励的预测任务作为辅助的优化目标,

并利用 MAML 训练该预测目标参数的生成网络 [115] .

总的来说, 现有工作正致力于优化更加广泛的参数化优化目标, 其中多采用 MAML 算法以优化二阶求导

目标. 表 7 总结了上述算法的技术特点和源码链接.

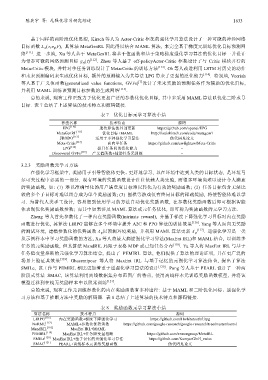

表 7 优化目标元学习算法小结

算法名称 技术特点 源码

EPG [110] 遗传算法的外部更新 https://github.com/openai/EPG

MetaGenRL [111] 优化目标+MAML http://louiskirsch.com/code/metagenrl

FRODO [112] 适用于多种强化学习算法 伪代码见论文

Meta-Critic [113] 面向单任务 https://github.com/zwfightzw/Meta-Critic

LPG [114] 提升任务间的泛化能力 −

Discovered GVFs [115] 广义值函数+辅助任务元训练 −

3.2.3 奖励函数元学习方法

在强化学习框架中, 奖励用于引导智能体更快、更好地学习, 以在环境中达到人类的目标状态, 是环境马

尔可夫过程中必需的一部分. 现有环境的奖励函数设计往往依赖人类先验, 而很多环境尚难以设计令人满意

的奖励函数, 如: (1) 难以准确量化的用户满意度目标难以转化为有效的奖励函数; (2) 任务目标包含无法比

较的多个子目标时难以组合成为单个奖励函数; (3) 围棋等游戏仅有终局目标的稀疏奖励, 将使智能体难以学

习. 为替代人类手工设计, 容易想到使用学习的方法自动优化奖励函数, 在参数化奖励函数后即可根据智能

体表现优化奖励函数参数; 而其中如果涉及 MAML 算法或元任务优化, 即可称为奖励函数的元学习方法.

Zheng 等人首先参数化了一种内在奖励函数(intrinsic reward), 并基于梯度下降强化学习目标对内在奖励

函数进行优化, 其算法 LIRPG 能够在多个环境中提升 A2C 和 PPO 算法的训练效果 [116] . Yang 等人面向无奖励

[117]

的测试环境, 建模参数化的优势函数 A ψ 以预测环境奖励, 并利用 MAML 算法更新 A ψ . 逆强化学习是一类

从示例样本中学习奖励函数的方法, Xu 等人将最大熵逆强化学习算法(MaxEnt IRL)和 MAML 结合, 以训练多

任务的元奖励函数, 但其算法 MandRIL 局限于表格 MDP 或已知任务分布 [118] . Yu 等人将 MaxEnt IRL 与基于

任务隐变量推断的元强化学习算法结合, 提出了 PEMIRL 算法, 他们提供了算法的理论证明, 并在更广泛的

场景上验证其效果 [119] . Ghasemipour 等人将 MaxEnt IRL 与基于记忆的元强化学习算法结合, 提出了算法

SMILe, 该工作与 PEMIRL 相比更加着重于逆强化学习算法的设计 [120] . Pong 等人基于 PEARL 设计了一种两

阶段式算法 SMAC, 该算法利用离线数据集分布范围广的特点, 使用离线样本元训练奖励函数模型, 并将该

模型迁移到在线无奖励样本中以照常训练 [121] .

总的来说, 现有工作元训练参数化的内在奖励函数有多种途径: 基于 MAML 和二阶优化目标、逆强化学

习方法和基于推断方法中奖励的解码器. 表 8 总结了上述算法的技术特点和源码链接.

表 8 奖励函数元学习算法小结

算法名称 技术特点 源码

LIRPG [116] 内在奖励函数+梯度下降强化学习 https://github.com/Hwhitetooth/lirpg

NoRML [117] MAML+参数化优势函数 https://github.com/google-research/google-research/tree/master/norml

MandRIL [118] MaxEnt IRL+MAML −

PEMIRL [119] MaxEnt IRL+任务隐变量推断 https://github.com/ermongroup/MetaIRL

SMILe [120] MaxEnt IRL+基于记忆的元强化学习算法 https://github.com/KamyarGh/rl_swiss

SMAC [121] PEARL+离线样本元训练奖励函数 伪代码见论文