Page 57 - 《软件学报》2024年第4期

P. 57

陈奕宇 等: 元强化学习研究综述 1635

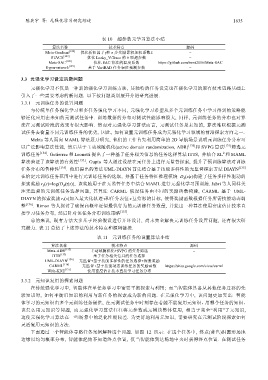

表 10 超参数元学习算法小结

算法名称 技术特点 源码

Meta-Gradient [126] 优化折扣因子g和 n 步奖励累积加权系数λ −

STACX [127] 优化 Leaky_V-Trace 的 6 项超参数 −

Meta-SAC [128] 优化 SAC 算法的温度系数 https://github.com/twni2016/Meta-SAC

Hypernetwork [129] 基于 VariBAD 任务表征预测参数 −

3.3 元强化学习设定的新问题

元强化学习不仅是一种新的强化学习训练方法, 其独特的任务设定也在强化学习的原有技术思路基础上

引入了一些需要考虑的新问题. 以下按问题类别展开介绍研究进展.

3.3.1 元训练任务的设置问题

与传统单任务强化学习和多任务强化学习不同, 元强化学习希望从多个元训练任务中学习得到的策略能

够泛化应用在未知的元测试任务中. 训练数据的分布对测试性能影响很大, 同样, 元训练任务的分布也对算

法在元测试阶段的效果有很大影响. 然而对元强化学习算法而言, 元测试任务是未知的, 算法难以根据元测

试任务去衡量不同元训练任务的优劣, 因此, 如何设置元训练任务成为元强化学习领域的前沿探索方向之一.

Mehta 等人面向 MAML 算法展开研究, 他们的工作首先利用简单的 2D 导航场景说明元训练任务分布可

以广泛影响算法性能, 然后基于主动域随机化(active domain randomization, ADR) [130] 和 SVPG 算法 [131] 筛选元

2

训练任务 [132] . Gutierrez 和 Leonetti 提出了一种基于任务相关信息的任务选择算法 ITTS, 并结合 RL 和 MAML

算法验证了该算法的有效性 [133] . Gupta 等人通过设法在元任务上进行无监督探索, 提升了预训练算法对训练

任务分布的鲁棒性 [134] . 他们提出的算法 UML-DIAYN 首先结合基于技能多样性的无监督探索方法 DIAYN [135]

在给定元训练任务范围中进行元训练任务的选取, 并基于任务特征推理模块 D φ (z|s)构建了任务多样性驱动的

探索奖励 r z (s)=log(D φ (z|s)), 该奖励用于在无监督任务中结合 MAML 进行元强化学习预训练. Jabri 等人同样关

注无监督的元训练任务选择问题, 其算法 CARML 假设任务由不同的奖励函数构建, CARML 基于 UML-

DIAYN 的探索奖励 r z (s)加入最大化轨迹τ和任务表征 z 互信息的目标, 使得奖励函数根据任务所需技能动态调

整 [136] . Rimon 等人探讨了确保高概率近似最优行为的元训练任务数量, 并提出一种算法使用密度估计技术直

接学习任务分布, 然后针对该任务分布训练策略 [137] .

总的来说, 现有方法大多基于经验假设进行开环设计, 尚未完全解决元训练任务设置问题, 还有很大研

究潜力. 表 11 总结了上述算法的技术特点和源码链接.

表 11 元训练任务的设置算法小结

算法名称 技术特点 源码

Meta-ADR [132] 主动域随机化+SVPG 的任务筛选 −

ITTS [133] 基于任务相关信息的任务选择 −

UML-DIAYN [134] 无监督+基于技能多样性的任务选择+探索奖励 −

CARML [136] 无监督+基于技能动态训练任务的奖励函数 https://sites.google.com/view/carml

With-KDE [137] 使用密度估计技术直接学习任务分布 −

3.3.2 元知识复用的探索问题

在传统强化学习中, 智能体在单任务学习中需要平衡探索与利用; 而当智能体具备从其他任务迁移的先

验知识时, 如何平衡旧知识的利用与新任务的探索成为新的问题. 在元强化学习中, 该问题更加突出: 智能

体学习的元知识由多个元训练任务提供, 在元测试任务中时刻存在着能不能复用元知识、用哪个任务的知识、

该怎么用元知识等问题, 而元强化学习算法往往将元参数或元模块整体复用, 相当于完全“利用”了元知识,

这使元强化学习算法在一些场景中的泛化性能较差. 为更好地利用元知识, 需要研究在元测试阶段探索如何

灵活复用元知识的方法.

下面通过一个智能体寻路任务案例解释这个问题. 如图 12 所示: 在这个任务中, 终点(蓝色)沿圆形场地

边缘以均匀概率分布, 智能体起始不知道终点位置, 仅当智能体到达场地中央时获得终点位置. 在测试任务