Page 62 - 《软件学报》2024年第4期

P. 62

1640 软件学报 2024 年第 35 卷第 4 期

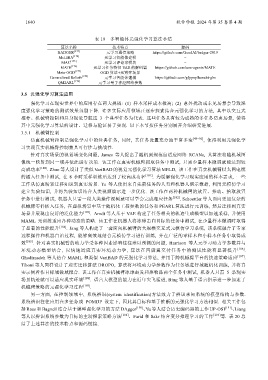

表 19 多智能体元强化学习算法小结

算法名称 技术特点 源码

BADGER [173] 元学习通信策略 https://github.com/GoodAI/badger-2019

MeLIBA [174] 元学习智能体建模 −

MAC [175] 元学习评论家模块 −

MATE [176] 元学习任务特征 VAE 的解码器 https://github.com/uoe-agents/MATE

Meta-OGD [177] OGD 算法+元博弈场景 −

Generalized Beliefs [178] 元学习智能体建模 https://github.com/gfppoy/hanabi-gbs

QM2ARL [179] 元学习量子神经网络参数 −

3.5 元强化学习算法应用

强化学习在现实世界中的应用存在两大挑战: (1) 样本采样成本极高; (2) 意外扰动或未见场景会导致深

度强化学习策略的测试效果急剧下降. 许多实际应用领域正逐步探索结合元强化学习的方法, 其中以交互式

推荐、机械臂控制和具身视觉导航这 3 个典型任务为代表. 这些任务具有较为成熟的多任务仿真场景, 使得

其中元强化学习算法的设计、迁移与验证易于实现. 以下本节按任务分别展开介绍研究进展.

3.5.1 机械臂控制

仿真机械臂控制是强化学习中的经典任务, 同时, 其任务设置充分地丰富多变 [48−50] , 使得利用元强化学

习实现真实机械臂控制兼具可行性与挑战性.

针对真实场景的视觉域变化问题, James 等人提出了随机到规范自适应网络 RCANs, 其算法将随机域图

像统一映射到同一域并依此进行决策. 该工作在真实机械臂抓取任务中测试, 只需少量样本微调就能达到较

高成功率 [180] . Zhao 等人设计了类似 VariBAD 的视觉元强化学习算法 MELD, 该工作在真实机械臂以太网电缆

的插入任务中测试, 在 8 小时采样训练后达到了较高成功率 [181] . 为缓解强化学习现实应用的样本需求, 一些

工作从仿真场景迁移知识到真实场景. Yu 等人使用来自先前任务的人类和机器人演示数据, 利用元模仿学习

建立先验知识, 并将先验知识结合人类视频演示进一步优化. 该工作在两种机械臂的放置、推动、拾取放置

任务中进行测试, 机器人只需一段人类操作视频就可以学会完成相应任务 [182] . Schoettler 等人面向更加复杂的

机械臂零件插入任务, 在虚拟场景中基于随机化工程参数的任务和 PEARL 算法进行元训练, 然后迁移到真实

场景并展现出良好的泛化能力 [183] . Arndt 等人基于 VAE 构建了任务相关的轨迹生成模型以加速采样, 并使用

MAML 元训练适应各种动态的策略. 该工作在机器人将冰球击向目标的任务中测试, 在少量样本微调时取得

了显著的性能提升 [184] . Jang 等人构建了一套面向机械臂的大规模交互式元模仿学习系统, 该系统融合了专家

远程操作和机器自治过程, 能够高效地结合元模仿学习进行训练, 并在广泛的零样本和小样本任务中取得成

效 [185] . 针对真实机械臂的动力学受各种因素影响往往难以预测的问题, Harrison 等人元学习动力学参数并与

环境动态模型结合, 以快速适应真实环境动力学, 算法在四旋翼交付任务中的测试性能有显著提升 [186] .

Ghadirzadeh 等人结合 MAML 和类似 VariBAD 的元强化学习算法, 并用于跨机械臂平台的快速策略适应 [187] .

Tiboni 等人同样设计了虚实迁移算法 DROPO, 算法将环境动力学参数作为任务域进行域随机化训练, 并将真

实示例看作目标域做域拟合. 该工作在真实机械臂冰球击发和推物品两个任务中测试, 机器人只需 5 条现实

场景轨迹就可以适应现实环境 [188] . 语言大模型的能力在近年突飞猛进, Bing 等人基于语言指示进一步加速了

机械臂策略的元强化学习过程 [189] .

另一方面, 在控制领域中, 系统辨识(system identification)方法致力于辨识未知系统的模型结构与参数.

系统辨识往往应用在多任务或 POMDP 设定下, 因此其目标和基于推断的元强化学习方法相似. 相关工作包

括 Ross 和 Bagnell 结合基于模型强化学习的方法 DAgger [190] 、Yu 等人结合历史编码器的工作 UP-OSI [191] 、Liang

等人以辨识系统参数为目标的主动探索策略方法 [192] 、Farid 和 Sakr 结合变分推理学习的工作 [193] 等. 表 20 总

结了上述算法的技术特点和源码链接.