Page 64 - 《软件学报》2024年第4期

P. 64

1642 软件学报 2024 年第 35 卷第 4 期

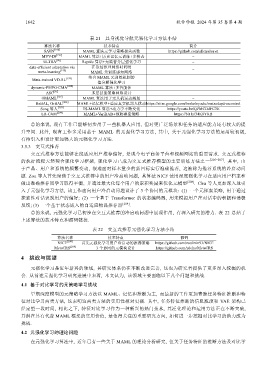

表 21 具身视觉导航元强化学习方法小结

算法名称 技术特点 简介

SAVN [196] MAML 算法元学习策略损失函数 https://github.com/allenai/savn

MVV-IN [197] MAML 算法+历史记忆元训练+多模态 −

ULTRA [96] Reptile 算法+无监督分层强化学习 −

data-efficient adaptation via 在冻结推理网络时利用

meta-learning [198] MAML 元训练感知网络 −

Meta-trained VD-RL [199] 结合 MAML 元训练机制的 −

值分解强化学习

dynamic-PMPO-CMA [200] MAML 算法+多智能体 −

ASC [97] 多层技能策略网络设计 −

OMAML [201] MAML 算法用于无人机运动规划 −

ReBAL, GrBAL [202] MAML+记忆模型+适应真实机器人扰动 https://sites.google.com/berkeley.edu/metaadaptivecontrol

Song 等人 [203] ES-MAML 算法+动力学不断变化 https://youtu.be/QPMCDdFC3E

LR-CAM [204] MAML+VariBAD+预防碰撞策略 https://bit.ly/34K8YKB

总的来说, 现有工作已能够初步用于一些机器人应用, 但对更广泛场景和任务的适应能力还有较大的提

升空间. 此外, 现有工作多采用基于 MAML 的元强化学习方法, 其中, 关于元强化学习方法的运用较初级,

有待引入和设计更加强大的元强化学习方法.

3.5.3 交互式推荐

交互式推荐方法能够在线适应用户推荐偏好, 是现今电子商务平台和视频网站的重要需求. 交互式推荐

的执行流程天然契合强化学习框架, 强化学习已成为交互式推荐模型的主要训练方法之一 [205−207] . 其中, 由

于产品、用户和系统的频繁变动, 很难面对样本量少的新目标实行准确推荐, 这被称为推荐系统的冷启动问

题. Zou 等人首先聚焦于交互式推荐中的用户冷启动问题, 其算法 NICF 使用深度强化学习在适应用户档案和

做出准确推荐间学习取得平衡, 并通过最大化每个用户的累积奖励来优化元模型 [208] . Chu 等人更加深入地引

入了元强化学习方法, 该工作面向用户冷启动问题设计了 3 个协同的元模块: (1) 一个元探索策略, 用于通过

探索性对话识别用户的偏好; (2) 一个基于 Transformer 的状态编码器, 用来模拟用户在对话中的积极和消极

反馈; (3) 一个基于状态嵌入的自适应物品推荐器 [209] .

总的来说, 元强化学习已初步在交互式推荐的冷启动问题中展现作用, 有深入研究的潜力. 表 22 总结了

上述算法的技术特点和源码链接.

表 22 交互式推荐元强化学习方法小结

算法名称 技术特点 源码

NICF [208] 首先元强化学习用户冷启动的推荐策略 https://github.com/zoulixin93/NICF

MetaCRS [209] 3 个协同的元模块设计 https://github.com/zdchu/MetaCRS

4 挑战与展望

元强化学习是近年新兴的领域, 其研究体系仍在不断改进完善, 这也为研究者提供了更多深入挖掘的机

会. 从前述元强化学习研究进展中来看, 本文认为, 该领域主要面临以下几个问题和挑战.

4.1 基于对比学习的元策略学习挑战

早期深度模型的元策略学习方法以 MAML、记忆和推断为主, 而最新的工作更加青睐任务特征推断和特

征对比学习两类方法, 这表明这两类方法的实用性相对更强. 其中, 任务特征推断的信息瓶颈和 VAE 架构已

经定型一段时间, 相比之下, 特征对比学习作为一种新兴的热门技术, 其泛化理论和运用方法正在不断突破,

并潜在具有代替 MAML 框架的实用价值, 是值得关注的重要研究方向, 如何进一步挖掘对比学习的潜力成为

挑战.

4.2 元强化学习的理论问题

在元强化学习算法中, 近年已有一些关于 MAML 的理论分析研究, 但关于任务特征的推断方法及对比学