Page 63 - 《软件学报》2024年第4期

P. 63

陈奕宇 等: 元强化学习研究综述 1641

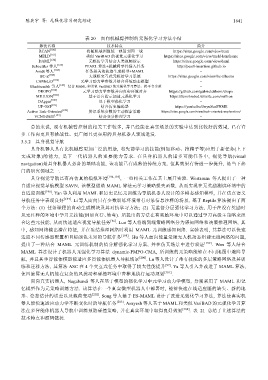

表 20 面向机械臂控制的元强化学习方法小结

算法名称 技术特点 简介

RCAN [180] 将随机域图像统一映射到同一域 https://sites.google.com/view/rcan

MELD [181] 类似 VariBAD 的视觉元强化学习 https://sites.google.com/view/meld-lsm/home

DAML [182] 元模仿学习结合人类视频演示 https://sites.google.com/view/daml

Schoettler 等人 [183] PEARL 算法+机械臂零件插入任务 http://pearl-insertion.github.io

Arndt 等人 [184] 任务相关的轨迹生成模型+MAML −

BC-Z [185] 大规模交互式元模仿学习系统 https://sites.google.com/view/bc-z/home

CAMeLiD [186] 元学习动力学参数并结合环境动态模型 −

Ghadirzadeh 等人 [187] 结合 MAML 和类似 VariBAD 的元强化学习算法、跨平台实验 −

DROPO [188] 元学习动力学参数并向真实环境对齐 https://github.com/gabrieletiboni/dropo

MILLION [189] 基于语言指示加速元强化学习 https://tumi6robot.wixsite.com/million

DAgger [190] 基于模型强化学习 −

UP-OSI [191] 结合历史编码器 https://youtu.be/dwyuScnPNME

Active Task-Oriented [192] 辨识系统参数的主动探索策略 https://sites.google.com/view/task-oriented-exploration/

VCNODETI [193] 结合变分推理学习 −

总的来说, 现有机械臂控制的相关工作较多, 并已经能在真实场景的实验中达到比较好的效果, 已有许

多工作向更具有挑战性、更广阔且更实用的具身机器人领域进发.

3.5.2 具身视觉导航

具身机器人具有比机械臂更加广泛的用途, 将先前学习的技能(例如移动、推箱子等)应用于新任务(上下

文或对象)的能力, 是下一代机器人的重要能力需求. 在具身机器人的诸多可能任务中, 视觉导航(visual

navigation)是具身机器人必备的基础功能, 该功能已有成熟的传统方案, 但其效果有待进一步提升, 是当下热

门的研究领域之一.

具身视觉导航已有高仿真的模拟环境 [194,195] , 一些相关工作在其上展开实验. Wortsman 等人提出了一种

自适应视觉导航模型 SAVN, 该模型借助 MAML 算法元学习策略损失函数, 从而实现在无奖励测试环境中的

自适应训练 [196] . Yan 等人利用 MAML 和历史记忆元训练为导航机器人设计的多模态感知模型, 并在仿真语义

导航任务中表现良好 [197] . Li 等人面向只有少数训练环境带有对象信息注释的场景, 基于 Reptile 算法提出了两

个方法: (1) 任务课程的自动生成模块及其对抗学习方法; (2) 无监督分层强化学习方法, 用于在没有奖励时

从无注释的环境中学习元技能(例如直行、转弯). 所提出的方法在有奖励环境中可以通过学习高级主策略来组

合这些元技能, 从而快速适应视觉导航任务 [96] . Luo 等人将端到端策略网络分为感知网络和决策推理网络, 其

中, 感知网络输出潜在特征, 并在冻结推理网络时利用 MAML 元训练感知网络. 实验表明, 其算法可以快速

适应不同传感器配置和目标颜色未知的导航任务 [198] . Hu 等人面向能量受限无人机动态组建无线网络的问题,

提出了一种结合 MAML 元训练机制的值分解强化学习方案, 并在仿真场景中进行验证 [199] . Wen 等人结合

MAML 算法设计了机器人元强化学习算法 dynamic-PMPO-CMA, 所训练的元策略能够在不同地图中避障导

航, 并且其单智能体模型能适应多智能体机器人导航场景 [200] . Lu 等人设计了带有技能的多层策略网络及其训

练和迁移方法, 其算法 ASC 在 4 个交互式任务中取得了较大性能提升 [97] . Yu 等人引入并改进了 MAML 算法,

使四旋翼无人机能在复杂的风扰动和碰撞环境中鲁棒地执行运动规划 [201] .

面向真实机器人, Nagabandi 等人在基于模型的强化学习中元学习动力学模型, 分别采用了 MAML 和记

忆模型作为元策略训练方法. 该算法在一个真实微型机器人中部署时, 能够快速在线适应腿的缺失、新的地

形、姿态估计的误差以及载荷变动 [202] . Song 等人基于 ES-MAML 设计了改进元强化学习算法, 算法使真实机

器人能快速适应动力学不断变化时的导航任务 [203] . Asayesh 等人基于 MAML 和类似 VariBAD 的元强化学习算

法在多智能体机器人导航中训练预防碰撞策略, 并在真实环境中取得良好效果 [204] . 表 21 总结了上述算法的

技术特点和源码链接.