Page 59 - 《软件学报》2024年第4期

P. 59

陈奕宇 等: 元强化学习研究综述 1637

2

一致性, 发现 MAML 是一种理论一致的算法并通常可以适应分布外任务, 然后将 RL 和 VariBAD 算法改进为

理论一致性算法并在实验中取得良好的泛化性能 [142] . Fu 等人针对孤立任务在 MAML 框架中难以学习导致任

务泛化差的问题, 将任务分类为子集并基于子集开展训练 [143] . Wang 等人基于任务推断的元强化学习方法, 使

用高斯混合空间作为任务表征以适应更广泛的任务变化 [144] .

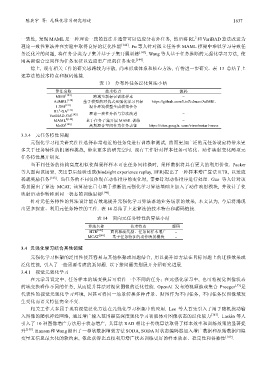

综上, 现有相关工作的研究思路较为零散, 尚未形成体系和核心方法, 有待进一步研究. 表 13 总结了上

述算法的技术特点和源码链接.

表 13 分布外任务泛化算法小结

算法名称 技术特点 源码

MIER [124] 跨域重新标记训练样本 −

AdMRL [140] 基于模型的对抗式元强化学习目标 https://github.com/LinZichuan/AdMRL

LDM [141] 混合环境模型生成模拟任务 −

2

RL -GA [142]

VariBAD-GA [142] 理论一致性分析与算法改进 −

MAML 2[143] 基于任务子集开展 MAML 训练 −

MoSS [144] 高斯混合空间作为任务表征 https://sites.google. com/view/metarl-moss

3.3.4 元任务特性问题

元强化学习相关研究往往选择非常相近的任务集进行训练和测试, 然而更加广泛的元任务设定将带来更

多关于任务特性的机遇和挑战, 带来更多的研究空间. 现有工作针对样本任务可转化、动作映射变化两项元

任务特性展开研究.

当不同任务的结构高度相似使得采样样本可在任务间转换时, 采样数据将具有更大的利用价值. Packer

等人面向该场景, 类比事后经验重放(hindsight experience replay, HER)提出了一种样本增广算法 HTR, 以适应

稀疏奖励任务 [145] . 当任务的不同仅体现在动作排序的变化时, 需要针对动作排序进行处理. Guo 等人针对该

场景提出了算法 MCAT, 该算法在已有基于推断的元强化学习算法基础上加入了动作映射模块, 并设计了使

映射后动作转移到同一状态的训练目标 [146] .

针对元任务特性的算法设计能有效地提升元强化学习算法落地业务场景的效果, 本文认为, 今后将涌现

出更多探索、利用元任务特性的工作. 表 14 总结了上述算法的技术特点和源码链接.

表 14 面向元任务特性的算法小结

算法名称 技术特点 源码

HTR [145] 面向稀疏奖励、任务间样本增广 −

MCAT [146] 基于任务特征的动作映射模块 −

3.4 元强化学习结合其他领域

元强化学习框架的泛用性使其容易与其他框架或问题结合, 用以提升原方法在目标问题上的迁移效果或

泛化性能, 引入了一些需要考虑的新问题. 以下按问题类别展开介绍研究进展.

3.4.1 视觉元强化学习

在元学习设定中, 任务样本的域变换后可看作一个不同的任务; 在元强化学习中, 也可将视觉图像状态

的域变换看作不同的任务, 从而提升算法对视觉图像的泛化性能. OpenAI 发布的视频游戏集合 Procgen [55] 是

代表性的视觉元强化学习环境, 因其可将同一场景转换多种背景、贴图作为不同任务, 不同任务仅图像域发

生变化而语义特征完全不变.

相关工作大多属于现有视觉泛化方法在元强化学习框架中的应用. Lee 等人首先引入了用于随机扰动输

入图像的随机神经网络, 通过增广输入范围提高深度强化学习智能体对图像状态的泛化能力 [147] . Laskin 等人

引入了 10 种图像增广方法用于状态增广, 其算法 RAD 相比于传统算法取得了样本效率和训练效果的显著提

升 [148] . Hansen 和 Wang 提出了一种软数据增强方法 SODA, SODA 对状态编码器加入增广数据和原始数据间隐

变量互信息最大化的软约束, 依此获得比直接利用增广状态训练更好的样本效率、稳定性和鲁棒性 [149] .