Page 56 - 《软件学报》2024年第4期

P. 56

1634 软件学报 2024 年第 35 卷第 4 期

3.2.4 环境动态模型元学习方法

在已知环境的动态模型, 即状态转移函数 T:S×A×S→[0,1]时, 基于搜索的算法(如蒙特卡洛树搜索)和基于

模型的强化学习算法(model-basedreinforcement learning)可以利用环境动态模型进行模拟的环境交互, 从而大

幅减少强化学习训练所需的交互样本与训练时间, 提升智能体的学习效率. 但除围棋等已知全部规则的游戏

环境之外, 大部分贴近现实环境的动态模型复杂程度极高, 如何构建准确可用的环境动态模型成为相关研究

领域的挑战. 已有许多基于模型的强化学习算法研究环境动态模型的构建问题 [122] , 其中, MAML 算法可以解

决从优化目标到待优化参数的二阶梯度优化问题, 元任务优化方法可以提升所建立动态模型的任务泛化性

能, 涉及 MAML 算法或元任务优化的方法即可称为环境动态模型的元学习方法.

Clavera 等人基于 MAML 元训练环境动态模型并将其用于生成虚拟交互样本, 其算法 MB-MPO 在高维复

杂四足运动机器人上仅需 2 小时就完成训练 [123] . Mendonca 等人基于历史隐变量的元强化学习构建算法 MIER,

利用 MAML 与环境动态预测目标对隐变量编码模型进行元训练, 为提升深度模型的泛化能力, 该工作进一步

提出了一种经验重新标记算法来提供分布外任务的大量训练样本 [124] . 近年强化学习相关工作表明, 利用编码

[9]

后状态替代原始状态进行动态模型的拟合具有更泛用的潜力 . Lee 等人利用历史隐变量构建环境动态模型,

其算法 CaDM 在各类控制任务中表现出优异的泛化能力 [49] . Wang 和 Hoof 构建了一种图结构的代理模型

GSSM, 以在隐空间编码任务特征, 利用任务特征构建环境动态模型, 并设计了一种元策略的快速更新方法

APS 以训练整套模型 [125] .

总的来说, 现有工作元训练环境动态模型有两种途径: 基于元策略学习方法训练带环境动态模型的策

略、或基于任务表征重建环境动态; 根据任务特性决定环境动态参数是自然而高效的. 表 9 总结了上述算法

的技术特点和源码链接.

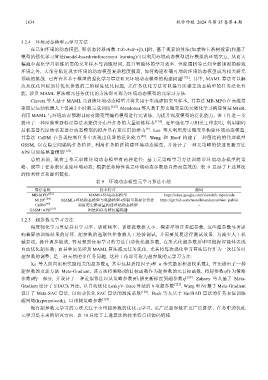

表 9 环境动态模型元学习算法小结

算法名称 技术特点 源码

MB-MPO [123] MAML+环境动态模型 https://sites.google.com/view/mb-mpo/code

MIER [124] MAML+环境动态模型与奖励模型+经验重新标记算法 https://github.com/russellmendonca/mier_public

CaDM [49] 利用历史隐变量构建环境动态模型 −

GSSM+APS [125] 图结构任务特征编码器 −

3.2.5 超参数元学习方法

深度强化学习算法具有学习率、训练频率、训练批数据大小、探索率等许多超参数, 这些超参数显著影

响着算法训练结果的好坏. 超参数的选取往往依赖人工经验调试, 并需要反复运行测试效果. 为减少人工机

械劳动, 提升调参能效, 容易想到使用学习的方法自动优化超参数, 在形式化超参数后即可根据智能体表现

自动优化超参数; 而其中如果涉及 MAML 算法或元任务优化, 尤其将每次强化学习算法运行作为一次任务时

超参数的调整, 是一种天然的多任务问题, 这种工作即可称为超参数的元学习方法.

Xu 等人面向累积奖励相关的超参数η, 其中包括折扣因子g和 n 步奖励累积加权系数λ, 首先提出了一种

超参数的更新方法 Meta-Gradient, 该方法将策略θ的目标函数作为超参数的元目标函数, 将超参数η作为策略

参数θ的一部分, 并设计了一种近似算法以从策略参数θ传播更新梯度到超参数η [126] . Zahavy 等人基于 Meta-

Gradient 设计了 STACX 算法, 以自动优化 LeakyV-Trace 算法的 6 项超参数 [127] . Wang 和 Ni 基于 Meta-Gradient

设计了 Meta-SAC 算法, 以自动优化 SAC 算法的温度系数 [128] . Beck 等人基于 VariBAD 算法的任务表征训练

超网络(hypernetwork), 以预测策略参数 [129] .

现有超参数元学习的方法关注于少量超参数的优化元学习, 更广泛超参数在更广泛算法、任务中的优化

元学习是未来的研究方向. 表 10 总结了上述算法的技术特点和源码链接.