Page 58 - 《软件学报》2024年第4期

P. 58

1636 软件学报 2024 年第 35 卷第 4 期

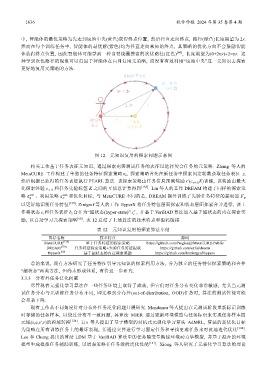

中, 智能体的最优策略为先走到场地中央(黄色)获得终点位置, 然后径直走向终点, 路径(绿色)长度期望为 2r.

然而在每个训练任务中, 智能体的最优解(紫色)均为径直走向未知的终点, 其策略的优化方向不会鼓励智能

体获得终点位置, 因此智能体可能学到一种贪婪绕圈搜索的次优路径(红色) [60] , 长度期望为(0+2πr)÷2=πr. 这

种学到次优路径的现象可以归因于智能体在盲目复用元策略, 而没有有效利用“场地中央”这一元知识去探索

更好地复用元策略的方法.

图 12 元知识复用的探索问题示意图

相关工作基于任务表征元知识, 通过探索完善测试任务的表征以选择契合任务的元策略. Zhang 等人的

MetaCURE 工作构建了单独的任务特征探索策略π e , 探索策略首先在新任务中探索固定轮数获取任务表征 z,

然后根据已获得的任务表征执行 PEARL 算法. 该探索策略由任务信息预测奖励 r′(c :t+1 ,K)训练, 该奖励由最大

化探索经验 c :t+1 和任务先验标签 K 之间的互信息计算得到 [138] . Liu 等人的工作 DREAM 构建了同样的探索策

略 π φ exp 、利用策略 π θ task 和优化目标, 与 MetaCURE 不同的是, DREAM 额外训练了先验任务特征的提取器 F ψ

以更好地识别任务特征 [139] . Zintgraf 等人的工作 HyperX 将任务特征层面探索和状态层面探索合并进行, 该工

+

作将状态 s t 和任务表征 b t 合并为“超状态(hyper-state)” s , 并基于 VariBAD 算法加入基于超状态的内在探索奖

t

励, 以自动学习元探索策略 [60] . 表 12 总结了上述算法的技术特点和源码链接.

表 12 元知识复用的探索算法小结

算法名称 技术特点 源码

MetaCURE [138] 基于任务特征的探索策略 https://github.com/NagisaZj/MetaCURE-Public

DREAM [139] 任务特征探索策略+先验任务特征提取 https://github.com/ezliu/dream

HyperX [60] 基于超状态的内在探索奖励 https://github.com/lmzintgraf/hyperx

总的来说, 现有方法研究了任务特征引导元知识的探索利用方法, 分为独立的任务特征探索策略和合并

“超状态”两类方法, 但尚未形成体系, 有待进一步研究.

3.3.3 分布外任务泛化问题

尽管现有元强化学习算法在一些任务环境上取得了成效, 但它们对任务分布变化非常敏感, 尤其当元测

试任务分布与元训练任务分布不同, 即迁移到分布外(out-of-distribution, OOD)任务时, 算法的测试性能可能

会显著下降.

现有工作从不同角度针对分布外任务泛化问题开展研究. Mendonca 等人提出在元测试阶段重新标记训练

时存储的任务样本, 以绕过分布不一致问题, 其算法 MIER 通过更新环境模型与任务标识来实现任务样本四

元组(s,a,s′,r)的跨域转换 [124] . Lin 等人提出了基于模型的对抗式元强化学习算法 AdMRL, 算法的新优化目标

为策略在所有训练任务上的最坏表现, 并通过交替进行学习固定任务和寻找更难任务来对抗地迭代优化 [140] .

Lee 和 Chung 提出的算法 LDM 基于 VariBAD 算法中的任务隐变量构建环境动力学模型, 并基于混合的环境

模型生成模拟任务辅助训练, 以增强策略在任务级的泛化性能 [141] . Xiong 等人研究了元强化学习算法的理论