Page 272 - 《软件学报》2025年第4期

P. 272

1678 软件学报 2025 年第 36 卷第 4 期

例. Chen 等人 [57] 除了调用 GPT-3.5-Turbo 直接生成实体外, 还调用了更先进的 GPT-4, 通过输入图片和文本的方

式直接生成实体. 该模型被命名为 GPT4. 各个基于大模型直接生成的方法在数据集 Twitter2015 和 Twitter2017 上

的表现如表 5 和表 6 所示, 虽然直接调用 GPT-3.5-Turbo 或者更先进的 GPT-4 接口来生成结果更方便, 但是与其

他先进模型 (如: 序列标注模型) 相比, 其结果 (F1 值) 远远不及预期, 因此, 更好的方案可能是先通过 ChatGPT 或

者 GPT-4 获取外部知识, 然后将获取得外部知识与原文本或者原图片信息结合并将结合后的信息输入到下游模

型 (如 CRF), 最终实现实体分类.

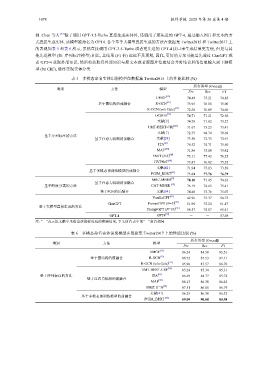

表 5 多模态命名实体识别模型在数据集 Twitter2015 上的性能比较 (%)

所有类型 (Overall)

类别 方法 模型

Pre Rec F1

UMGF [15] 74.49 75.21 74.85

基于图结构的前融合 R-GCN [33] 73.95 76.18 75.00

R-GCN (w/o Gate) [33] 72.50 76.89 74.60

[25]

OCSGA 74.71 71.21 72.92

文献[9] 74.78 71.82 73.27

UMT-BERT-CRF [26] 71.67 75.23 73.41

文献[7] 72.75 68.74 70.69

基于序列标注的方法

基于注意力机制的前融合 文献[24] 73.50 72.33 72.91

[27]

ITA 76.52 74.71 75.60

[28]

MAF 71.86 75.10 73.42

[48]

FMIT (l=3) 75.11 77.43 76.25

[40]

HVPNeT 73.87 76.82 75.32

文献[41] 71.94 75.13 73.50

基于多模态预训练模型的前融合

PGIM_BERT [43] 75.84 77.76 76.79

MRC-MNER [8] 78.10 71.45 74.63

基于注意力机制的前融合

[39]

基于跨度分类的方法 基于图结构的前融合 75.41

CAT-MNER

76.19

74.65

基于POE的后融合 文献[54] 74.40 75.76 75.07

[43]

VanillaGPT 42.96 75.37 54.73

[43]

ChatGPT PromptGPT (N=1) 51.96 75.24 61.47

基于大模型直接生成的方法

PromptGPT (N=10) [43] 58.57 74.07 65.41

GPT-4 GPT4 [57] - - 57.98

注: “-”表示原文献中未给出该指标对应的实验结果, 下文所有表中的“-”含意相同

表 6 多模态命名实体识别模型在数据集 Twitter2017 上的性能比较 (%)

所有类型 (Overall)

类别 方法 模型

Pre Rec F1

UMGF [15] 86.54 84.50 85.51

R-GCN [33] 86.72 87.53 87.11

R-GCN (w/o Gate) [33] 85.90 87.57 86.70

UMT-BERT-CRF [26] 85.28 85.34 85.31

基于序列标注的方法 ITA [27] 86.69 84.77 85.72

基于注意力机制的前融合

MAF [28] 86.13 86.38 86.25

FMIT (l=3) [48] 87.51 86.08 86.79

文献[41] 86.25 86.38 86.32

基于多模态预训练模型的前融合

PGIM_BERT [43] 89.09 90.08 89.58