Page 270 - 《软件学报》2025年第4期

P. 270

1676 软件学报 2025 年第 36 卷第 4 期

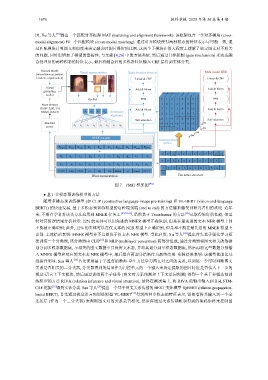

因, Xu 等人 [28] 提出一个匹配对齐框架 MAF (matching and alignment framework). 该框架包含一个对齐模块 (cross-

modal alignment) 和一个匹配模块 (cross-modal matching). 通过对齐模块使得两种模态的特征表示尽可能一致, 通

过匹配模块计算图文相似度来决定融合时图片保留的比例. 这两个子模块在很大程度上缓解了给定图文对不相关

的问题, 同时也增加了模型的鲁棒性; 与文献 [4,26] 中的方法类似, 然后通过门控机制 (gate mechanism) 来动态融

合处理后的两种模态的特征表示, 最后将融合后的多模态特征输入 CRF 层得到实体分类.

General words Muti-modal NER

(miscellaneous, person, Visual representation Entity boundary detection

location, organization) Linear & CRF

Linear & CRF

Visual

Add & Norm Add & Norm

grounding

toolkit

ResNet FFN 0 1 2 3 4 5 0 FFN

Noun phrases -1 0 1 2 3 4 -1

(Julia Child, Taj Add & Norm -2 1 0 3 4 5 -2 Add & Norm

Mahal, sunset) 1 v 2 v 3 v 4 v Dimension -3 1 2 0 4 0 -3

alignment

-4 1 -3 3 0 -6 -4

Self-attention Self-attention

Stanford -5 -4 -3 -2 -1 0 -5 d (tt)

parser 1 x 2 x 3 x 4 x 5 x 6 x 7 x 8 x

0 1 2 3 6 5 0 d (ht)

(th)

d

(hh)

d

BERT encoder

Relative position

metrics

E [CLS E E E E E E E at E E [SEP

] J ulia C hild at the Tai Mahal sunset ]

+

c c c c c c c c c c c c

x 1 x 2 x 3 x 4 x 5 x 6 x 7 x 8 v 1 v 2 v 3 v 4

E A E A E A E A E A E A E A E A E A E A

+ 1 2 3 4 5 6 7 8 1 8 5 1

E 0 E 1 E 2 E 3 E 4 E 5 E 6 E 7 E 8 E 9

1 2 3 4 5 6 7 8 8 8 6 2

[ CLS ] J ulia C hild at the Tai Mahal at sunset [ SEP ]

Cell

Word representation Flat lattice structure

图 7 FMIT 框架图 [48]

线提升明显. Sun

● 基于多模态预训练模型的方法

随着多模态预训练模型 (如 CLIP (contrastive language-image pre-training) 和 VL-BERT (vision-and-language

BERT)) 的快速发展, 基于多模态预训练模型的这种端到端 (end to end) 的方法越来越受到研究者们的欢迎. 近年

来, 不断有学者将该类方法应用到 MNER 任务上 [29,32,41] . 虽然基于 Transformer 的方法 [26] 已取得较好的性能, 但是

针对其错误结果分析显示: 22% 的实体可以用先进的 MNER 模型正确识别, 但是在最先进的文本 NER 模型上却

不能被正确识别; 此外, 12% 的实体可以在仅文本的 NER 模型上正确识别, 但是却不能在最先进的 MNER 模型上

识别. 上述结论表明: MNER 模型并不总是优于仅文本 NER 模型. 受此启发, Xu 等人 [41] 提出首先基于强化学习框

架训练一个分类器, 该分类器由 CLIP [52] 和 MLP (multilayer perceptron) 两部分组成, 通过分类器将图文相关的数据

划分到多模态数据集, 不相关的图文数据中只保留文本态, 并将其划分到单模态数据集, 然后再将这些数据分别输

入 MNER 模型和对应的文本态 NER 模型中, 最后组合两部分结果作为最终结果. 实验结果表明: 该模型性能比基

等人 [32] 首先使用基于半监督的教师-学生方法学习图文对之间的关系, 以训练一个可以判断图文

关系是否相关的二分类器, 分类器得到的结果作为门控单元的一个输入来决定提取的图片特征是否传入下一步的

视觉-语言上下文模块, 然后通过训练两个子任务 (图文对关系预测和上下文单词预测) 得到一个基于多模态预训

练模型的方法 RIVA (relation inference and visual attention), 最终在测试集上, 将 RIVA 的输出输入到 Bi-LSTM-

CRF 框架 [19] 得到实体分类. Sun 等人 [29] 提出一个基于图文关系传播的 BERT 变体模型 RpBERT (relation-propagation-

based BERT), 首先通过视觉语言预训练模型 VL-BERT [53] 得到两种多模态的特征表示, 紧接着将其输入到一个全

连接层 (作为一个二分类器) 来判断图文对的关系是否相关, 然后再通过关系传播机制得到的掩码矩阵来控制图