Page 268 - 《软件学报》2025年第4期

P. 268

1674 软件学报 2025 年第 36 卷第 4 期

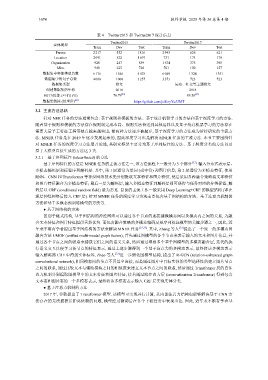

表 4 Twitter2015 和 Twitter2017 统计信息

Twitter2015 Twitter2017

实体类型

Train Dev Test Train Dev Test

Person 2 217 552 1816 2 943 626 621

Location 2 091 522 1 697 731 173 178

Organization 928 247 839 1 674 375 395

Misc 940 225 726 701 150 157

数据集中实体类型总数 6 176 1 546 5 078 6 049 1 324 1 351

数据集中的句子总数 4 000 1 000 3 257 3 373 723 723

数据集类型 推文 运动、社交等主题推文

创建数据集的年份 2018 2018

SOTA性能 (F1值) (%) 76.79 [43] 89.58 [43]

数据集链接 (处理后) [26] https://github.com/jefferyYu/UMT

3.2 主流方法总结

[33]

针对 NER 任务的方法通常包含: 基于规则和模板的方法、基于统计机器学习的方法和基于深度学习的方法.

随着基于规则和模板的方法存在规则制定成本高、规则无法普适到其他语料以及基于统计机器学习的方法存在

需要大量手工特征工程等缺点越来越突出, 前两种方法逐步被抛弃, 基于深度学习的方法成为后续研究的主流方

法. MNER 任务是在 2019 年逐步发展起来的, 因此深度学习也是解决 MNER 任务的主流方法. 本节主要围绕针

对 MNER 任务的深度学习方法展开论述, 其研究框架主要分为基于序列标注的方法、基于跨度分类的方法以及

基于大模型直接生成的方法这 3 类.

3.2.1 基于序列标注 (token-based) 的方法

基于序列标注的方法是 MNER 任务的主流方法之一, 该方法流程上一般分为 3 个部分 [23] : 输入分布式表示层、

多模态编码层和标签序列解码层. 其中, 第 1 层通常为单词 (或字符) 和图片信息; 第 2 层通常为多模态特征, 使用

RNN、CNN 和 Transformer 等神经网络技术先分别提取文本特征和图片特征, 然后采用各种融合策略将文本特征

和图片特征融合为多模态特征; 最后一层为解码层, 输入多模态特征到解码层即可获得与任务对应的分类标签, 解

码层以 CRF (conditional random field) 最为常见. 目前的主流工作一般采用 Deep Learning+CRF 的模型结构 (即在

深层神经网络后接入 CRF 层). 针对 MNER 任务的深度学习方法主要包含基于图结构的方法、基于注意力机制的

方法和基于多模态预训练模型的方法等.

● 基于图结构的方法

区别于链式结构, 基于图结构的神经网络可以通过各个节点的连接建模模态间以及模态内之间的关系, 为融

合文本特征和图片特征提供天然优势. 而包含融合策略的多模态编码层是序列标注模型的关键步骤之一, 因此, 近

年来不断有学者提出基于图结构的方法来解决 MNER 任务 [15,33] . 其中, Zhang 等人 [15] 提出了一个统一的多模态图

融合方法 UMGF (unified multi-modal graph fusion), 首先通过图模型的各个节点来表示输入的文本和图片信息, 并

通过各个节点之间的联系来捕获它们之间的语义关系, 然后通过堆叠多个基于图模型的多模态融合层, 迭代的执

行语义交互以便学习各节点的特征表示, 通过上述步骤得到一个基于注意力的多模态表示, 最终将该多模态表示

输入解码器 CRF 中得到实体标签. Zhao 等人 进一步细化图模型结构, 提出了 R-GCN (relation-enhanced graph

convolutional network), 相同模态间的节点不再是全连接, 而是通过图片中目标实体的类型选择性的建立图片节点

之间的联系, 通过比较文本与辅助模块之间的相似度来建立文本节点之间的联系, 然后通过 Transformer 层的自注

意力机制分别提取图模型中的文本特征和图片特征, 接着通过跨注意力层 (cross-attention Transformer) 得到包含

文本态和图片态的一个多模态表示, 最终将该多模态表示输入 CRF 层实现实体分类.

● 基于注意力机制的方法

2017 年, 谷歌提出了 Transformer 模型. 该模型可实现并行计算, 其内部注意力结构也能够解决基于 CNN 方

法存在的无法捕获长距离依赖的问题, 模型经过微调后在各个下游任务中表现出色. 因此, 近年来不断有学者基