Page 263 - 《软件学报》2025年第4期

P. 263

王永胜 等: 多模态信息抽取研究综述 1669

模态信息抽的 3 个子任务所共有的多模态表示 (包含文本特征表示和图片特征表示) 和多模态融合这两个方面进

行分析.

2.1 文本特征表示 (字符级和单词级)

文本特征表示通常包含基于卷积神经网络的方法 (convolutional neural network, CNN)、基于循环神经网络的

方法 (recurrent neural network, RNN)、基于语法依存树的方法 (syntax dependency tree) 以及基于 Transformer

编码端的方法 (bidirectional encoder representations from Transformers, BERT) 等. 基于卷积神经网络的方法可以获

取单词 (或字符) 的局部结构特征; 基于循环神经网络的方法能够获取文本的顺序信息; 基于语法依存树的方法可

以建模复杂的语义表示; BERT 方法可以有效捕获文本上下文信息. 由于不同的文本特征表示方法侧重点不同, 可

能对整个句子的理解有不同影响, 本节主要围绕上述几种不同的特征表示方法展开分析.

● 基于 CNN 的方法. 早期, 基于 CNN 的方法主要被应用在图像处理领域, 近年来不断有学者尝试将该方

法引入文本领域 [9,24] . 它可通过卷积操作来捕获句子中的局部特征, 在识别关键词和短语等方面表现出色. 考虑

到多模态信息抽取任务中, 数据集中的文本多数直接来源于网络, 经常会有拼写错误、包含未登录词 (out-of-

+

vocabulary, OOV) 以及不正常的大小写等特点, Chen 等人 [9] 引入字符级编码 (character-level, 即将单词看成一个

序列并将单词中的每个字符看成序列中的元素), 然后使用 CNN 来提取字符的特征向量. 通过该方法可以提取

单词的局部信息 (如前缀、后缀以及大写等结构特征), 为理解存在拼写错误、OOV 以及不正常的大小写等特

点的句子提供帮助.

● 基于 RNN 的方法. 虽然上述方法在某些需要捕获局部特征的任务中表现出色, 但是通过该方法无法捕获文

本的位置信息. 因此, Lu 等人 [4] 引入基于 RNN 的 LSTM (long short-term memory) 来编码文本特征, 采用 LSTM 的

编码方式可以捕获句子中的顺序信息. 此外, LSTM 通过引入门控还可以缓解梯度爆炸和梯度消失问题. 但是上述

i

i

方法只能考虑单词之前的信息, 即第 i 个词所获得的信息均来自第 个词以及之前的信息, 无法获得第 个词之后

的信息. 因此, Wu 等人 [25] 使用双向 LSTM (bi-directional long short-term memory, Bi-LSTM) 来编码文本特征, 其包

→ ←

含一个前向 LSTM 和一个后向 LSTM, 将双向 LSTM 的输出拼接得到一个新的特征表示 [h t ,h t ] . 进一步地, 为了同

时捕获句子的字符特征以及文本位置特征, Moon 等人 [6] 将 Bi-LSTM 方法得到的词级别特征表示与基于 CNN 方

法得到的字符级特征表示拼接在一起得到最终的词向量表示.

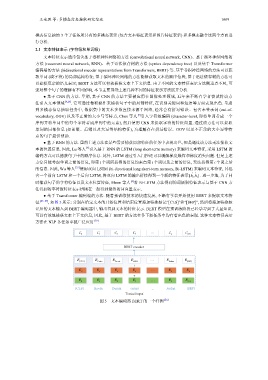

● 基于 Transformer 编码端的方法. 随着预训练技术的快速发展, 不断有学者开始使用 BERT 来提取文本特

征 [26−29] , 如图 5 所示: 分别在给定文本的开始位置和结束位置添加特殊标记“[CLS]”和“[SEP]”, 然后将添加特殊标

记后的文本输入到 BERT 编码器中, 输出得到文本的特征表示. BERT 模型在预训练阶段已经学习到了大量知识,

可以有效地捕获文本上下文信息, 因此, 基于 BERT 的方法在各下游任务中均有着出色的表现. 这种文本特征表示

方法在 NLP 各任务中被广泛应用 [30] .

…

C 0 C 1 C 2 C 3 C n C n+1

BERT encoder

E [CLS] E Kevin E Durant E enters … E Jordan E [SEP]

+

E A E A E A E A … E A E A

E 0 E 1 E 2 E 3 … E n E n+1

[CLS] Kevin Durant enters ... Jordan [SEP]

Textual input

图 5 文本编码器 BERT 的一个样例 [26]