Page 267 - 《软件学报》2025年第4期

P. 267

王永胜 等: 多模态信息抽取研究综述 1673

似度来实现图片和文本之间的关系映射, 这样的好处是可以找到图片中的目标实体与文本中实体的相关性, 使得

文本和图片之间得到更深的交互.

● 基于多模态预训练模型的多模态融合. 随着对比学习、强化学习等技术的快速发展, 研究者们通过大量数

据可以训练出一个强大的二分类器 [29,41] , 该分类器可将多模态数据集分为相关的图文数据和不相关的图文数据,

相关的图文数据输入到先进的多模态模型中, 不相关的数据输入先进的单模态数据中. 这类方法与上述门控机制

相比, 模型的性能得到进一步提升.

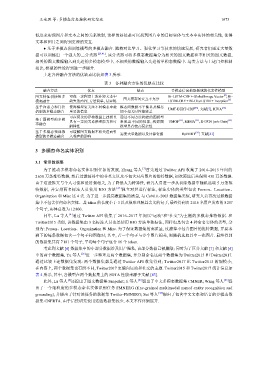

上述各种融合方法的优缺点比较如表 3 所示.

表 3 各种融合方法的优缺点比较

融合方法 优点 缺点 多模态信息抽取领域的代表性模型

[4]

图文特征拼接的多 可在一定程度上弥补短文本中 图文模态间交互不充分 Bi-LSTM-CRF + Global Image Vector , Bi-

模态融合 缺失的内容; 方法简单, 易实现 LSTM-CRF + Bi-CharLSTM + Inception [6]

基于注意力和门控 使得模型更关注不同模态中最 模态间数据不平衡以及模态 UMT-BERT-CRF [26] , 文献[7], RIVA [32]

机制的多模态融合 重要的信息 间不相关时性能较差

性能来源于文献

可在复杂的异构数据上建模且 通过不同方法构建的图模型

基于图模型的多模 具有一定的关系推理能力和可 表现出不同的性能, 构建图 UMGF [15] , MEGA [31] , R-GCN (w/o Gate) [33]

态融合

解释性 模型具有较高复杂性

基于多模态预训练 可缓解图文数据不相关进而引 需要大量数据以及计算资源 RpBERT [29] , 文献[41]

模型的多模态融合 入噪声的影响

3 多模态命名实体识别

3.1 常用数据集

为了推动多模态命名实体识别任务的发展, Zhang 等人 [7] 首先通过 Twitter API 收集了 2014–2015 年间的

2 650 万条推特数据, 然后过滤掉其中的非英文以及不包含对应图片的推特数据, 初次筛选后共保留 430 万条数据.

由于这些推文与个人习惯和爱好强相关, 为了降低人为特异性, 研究人员进一步从初筛数据中随机选取 5 万条推

特数据, 并安排两名标注人员使用 BIO 方法 [42] 独立对其进行标注, 标注实体的类型包含 Person、Location、

Organization 和 Misc 这 4 类. 为了进一步提高数据集的质量, 与 CoNLL-2003 数据集类似, 研究人员再次过滤数据

集中不包含任何命名实体、其 token 的长度小于 3 以及很难理解其含义的句子, 最终得到由 2 116 名用户发布的 8 257

个句子, 实体总数为 12 800.

同年, Lu 等人 [4] 通过 Twitter API 收集了 2016–2017 年间以“运动“和“社交”为主题的多模态推特数据. 和

Twitter2015 类似, 该数据集由 3 名标注人员也是使用 BIO 方法单独标注, 同样也是包含 4 种命名实体的类型, 分

别为: Person、Location、Organization 和 Misc. 为了保证数据集的高质量, 过滤掉不包含图片的推特数据, 并要求

剩下的每条数据包含一个句子和图像对; 其中, 若一个句子与多个图片相关, 则随机选取其中一张图片. 最终得到

的数据集共有 7 181 个句子, 平均每个句子包含 16 个 token.

考虑到文献 [4] 数据集中的小部分数据涉及用户隐私, 该部分数据已被删除; 同时为了区分文献 [7] 和文献 [4]

中的两个数据集, Yu 等人 [26] 进一步整理这两个数据集, 并分别命名这两个数据集为 Twitter2015 和 Twitter2017.

通过比较上述数据集发现: 两个数据集都是通过 Twitter API 收集得到; Twitter2017 比 Twitter2015 的规模小;

在内容上, 两个数据集也有所不同, Twitter2017 更偏向运动和社交的主题. Twitter2015 和 Twitter2017 统计信息如

表 4 所示, 其中, 各模型在两个数据集上的 SOTA [43].

此外, Lu 等人 [4] 还提出了图文数据集 Snapchat; Ji 等人 [44] 提出了中文多模态数据集 CMNER; Wang 等人 [45] 提

出了一个细粒度的多模态命名实体识别任务 FMNERG (fine-grained multimodal named entity recognition and

grounding), 并提出了针对该任务的数据集 Twitter-FMNERG; Sui 等人 [46] 提出了包含中文文本和语音的多模态数

据集 CNERTA. 由于后续研究使用这些数据集较少, 本文不作详细展开.