Page 264 - 《软件学报》2025年第4期

P. 264

1670 软件学报 2025 年第 36 卷第 4 期

● 基于语法依存树的方法. 针对复杂场景 (如实体嵌套), Li 等人 [13] 使用基于语法依存树的方法提取文本特征.

它将句子的语义结构以树或图的方式呈现, 树 (或图) 的节点表示实体, 其连接的边表示实体之间的关系. 该方法

不仅仅关注表层的语法结构, 还关注句子深层的语义结构, 能够帮助模型更好地理解句子含义. 上述各种文本特征

表示方法的优缺点比较见表 1.

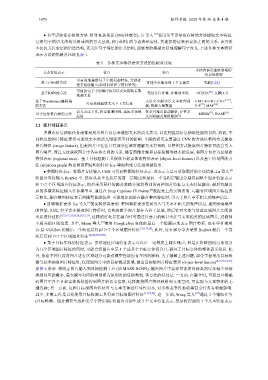

表 1 各种文本特征表示方法的优缺点比较

多模态信息抽取领域的

文本特征表示 优点 缺点

代表性模型

可有效地捕获句子中的局部特征, 方便处

基于CNN的方法 可能会忽略全局上下文信息 文献[9,24]

理多通道输入(如词向量和字符向量等)

可捕获句子中的顺序信息以及短期和长期 [25]

基于RNN的方法 无法并行计算, 计算效率低 OCSGA , 文献[4,7]

依赖关系

基于Transformer编码端 可有效地捕获文本上下文信息 无法完全解决长文本处理问 U M T -B E R T -C R F [ 2 6 ] ,

的方法 题, 依赖大量数据 ITA [27] , MAF [28]

语义表达丰富, 跨语言通用性, 适应多领域 复杂且难以自动解析, 存在多 [31] [13]

基于语法依存树的方法 MEGA , WASE

测等技术抽取图片特征时, 仅保留图片中的目标视觉区域, 提出目标级图片特征表示

应用 义词问题及规模限制等

2.2 图片特征表示

多模态信息抽取任务通常是利用图片信息来增强文本的语义表示, 以达到提高信息抽取性能的目的. 然而, 不

同粒度的图片特征表示可能对文本的语义增强有不同的影响. 早期的研究主要通过 CNN 的方法以整图方式提取

图片特征 (image feature), 但是图片中往往只有部分区域对理解文本有帮助, 以整图方式提取图片特征可能会引入

图片噪声, 而且无法获取图片中各实体之间的关系. 随着图像分割和目标检测等技术的发展, 将图片切分为区域的

特征表示 (regional area)、基于目标检测工具提取目标实体的特征表示 (object-level feature) 以及基于情境图的方

法 (situation graph) 构建树或图结构的特征表示等细粒度方法相继被提出.

● 整图特征表示. 将图片直接输入 CNN 可得到整图的特征表示. 该表示方法可获取图片的全局信息. Lu 等人 [4]

将图片直接输入 ResNet 中, 然后从其全连接层的前一层输出和最后一个卷积层输出分别得到整个图片特征表示

和 7×7 个区域图片特征表示, 然后采用同样的融合策略分别将得到的两种图片特征与文本特征融合, 最后将融合

后的多模态特征输入任务模型中. 通过在 Snap Captions 和 Twitter 数据集上的实验表明: 与融合区域图片特征表

[4]

示相比, 融合整图特征表示的模型性能较差. 可能的原因是在融合整图特征时, 引入了图片中不相关的噪声信息.

● 区域特征表示. Lu 等人 [4] 的实验结果表明: 整图特征表示容易引入与文本不相关的噪声信息, 最终影响模型

的性能. 因此, 有学者在提取图片特征时, 首先将整个图片划分为若干区域, 然后针对文本与这些区域图片之间的

关系进行建模 [6,7,9,13,24,26,28,29,32,33] , 这样的好处是在融合时可通过注意力机制只关注与文本相关的区域图片, 过滤掉

不相关的区域信息. 其中, Moon 等人 [6] 使用 GoogLeNet 变体的最后一个隐藏层来表示图片特征; 也有学者使用

16 层 VGGNet 的最后一个池化层得到 7×7 个区域图片特征 [7,9,13,24] ; 此外, 还有部分学者使用 ResNet 最后一个卷

积层得到 7×7 个区域图片特征 [26,28,29,32,33] .

● 基于目标实体的特征表示. 虽然通过区域特征表示可以在一定程度上减少噪声, 但是在将整图均匀地切分

为几个区域图片特征的同时, 可能会将图片中某 1 个或多个目标实体切分开, 破坏了目标实体的整体语义信息. 此

外, 依据不同尺度对图片进行区域划分可能对模型性能也有不同的影响. 为了缓解上述问题, 部分学者采用目标检

(object-level feature) [8,15,25,27,34] .

如图 6 所示: 将给定图片输入到目标检测工具 (如 MASK RCNN), 输出图片中实体可能的目标类别以及每个目标

类别对应的概率, 最大概率对应的类别即为识别出的目标类别. 该方法的好处是: 一方面, 在融合时, 可通过直接编

码图片中各个目标实体的标签得到图片的语义信息, 这样就将图片特征映射到文本空间, 可实现与文本特征的无

缝连接; 另一方面, 这种目标级图片特征可与文本实体进行显性对齐, 对多模态事件抽取等复杂任务有积极影响.

其中, 多数工作是直接使用目标检测工具得到目标级图片特征 [15,25,34] . 进一步地, Wang 等人 [27] 通过 3 个辅助任务

(目标检测、图片摘要生成和光学字符识别) 将图片分别生成 3 个文本特征表示, 然后将得到的 3 个文本特征表示