Page 277 - 《软件学报》2025年第4期

P. 277

王永胜 等: 多模态信息抽取研究综述 1683

上述实验结果表明: 输入中融合相关的图片信息可以提高文本事件抽取的性能, 同时也验证了所提出模型的有

效性.

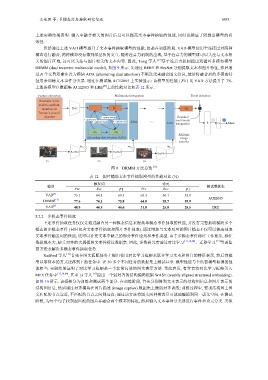

虽然通过上述 VAD 模型提升了文本事件抽取模型的性能, 但是在训练阶段, VAD 模型使用全连接层对两种

模态进行融合, 两种模态没有得到深层次的交互. 随着注意力机制的出现, 基于注意力的模型既可以关注与文本相

关的图片区域, 还可以关注与图片相关的文本内容. 因此, Tong 等人 [17] 基于注意力机制提出双循环多模态模型

DRMM (dual recurrent multimodal model), 如图 9 所示. 先通过 BERT 和 ResNet 分别提取文本和图片特征, 然后通

过 N 个交替双重注意力模块 ADA (alternating dual attention) 不断迭代来融合图文信息, 最后将融合后的多模态特

征用来训练文本事件分类器. 通过在测试集 ACE2005 上实验显示: 该模型的性能 ( F1 ) 比 VAD 方法提升了 7%.

上述各模型在数据集 ACE2005 和 ERE [83] 上的性能对比如表 12 所示.

Feature extraction Multimodal integration Event detection

Ford was in his

rush to confront

members in Bert H 1 H k

Toronto’s council

型以零样本的方式迁移到下游任务中. 在

chamber 3. query image e Residual

1. query text ... multimoda

2. update image 4. update text ADA

ADA integration R O Meet

m 1 '

m 1

Multiple

Alternating dual attention (ADA) image

encoder

m 1 m 2 m k

ResNet ResNet

ResNet

p 1 p 2 p k

图 9 DRMM 方法总览 [17]

表 12 图片辅助文本事件抽取模型的性能对比 (%)

触发词 论元

模型 测试数据集

Pre Rec F1 Pre Rec F1

VAD [3] 75.1 64.3 69.3 63.3 50.1 55.9

ACE2005

DRMM [17] 77.6 74.1 75.8 64.8 55.7 59.9

[3]

VAD 48.9 44.5 46.6 31.8 25.8 28.5 ERE

5.2.2 多模态事件抽取

上述事件抽取任务仅仅是通过融合另一种模态信息来提高单模态事件抽取的性能, 并没有完整抽取横跨多个

模态的多模态事件 (同时包含文本事件抽取和图片事件抽取). 通过增加与文本对应的图片模态不仅可以提高抽取

文本事件触发词的性能, 还可以补充文本中缺乏的部分事件论元和事件类型. 由于多模态事件标注工作复杂, 标注

数据成本大, 缺乏对齐的大规模图文事件标注数据集. 因此, 多数研究者通过对比学习 [13,14,84] 、迁移学习 [13] 等弱监

督方法来解决多模态事件抽取任务.

Radford 等人 [52] 首先在图文匹配任务上提出使用对比学习框架来联合学习文本和图片的特征表示, 然后将模

30 多个不同任务的数据集上测试显示: 模型性能与全监督模型取得的性

能相当. 实验结果证明了对比学习框架是一个非常高效的图文表示方法. 受此启发, 有学者将对比学习框架引入

MEE 任务中 [13,14,84] . 其中 Li 等人 [13] 提出一个弱对齐的结构编码框架 WASE (weakly aligned structured embedding).

如图 10 所示. 该框架分为训练和测试两个部分. 在训练阶段, 首先分别得到文本表示的结构图信息和图片表示的

结构图信息, 然后通过对齐模块在图片描述 (image caption) 数据集上做弱对齐训练; 训练过程中, 要求结构图上图

文匹配的节点靠近, 不匹配的节点之间则远离; 通过该方法将图文两种模态尽可能地编码到同一语义空间. 在测试

阶段, 为每个句子找到最匹配的图片并融合两个模态的特征, 然后输入文本事件分类器进行事件和论元分类. 类似