Page 276 - 《软件学报》2025年第4期

P. 276

1682 软件学报 2025 年第 36 卷第 4 期

2

2

2

2

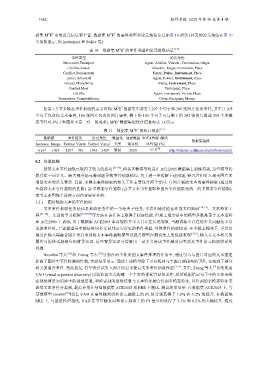

据集 M E 中的论元信息更丰富. 数据集 M E 的事件类型和论元角色信息如表 10 所示 (补充的论元角色在表 10

中加粗显示, 如 Instrument 和 Police 等).

表 10 数据集 M E 的事件类型和论元角色信息 [13]

2 2

事件类型 论元角色

Movement.Transport Agent, Artifact, Vehicle , Destination, Origin

Conflict.Attack Attacker, Target, Instrument, Place

Conflict.Demonstrate Entity, Police, Instrument, Place

Justice.ArrestJail Agent, Person, Instrument, Place

Contact.PhoneWrite Entity, Instrument, Place

Contact.Meet Participant, Place

Life.Die Agent, Instrument, Victim, Place

Transaction. TransferMoney Giver, Recipient, Money

2 2

按第 1.3 节多模态事件抽取的定义可知: M E 数据集中共有 1 297 个句子和 391 张图片包含事件; 其中, 1 105

提高了图片中事件检测的性能, 实验结果显示: 通过上述模型除了可以找到与主题直接相关的事件, 还找到了部分

个句子包含仅文本事件, 188 张图片包含仅图片事件, 剩下的 192 个句子可与剩下的 203 张图片组成 309 个多模

2 2

态事件对 (句子和图片不是一对一的关系). M E 数据集的统计信息如表 11 所示.

2 2

表 11 数据集 M E 的统计数据 [13]

数据源 事件提及 论元角色 数据集 创建数据 SOTA性能 (触发

数据集链接

Sentence Image Textual Visual Textual Visual 类型 集年份 词F1值) (%)

6 167 1 014 1 297 391 1 965 1 429 新闻 2020 57.5 [70] http://blender.cs.illinois.edu/software/m2e2

5.2 方法总结

虽然文本事件抽取已取得了较大的成功 [71−73] , 但其多数模型均是在 ACE2005 数据集上训练得到, 这些模型仍

然存在一词多义、缺失部分论元等问题导致事件抽取错误. 为了进一步缓解上述问题, 研究者们引入相关图片来

增强文本的语义表示. 目前, 多模态事件抽取的相关工作主要包含两个方向. 1) 图片辅助文本的事件抽取 (通过图

片提高文本事件抽取的性能). 2) 多模态事件抽取 (合并文本事件抽取和图片事件抽取为统一的多模态事件抽取).

本节主要围绕上述两方面内容展开分析.

5.2.1 图片辅助文本的事件抽取

文本事件抽取任务是信息抽取任务中的一个经典子任务, 学者们通过检索外部文档知识 [74,75] 、文本特征工

程 [76−78] 、先进的学习框架 [71,79,80] 等方法在该任务上取得了较好性能. 但是上述方法中的模型多数是基于文本语料

库 ACE2005 上训练, 由于数据集 ACE2005 本身规模并不大且存在长尾现象, 当测试集中存在的多义词触发不常

见的事件时, 上述模型基本都是将该多义词判定为常见的事件类型, 导致事件抽取错误. 在多模态视角下, 学者们

通过在输入端融合图片信息来训练文本事件抽取模型以提升模型在测试集上的性能表现 [3,17] , 输入与文本相关的

图片可提供话题相应的背景知识, 这些背景知识可缓解由一词多义造成事件触发词类型及事件论元抽取错误的

问题.

Bosselut 等人 [81] 和 Young 等人 [82] 分别在两个涉及图文事件推理的任务中, 通过引入与图片对应的文本描述

相关的蕴含事件. 受此启发, 有学者尝试引入图片信息来提高文本事件抽取性能 [3,17] . 其中, Zhang 等人 [3] 首先使用

VAD (visual argument discovery) 以弱监督方式构建一个丰富的视觉背景知识库, 然后根据给定句子中的实体来检

索视觉背景知识库中的视觉信息, 将检索到的视觉信息与文本特征融合得到多模态特征, 以得到的多模态特征来

训练文本事件分类器, 最后分别在基准数据集 ACE2005 和 ERE 上测试. 测试结果显示: 在数据集 ACE2005 上, 与

基准模型 JointIE [77] 相比, VAD 在事件触发词和论元抽取上的 F1 值分别获得了 1.8% 和 3.2% 的提升; 在数据集

ERE 上, 与基准模型相比, VAD 在事件触发词和论元抽取上的 F1 值分别获得了 7.1% 和 8.2% 的大幅提升. 通过