Page 224 - 《软件学报》2025年第5期

P. 224

2124 软件学报 2025 年第 36 卷第 5 期

算法 DeepFool 和 C&W 下, ALWR 和 LWR 的健壮性表现相似, 在 CIFAR-10 和 CIFAR-100 上 LWR 有更好的健

壮准确度, 因此我们认为 LWR 对不同样本标签筛选权重参数的权衡优化能够在更复杂的数据集和网络结构中对

此类攻击展现出优势. 从实验结果可知, JR 模型在大多数攻击下都表现出比其他模型更弱的健壮性, 但在强噪声

的 DeepFool 攻击下比 TRADES 和 AT 模型表现更好, 符合文献 [35] 得出的 JR 使得模型决策域更广且决策边界

更平滑的结论. TRADES 模型在基于梯度的攻击下健壮性表现略差于 AT 模型, 但其自然准确度相比于 Base 模型

下降得更少, 这也体现 TRADES 方法能够权衡模型泛化性和健壮性的原理. AT 模型相比于前两个模型有更好的

健壮性, 而梯度攻击下健壮性表现更为明显, 这可能是因为使用 PGD 算法生成的对抗样本进行对抗训练的原因.

在本文所提的方法中, TLWR 与 Base 模型在健壮性表现上远不如其他健壮防御策略, 在 CIFAR-100 的实验中都

能被高强度 PGD 完全攻击, 但 TLWR 在基于优化的攻击下相比于 Base 模型表现出更好的健壮性. ALWR 模型

和 LWR 模型在任意攻击下都具有相似的健壮性表现, ALWR 在 MNIST 数据集上表现得更好, 而 LWR 在 CIFAR-

10 和 CIFAR-100 上对基于优化角度的攻击更健壮, 猜测这可能是因为 LWR 相比于 ALWR 添加了干净样本标签

筛选权重参数正则项.

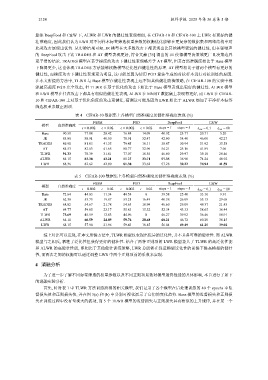

表 4 CIFAR-10 数据集上各模型自然准确度及健壮准确度表现 (%)

FGSM PGD DeepFool C&W

模型 自然准确度

ϵ = 0.002 ϵ = 0.02 ϵ = 0.002 ϵ = 0.02 steps = 1 steps = 5 λ cw = 0.1 λ cw = 10

Base 90.51 77.88 28.42 76.84 14.09 40.92 25.77 20.71 5.20

JR 85.00 80.91 40.50 78.91 32.47 42.90 34.40 46.00 42.27

TRADES 86.90 81.83 41.35 79.45 18.11 38.67 30.94 51.92 35.58

AT 84.53 82.63 41.65 80.77 32.96 54.21 25.16 41.89 7.06

TLWR 91.33 78.39 31.81 77.07 18.56 46.60 29.97 39.18 20.46

ALWR 84.15 83.38 43.21 81.25 33.71 57.35 36.90 74.24 40.92

LWR 88.36 82.62 42.00 81.38 33.62 57.28 39.22 74.94 41.59

表 5 CIFAR-100 数据集上各模型自然准确度及健壮准确度表现 (%)

FGSM PGD DeepFool C&W

模型 自然准确度

ϵ = 0.002 ϵ = 0.02 ϵ = 0.002 ϵ = 0.02 steps = 1 steps = 5 λ cw = 0.1 λ cw = 10

Base 72.64 44.03 11.34 44.54 0 39.58 25.40 33.10 9.91

JR 62.38 53.73 19.87 53.21 16.49 40.38 26.09 55.13 29.68

TRADES 68.02 54.67 21.78 54.63 18.99 46.60 29.09 49.37 21.43

AT 64.77 59.85 23.17 55.83 15.32 52.34 43.33 58.65 36.44

TLWR 73.69 45.59 12.83 44.96 0 46.27 39.92 36.46 10.91

ALWR 64.11 60.59 24.89 59.76 20.68 60.21 46.72 60.20 38.15

LWR 68.15 57.90 21.96 59.43 18.85 56.04 49.49 61.25 39.02

综上对比可以发现, 在本文所提方法中, TLWR 模型仅表现出优异的泛化性, 并不具备可靠的健壮性. 而 ALWR

模型与之相反, 牺牲了泛化性但获得更好的健壮性. 结合了两种正则项的 LWR 模型兼具了 TLWR 的高泛化性能

和 ALWR 的高健壮性能, 即相比于其他健壮训练策略, LWR 总能够在保证模型泛化性的前提下提高模型的健壮

性, 而两者之间的权衡可以通过调整 LWR 中两个正则项前的系数来实现.

4 消融分析

为了进一步了解不同标签筛选的权重参数以及不同正则项系数对模型最终性能的具体影响, 本节进行了如下

的消融实验分析.

首先, 针对表 1 中 TLWR 方法训练所得的相关模型, 我们记录了各个模型在后处理训练的 40 个 epochs 中监

督损失值和正则损失值, 并在图 3(a) 和 (b) 中分别可视化展示了它们的变化趋势. Base 模型的监督损失和正则损

失在训练过程中没有呈现大的波动, 而 5 个 TLWR 模型的监督损失与正则损失具有相似的上升规律, 并在某一个