Page 222 - 《软件学报》2025年第5期

P. 222

2122 软件学报 2025 年第 36 卷第 5 期

3 实验分析

3.1 实验设置

本文选用公开的数据集 MNIST 、CIFAR-10 和 CIFAR-100 来对所提方法进行实验评估. MNIST 为包含

[1]

0–9 的 10 类手写字符数据集, 共有 60 000 张训练图像和 10 000 张测试图像, 每张图像规模为 28×28×1 的单通道灰

度图, 因此 MNIST 凭借数据简单的特点而被广泛应用于机器学习算法的验证. CIFAR-10 为包含多个动物和交通

工具的 10 类现实物体图像数据集, 共有 50 000 张训练图像和 10 000 张测试图像, 每张图像规模为 32×32×3 的三

通道彩图, 因此 CIFAR-10 更接近物理世界且数据复杂, 在深度学习的模型评估中成为最常用的数据集. CIFAR-

100 数据集规模大小与 CIFAR-10 类似, 但分类类别包含 100 类现实物体图像, 因此每个类别仅有 500 张训练图像

和 100 张测试图像, 因此其分类难度高于 CIFAR-10.

针对这 3 种复杂度不同的数据集, 本文采用 3 种不同结构的网络模型分别对它们进行训练和测试. 对于 MNIST

[1]

数据集, 采用 LeNet-5 浅层模型, 其结构由 2 个卷积层和 2 个池化层交错连接后, 再添加 2 个全连接层得到最终

输出, 尽管网络深度较浅结构简单, 但在识别 MNIST 数据集上能够达到极高的准确率, 同时训练的时间开销短, 能

[3]

够方便迅速地得到用于评估的模型. 对于 CIFAR-10 数据集, 采用 VGG19 深度模型, 采用小卷积核进行特征提

取, 在 16 个卷积层和 5 个池化层后再添加 3 个全连接层得到最终输出, 这种更深度的模型结构由于参数较多, 训

[4]

练速度也相对较慢, 但能够完成更加复杂的数据集分类任务. 对于 CIFAR-100 数据集, 采用 ResNet18 残差深度

神经网络, 该网络使用残差块连接有效地缓解了深层网络存在的梯度消失和梯度爆炸的问题, 提高了更深层模型

面对复杂任务的识别准确率.

LWR 模型的训练策略参考算法 1, 采用 60 个 epochs 的预训练和 40 个 epochs 的后处理. 在参数选取上后处

ϵ 为 0.2 的 PGD 攻击获取对抗样本及相应的对抗标签, 每个训练批次含样本数 m 为 128 个. 对于

理采用噪声强度

−4

MNIST 数据集下的 LeNet-5 网络, 选取正则项系数 λ T 为 5e , λ A 为 0.05 训练 LWR 模型. 对于 CIFAR-10 数据集

−5

−2

下的 VGG19 网络, 选取正则项系数 λ T 为 5e , λ A 为 1e 训练 LWR 模型. 对于 CIFAR-100 数据集下的 ResNet18

−1

λ T 为 −3 λ A 为 1e 训练 LWR 模型.

网络, 选取正则项系数 1e ,

本文所有实验都在一块 Nvidia GTX 3090 GPU 上进行, 皆以 Python 语言及 PyTorch 框架实现, 此外验证健壮

性所用的四种对抗攻击算法都由该框架下的对抗攻击库 Torchattacks 提供.

3.2 结果及分析

本节首先对提出的单一正则项 TLWR 和 ALWR 方法分别进行实验, 探讨它们在提高模型泛化性或健壮性上

是否具备应有的作用. 对于 TLWR 方法, 我们在 CIFAR-10 数据集上用 VGG19 的网络结构, 采用后处理训练策略,

L CE 训练 60 个 L TLWR 分别后处理训练 40 个

使用标准监督损失 epochs 的预训练模型, 再选取不同正则项系数的

epochs 后得到多个 TLWR 模型. 表 1 给出了这些模型最终的自然准确度, 其中 Base 是在预训练模型基础上仅用

L CE 进行同步训练 40 个 epochs 之后的基准模型, 用于与 TLWR 模型进行对比, 同时用 λ T 值为后缀区分不同的

TLWR 模型. 对最佳的自然准确度值加粗表示.

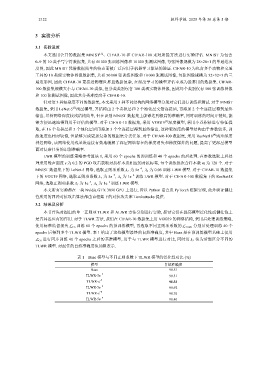

表 1 Base 模型与不同正则系数下 TLWR 模型的泛化性对比 (%)

模型 自然准确度

Base 90.51

−7

TLWR-5e 90.31

−7

TLWR-e 91.33

−8

TLWR-5e 90.92

TLWR-e −8 90.76

TLWR-5e −9 90.40