Page 332 - 《软件学报》2025年第4期

P. 332

1738 软件学报 2025 年第 36 卷第 4 期

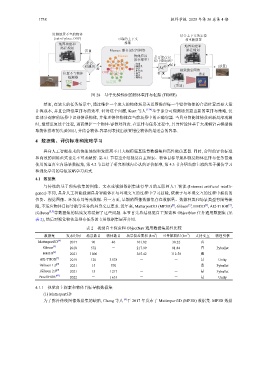

监测放置不当的物体 结合上下文的定位

(out-of-place, OOP) 可靠的上下文 和重新放置

地图构建和 推断

路径规划 地图构建和

否 Memex: 联合记忆图网络 路径规划

Memex 物体应该 是否能在记

放在那里? 忆中查询到?

是否 餐桌

检测到 咖啡桌 是 {放置}

是 沙发 视觉搜索网络

柜台面

位置不当物体 OOP 盒子 否 搜索

椅子

检测器 梳妆台

场景图

{类别}

图 28 基于先验知识的物体重排布框架 (TIDEE)

然而, 在较大的任务场景中, 通过维护一个庞大的物体场景关系图推理每一个错位物体的合适位置需要大量

计算成本, 并且会降低重排布的效率. 针对这个问题, Kant 等人 [124] 基于部分可观测场景提出新的重排布策略, 仅

365.42

在部分观察的场景中识别错误物体, 并推理错位物体在当前场景中的正确容器. 当具身智能体捕获到新局部观测

时, 继续重复这个过程, 进而维护一个物体-容器对列表. 在重排布任务过程中, 具身智能体基于大规模语言模型提

取物体排布的先验知识, 并结合物体-容器列表找出放置错位物体的最适合的容器.

4 数据集、评价标准和策略学习

具身人工智能技术的快速涌现和发展离不开大规模逼真场景数据集和高性能仿真器. 同时, 合理的评价标准

和高效的训练范式也是不可或缺的. 第 4.1 节着重介绍视觉自主探索、物体目标导航和视觉物体重排布任务普遍

使用的逼真室内场景数据集, 第 4.2 节总结了研究领域内公认的评价标准, 第 4.3 节介绍当前主流的基于模仿学习

和强化学习的导航策略学习范式.

4.1 数据集

与传统的基于预先收集的图像、文本或视频数据集进行学习的互联网人工智能 (Internet artificial intelli-

gence) 不同, 具身人工智能强调具身智能体在与环境交互的过程中学习技能, 依赖于与环境交互的过程中捕获的

位姿、视觉图像、环境布局等元数据. 另一方面, 早期的图像数据集存在数据量、数据种类和场景类型有限等缺

[7]

[4]

[6]

[5]

陷, 不适应物体目标导航等任务的具身交互要求. 近年来, Matterport3D (MP3D) , Gibson , HM3D , AI2-THOR ,

iGibson [8,9] 等数据集的陆续发布缓解了这些问题. 本节首先总结视觉自主探索和 ObjectNav 任务通用数据集 (见

表 2), 然后对视觉物体重排布任务的专用数据集展开介绍.

表 2 视觉自主探索和 ObjectNav 通用数据集属性比较

2

2

数据集 发布时间 场景数目 物体数目 场景覆盖面积 (km ) 可导航面积 (km ) 支持交互 物理引擎

[4]

Matterport3D 2017 90 40 101.82 30.22 否 -

[5]

Gibson 2018 572 - 217.99 81.84 否 Pybullet

[6]

HM3D 2021 1 000 - 112.50 是 -

[7]

AI2-THOR 2019 120 3 578 - - 是 Unity

[8]

iGibson 1.0 2021 15 570 - - 是 Pybullet

[9]

iGibson 2.0 2021 15 1 217 - - 是 Pybullet

ProcTHOR [47] 2022 - 1 633 - - 是 Unity

4.1.1 视觉自主探索和物体目标导航数据集

(1) Matterport3D

为了弥补传统图像数据集的缺陷, Chang 等人 [4] 于 2017 年发布了 Matterport3D (MP3D) 数据集. MP3D 数据