Page 336 - 《软件学报》2025年第4期

P. 336

1742 软件学报 2025 年第 36 卷第 4 期

了物体目标导航算法规划路径的质量, 这些标准均是物体目标导航算法领域内常用的评价标准.

4.2.3 视觉物体重排布评价指标

本文总结了视觉重排布挑战赛 [13] 中提出的 4 个评价指标.

(1) 成功率 (success rate, SR). 如果具身智能体恢复了目标状态中所有错位物体的位置则任务成功, 否则任务

失败.

(2) 恢复率 (fixed strict). 该指标衡量了具身智能体恢复的错位物体的比例.

|M end |

fixed strict = 1− (22)

|M start |

0 ∗ M end = {i | s i 0 s } , 表示在重排布阶段结束时

∗

其中, M start = {i | s 0 s } , 表示在重排布阶段开始时错位物体的集合.

i i i

0

∗

i

错位物体的集合. s , s 分别表示重排布阶段开始前和结束时物体 的状态.

i i

(3) 错放率 (misplaced, M). 此指标等于任务结束时错位物体数除以任务开始时错位物体数.

|M end |

M = (23)

|M start |

导航策略学习范式, 采用模仿学习预训练为强化学习的

如果具身智能体在重排布阶段结束时造成比任务开始时更多的错位物体, 则此衡量指标可能大于 1.

(4) 能量剩余率 (energy remaining, E). 该指标衡量了重排布任务结束后, 场景状态与目标状态之间的相似性.

/

(∑ n ( ) ) (∑ n ( ))

0

E = D s i , s ∗ i D s , s ∗ i (24)

i

i=1 i=1

其中, 能量函数 D : S ×S → [0,1] , 当两个状态接近时, 能量函数递减到 0, 若两个状态近似相等, 则能量函数为 0.

Energy remaining 定义为重排布任务结束时剩余的能量除以重排布开始时的总能量.

4.3 模仿学习预训练与强化学习调优

Ramrakhya 等人 [14] 通过人为控制具身智能体在 MP3D 数据集上完成物体目标导航, 收集了 80k 专家知识, 得

到了 ObjectNav 任务的人类基线 (human baseline), 即 88.9% 的导航成功率, 这远高于当前最好的导航策略性能

(35.4% 的成功率). Ramrakhya 等人研究发现, 经过模仿学习训练的具身智能体能够从人类专家演示中学习有效的

物体搜索行为, 即窥视房间、检查角落里的小物体和通过转弯获得全景视野图像等技巧. 这些技巧很难通过强化

学习突出地展示出来, 即使通过先进的强化学习技术诱导这些行为也需要繁琐的奖励工程. 然而收集 80k 规模专

家知识花费了大约 2 894 h 的操作时间和 50k 美元费用, 高昂的代价致使基于模仿学习的策略学习难以扩展.

此外, Ramrakhya 等人在研究中发现, 通过模仿学习训练的导航策略难以泛化至训练数据集以外的场景, 因为

模仿学习强调的是对动作的克隆, 而不是强调搜寻并到达物体目标. 另一方面, 真实场景数据集和高性能仿真器的

联合使用, 允许采用强化学习技术以交互和试错的方式学习具身导航策略. 然而, 强化学习往往需要细致的奖励工

程, 奖励函数的设计需要权衡探索和利用 (exploration and exploitation). 为了鼓励具身智能体高效地导航至物体目

标, 奖励函数的设计会不可避免地惩罚环境探索行为, 尽管环境探索是重要且不可或缺的. 此外, 采用强化学习技

术学习的策略容易过度拟合小规模场景数据集, 损害导航策略的泛化性能.

主流的 ObjectNav 方法通常采用模仿学习预训练和强化学习调优相结合的方式来训练导航策略. 为了拓展模

仿学习的可扩展性, 强化学习被用于对模仿学习预训练模型进行微调. Ramrakhya 等人 [15] 提出了名为 PIRLNAv 的

bootstrapping 提供一个合理的起点, 减少了强化学习的负

担. 因为大多数随机采样的行动轨迹都不会产生积极的奖励, 在缺乏奖励的情况下从头开始学习通常是不切实际

的. 虽然已经有大量的工作基于 Actor-Critic 强化学习框架研究了 IL 和 RL 相结合的训练范式, 但大多数方法注重

通过模仿学习预训练学习策略 (Actor) 的参数, 而不更新值函数 (Critic) 的参数. 因此, 直接使用这些 IL 预训练策

略权重来初始化一个新的 RL 策略, 通常会导致灾难性的失败, 因为在 RL 训练的早期会针对策略进行破坏性的策

略更新. 为了克服这一挑战, Ramrakhya 等人提出了一个两阶段的学习范式, 首先只训练 Critic, 然后逐渐过渡到同

时训练 Actor 和 Critic, 从而避免 RL 之初由未训练过的 Critic 所导致的破坏性参数更新. 不同的学习阶段, Critic

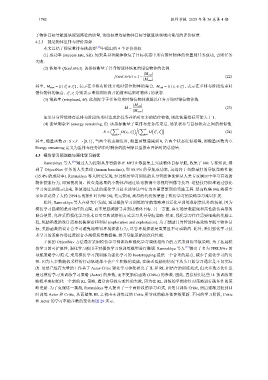

和 Actor 的学习率随步数的变化如图 29 所示.