Page 337 - 《软件学报》2025年第4期

P. 337

陈铂垒 等: 面向具身人工智能的物体目标导航综述 1743

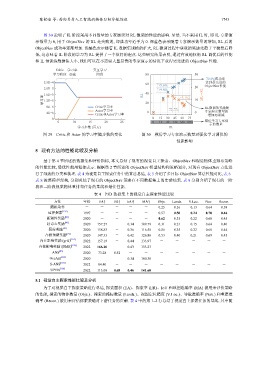

图 30 说明了 IL 阶段采用不同数量的专家演示对 RL 微调的性能的影响. 显然, 当不采用 IL 时, 即 IL 专家演

示数量为 0, 用于 ObjectNav 的 RL 是失败的, 即成功率近乎为 0. 深蓝色表示随着专家演示数量的增加, RL 后的

ObjectNav 成功率逐渐增加. 浅橘色表示随着 IL 数据集规模的扩大, RL 微调过程中获取的奖励先趋于平稳然后降

低, 这意味着 IL 阶段的学习为 RL 提供了一个很好的起点. 这些研究结果表明, 通过有效地权衡 RL 调优后的性能

和 IL 预训练数据集大小, 我们可以在不需要大量昂贵的专家演示的情况下获得更先进的 ObjectNav 性能.

Critic 学习率 交互学习

学习阶段 衰减 阶段 80 30

70.4%成功率

2.5E−4 达到最先进的

60 +9.6%

2.0E−5 20 ObjectNav性能

+9.8%

40

学习率 1.6E−5 RL 20 −3.1% 10 ΔIL→RL

1.2E−5

8E−6 Critic学习率 RL微调的奖励随

Actor学习率 +4K +12K 专家演示数量的

4E−6 0 0

Critic和Actor学习率 增加而递减

0.43

0 0 15 30 45 60 75

5 10 15 20 25 0 1k 4k 12k 36k 107k 模仿学习专家演

示的数量

学习步数 (百万) IL

图 29 Critic 和 Actor 的学习率随步数的变化 图 30 模仿学习专家演示数量对强化学习调优的

性能影响

5 现有方法的性能比较及分析

基于第 4 节所述的数据集和评价指标, 本文总结了现有的视觉自主探索、ObjectNav 和视觉物体重排布策略

的性能比较, 最优性能用粗体表示. 根据第 2 节所述的 ObjectNav 模型结构和策略划分, 对现有 ObjectNav 方法进

行了细致的分类和梳理. 表 4 为视觉自主探索任务中的算法总结, 表 5 介绍了多目标 ObjectNav 算法性能对比, 表 6–

表 8 按照模型架构, 分别总结了现有的 ObjectNav 策略在不同数据集上的实验结果. 表 9 分别介绍了现有的一阶

段和二阶段视觉物体重排布任务的基线和最佳性能.

表 4 P3D 数据集上的视觉自主探索性能比较

方法 年份 EA↑ ER↑ IoU↑ MA↑ Objs. Lands. V.Loc. Nav. Recon.

随机动作 - - - - - 0.25 0.16 0.13 0.64 0.38

边界探索 [125] 1997 - - - - 0.57 0.50 0.24 0.70 0.46

新颖性奖励 [85] 2020 - - - - 0.62 0.35 0.22 0.68 0.45

好奇心奖励 [90] 2020 157.27 - 0.34 109.79 0.31 0.21 0.15 0.64 0.40

覆盖奖励 [83] 2020 158.83 - 0.36 116.58 0.56 0.35 0.22 0.68 0.44

占据预期奖励 [54] 2020 147.33 - 0.42 126.86 0.53 0.40 0.21 0.69 0.45

内在影响奖励 (grid) [101] 2022 157.19 - 0.44 133.97 - - - - -

内在影响奖励 (DME) [102] 2022 166.20 - 133.27 - - - - -

ANS [83] 2020 73.28 0.52 - - - - - - -

OccAnt [126] 2020 - - 0.34 100.30 - - - - -

S-ANS [127] 2022 84.40 - - - - - - - -

UPEN [128] 2022 113.00 0.68 0.46 141.60 - - - - -

5.1 视觉自主探索性能比较及分析

为了对视觉自主探索策略进行总结, 探索面积 (EA)、探索率 (ER)、IoU 和地图准确率 (MA) 被用来评价策略

的性能, 搜索的物体数量 (Objs.)、搜索的路标数量 (Lands.)、视图定位精度 (V.Loc.)、导航准确率 (Nav.) 和重建准

确率 (Recon.) 被用来评估探索策略对下游任务的贡献. 表 4 中的第 1–2 行总结了视觉自主探索任务的基线. 其中随