Page 334 - 《软件学报》2025年第4期

P. 334

1740 软件学报 2025 年第 36 卷第 4 期

RoomR 数据集包括 6 000 个不同的物体重排布任务设置, 涉及 120 个不同场景中的 72 种不同类型的物体类别. 每

组数据由房间初始状态、具身智能体的起始位置和目标状态组成. 在每一个独特的物体重排布任务设置中, 可移

动的物体和可以打开但不可移动的物体的分布是随机和均匀的. 在生成初始状态和目标状态的过程中, 可打开但

不可移动的物体是否打开和打开程度以及可移动物体的位置被随机地设置. 同时, RoomR 数据集保证被打乱的物

体不会隐藏在容器中, 降低了物体重排布任务的难度. 在整个数据集中, 共有 1 895 个可拾取物体实例和 1 262 个

可打开但不可拾取物体实例. 平均每个房间分别为 15.7 个可拾取物体实例和 10.5 个可打开但不可拾取物体实例.

(2) Habitat 2.0

Habitat 2.0 数据集 [11] 由 Szot 等人于 2021 年发布, 包含基于人工设计的 ReplicaCAD 数据集构建的交互式 3D

仿真环境. ReplicaCAD 数据集不仅包括 111 个布局独特的公寓场景和 92 种可交互物体, 还提供任务场景的动态

参数、语义类别和表面注释. Habitat 2.0 仅支持具身智能体与刚体的动作交互. 与其他环境相比, 虽然 Habitat 2.0

在可交互类型数量方面并不占优势, 但 Habitat 2.0 有着其他数据集所不可比拟的运算速度. 在 Habitat 2.0 环境中,

Fetch 机器人能够以每秒 1 200 步的速度进行交互. 作为参考, 每秒 30 步的交互速度被认为是实时交互, 其他模拟

器通常能达到每秒 10–400 步. 因此, Habitat 2.0 的仿真速度达到了实时交互水平的 40 倍.

(3) HouseKeep

HouseKeep [124] 是用于评估家庭环境中的具身智能体性能的基准任务, 由 Kant 等人于 2022 年发布. HouseKeep

数据集包括整洁和不整洁的室内场景, 包含 105 个房间和涵盖 268 个类别的 1 799 个物体. 通过将场景的目标状态

打乱, 成对的目标状态和打乱后的状态被用于视觉物体重排布任务. HouseKeep 没有明确指示哪些物体需要重排

布, 具身智能体需要依靠外部的先验知识来识别哪些物体发生错位, 并从先验知识中学习如何将错位物体重排布

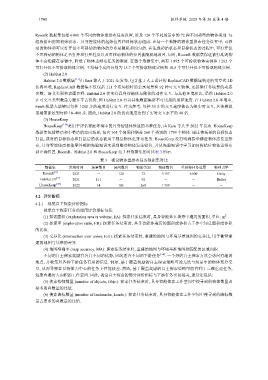

到正确位置. RoomR、Habitat 2.0 和 HouseKeep 这 3 种数据集的对比表 3 所示.

表 3 视觉物体重排布任务数据集对比

数据集 发布时间 场景数目 房间数目 物体类别 物体数目 重排布任务设置 物理引擎

RoomR [13] 2021 - 120 72 3 157 6 000 Unity

Habitat 2.0 [11] 2021 111 - 92 - - Bullet

HouseKeep [124] 2022 14 105 268 1 799 - -

地点, 并收集对各种下游任务有用的信息. 例如, 基于覆盖奖励的自主探索策略可能无法与场景中的物体充分交

4.2 评价指标

4.2.1 视觉自主探索评价指标

视觉自主探索任务的通用评价指标包括:

2

(1) 探索面积 (exploration area or volume, EA): 探索任务结束时, 具身智能体在场景中遍历的面积, 单位: m .

(2) 探索率 (exploration ratio, ER): 探索任务结束时, 具身智能体遍历的面积或体积占工作空间总面积或体积

的比值.

(3) 交并比 (intersection over union, IoU): 探索任务结束时, 重建的地图与环境基准地图的交并比, 用于衡量重

建的地图与基准的差异.

(4) 地图准确率 (map accuracy, MA): 探索任务结束时, 重建的地图与环境基准地图相匹配的区域面积.

不同的自主探索奖励有各自不同的优势, 因此适合不同的下游任务 [54] . 一个好的自主探索方法会访问有趣的

互, 从而导致在以物体为中心的任务上性能较差. 然而, 基于覆盖奖励的自主探索策略可能有利于三维重建任务,

短期内遍历大面积的工作空间. 因此, 视觉自主探索的部分评价指标与下游任务密切相关, 通常还包括:

(5) 搜索物体数量 (number of objects, Objs.): 探索任务结束时, 具身智能体在工作空间中搜寻到的物体数量占

要求的总数量的比值.

(6) 搜索路标数量 (number of landmarks, Lands.): 探索任务结束时, 具身智能体在工作空间中搜寻到的路标数

量占要求的总数量的比值.