Page 329 - 《软件学报》2025年第4期

P. 329

陈铂垒 等: 面向具身人工智能的物体目标导航综述 1735

额外微调的情况下应对各色各样的物体, 才能被广泛应用. 近期, CLIP [120] 等视觉语言模型在针对任意物体的图像

分类方面表现出了令人印象深刻的性能, 能够对训练中未明确看到的物体类别进行分类. 在物体目标导航任务中,

具身智能体必须在未见过的环境中找到通过文本标签指定的任意目标物体, 本质上可以建模为面向自然语言和视

觉图像的多模态匹配任务. 基于这一观点, Gadre 等人 [52] 率先提出了基于 CLIP 的零样本 ObjectNav 策略 CoW, 以

提高具身智能体的视觉-语言匹配能力. Gadre 等人在 Habitat 和 RoboTHOR 模拟器中评估 CoW 策略, 发现基于

CLIP 的物体定位和经典的探索策略, 在不需要额外的训练的情况下, 通常在成功、效率和鲁棒性方面优于基于学

习的方法.

随后, 为了充分利用大规模视觉语言的表征和推理能力, Majumdar 等人 [53] 提出首先学习一个图像目标导航策

略, 其中导航目标由一幅图像指定, 具身智能体被要求在真实场景中搜索并导航至该图像的拍摄位置. 通过将目标

图像和物体类别的文本标签分别编码到多模态语义嵌入空间, CLIP 等大规模视觉语言模型能够被用于目标图像

和物体类别之间的匹配, 因此具身智能体可以被指示寻找用自然语言描述的物体目标. 最近, Zhou 等人 [113] 也做了

类似的研究, 提出了一种新的零样本物体导航方法, 称为软常识约束探索 (exploration with soft commonsense

constraints, ESC), 将视觉语言预训练模型中的常识知识转移到真实世界中的物体目标导航, 而无需通过任何导航

经验或任何其他视觉环境的训练. 常识知识的引入使具身智能体克服仿真和真实场景之间的差异, 使其具备更强

大的视觉-语言匹配能力, 从而提高物体目标导航效率.

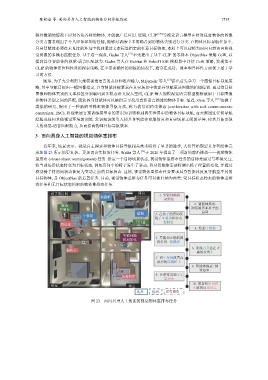

3 面向具身人工智能的视觉物体重排布

近年来, 场景表示、视觉自主探索和物体目标导航相关技术取得了显著的进步, 人们开始期望具身智能体完

成如图 23 所示的更复杂、更加切合实际的任务. Weihs 等人 [13] 于 2020 年提出了一项新的前沿挑战——视觉物体

重排布 (visual object rearrangement) 任务. 给定一个目标场景状态, 视觉物体重排布任务的目标是通过与环境交互,

将当前场景状态转变为目标状态. 例如房间中的椅子发生了移动, 具身智能体需要检测出椅子位置的变化, 并通过

移动椅子将房间状态恢复为变动之前的目标状态. 显然, 视觉物体重排布任务要求具身智能体反复导航至不同的

目标物体, 是 ObjectNav 的后置任务. 目前, 视觉物体重排布任务可以被归纳为两类: 受目标状态约束的物体重排

布任务和无目标状态约束的物体重排布任务.

孩子的房间 厨房 1.智能体随机

储藏柜 乐高积木

初始化

2.智能体探索:

游戏

控制台 浏览厨房和孩子的

壁橱 3.在孩子的房间发 房间

午餐袋

现了午餐袋和游戏

刀具盒 控制台

墙边桌

4.拾起午餐袋

智能体随

机初始化 5.导航到正确的放

置位置: 储藏柜

6.发现刀具盒在正

梳妆台

确的位置上

7.将午餐袋放置在

厨房的储藏柜上

8.智能体探索: 浏

览浴室

9.在浴室发现了乐

高积木

10.重新将乐高积

卧室 浴室

木放到墙边桌上

选择 找到 没有浏览

图 23 面向具身人工智能的视觉物体重排布任务