Page 330 - 《软件学报》2025年第4期

P. 330

1736 软件学报 2025 年第 36 卷第 4 期

3.1 受目标状态约束的物体重排布任务

Weihs 等人 [13] 基于 AI2-THOR 环境构建了 RoomR 数据集, 并于 2020 年首次提出了物体重排布任务基准模型.

Weihs 等人将物体重排布任务分为两个步骤: 预排布 (walkthrough) 和重排布 (unshuffle). 在预排布步骤中, 具身智能

体充分地探索场景的目标状态并构建场景记忆. 在重排布步骤中, 场景目标状态被打乱, 具身智能体依靠预排布阶段

构建的场景记忆识别当前状态中错位的物体并将其恢复至目标状态中相应的位置, 如图 24 所示. 顾名思义, 目标状

态已知是指在重排布步骤开始之前, 具身智能体在预排布步骤中已经探索过目标状态并获取了场景记忆. 在 2021 年

重排布挑战赛中, 物体重排布任务挑战被划分为两个赛道: 一阶段物体重排布任务和两阶段物体重排布任务.

当前状态 目标状态

图 24 物体重排布任务中的当前状态和目标状态示例

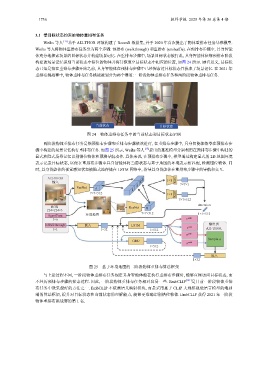

两阶段物体重排布任务是指预排布步骤和重排布步骤依次进行, 在重排布步骤中, 具身智能体依靠在预排布步

骤中构建的场景记忆执行重排布任务. 如图 25 所示, Weihs 等人 [13] 提出的基准模型分别利用在预排布步骤中构建的

显式和隐式场景记忆识别错位物体和预测导航动作. 具体来说, 在预排布步骤中, 模型通过构建显式的 2D 地图环境

表示记录目标状态, 以便在重排布步骤中具身智能体将当前状态与基于地图的环境表示相匹配, 检测错位物体. 同

时, 具身智能体的视觉感知状态被隐式地存储在 LSTM 网络中, 指导具身智能体在重排布步骤中的导航和交互.

AI2-THOR

输入 1×1 ReLU

7×7×1

ResNet A

7×7×512

1×1 ReLU

7×7×512

Attention

RGB ResNet B

224×224×3

环境地图 7×7×512 1×1×512

AgentPose

1×6 v unsh.

InWalkthrough 嵌入 LSTM walk 输出到

1×1 1×32 1×512 v AI2-THOR

π unsh.

Sample a

GRU

π walk

1×512

嵌入

1×32

图 25 基于环境地图的二阶段物体重排布算法框架

与上述过程不同, 一阶段物体重排布任务规定具身智能体能在执行重排布步骤时, 能够直接访问目标状态, 而

不经历预排布步骤的探索过程. 因此, 一阶段物体重排布任务相对容易一些. EmbCLIP [121] 是目前一阶段物体重排

布任务中效果最好的方法之一. EmbCLIP 不依赖语义映射模块, 而是采用基于 CLIP 大规模视觉语言模型的端到

端的算法框架, 提升对目标状态和当前状态的理解能力, 能够更准确识别错位物体. EmbCLIP 获得 2021 年一阶段

物体重排布挑战赛的第 1 名.