Page 322 - 《软件学报》2025年第4期

P. 322

1728 软件学报 2025 年第 36 卷第 4 期

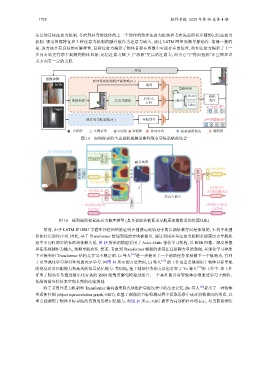

信息的目标注意力机制, 考虑到具身智能体的上一个动作的动作注意力机制和考虑先前所有步骤的记忆注意力

机制. 视觉图像特征和 3 种注意力机制的融合被作为注意力嵌入, 通过 LSTM 网络预测导航动作. 值得一提的

是, 该方法具有良好的可解释性, 目标注意力揭示了物体目标在图像中可能存在的位置, 动作注意力揭示了下一

步向右转更有助于观测到物体目标, 记忆注意力赋予了“冰箱”更高的注意力, 因为它与“烤面包机”在空间和语

义方面有一定的关联.

环境

图像观测

c

面向探索的相机控制策略π (·)

RGB 地图

策略网络

Actor 相机

启发式

地图构建 启发式模块 GRU 动作

方向

Critic

a =“向左看”

c

Depth

Transformer 结构是非常不稳定的. Li 等人

n

n

现有的导航策略π (·) 导航动作 a =“向前移动”

占据的 未探索的 空闲的 智能体 移动方向 相机视野朝向 编码器

图 13 面向探索的主动相机观测策略和现有导航策略的结合

t时刻的视觉观测

目标物体 e

GloV p g sign(β g ) 融合地图

“Toaster” Conv

t时刻动作

ResNet Conv Conv sign(β a ) LSTM AC

t−1时刻动作 p a p

β t时刻记忆

t−1时刻记忆 t时刻隐藏状态

Conv p m sign(β m ) 注意力嵌入

Conv

t−1时刻Cell状态 t时刻Cell状态

(LSTM) (LSTM)

图 14 端到端的视觉注意力概率模型 (具身智能体被要求导航至冰箱附近的烤面包机)

然而, 由于 LSTM 和 GRU 等循环神经网络被证明在捕获运动轨迹中的长期依赖方面是低效的, 不利于处理

和执行长动作序列. 因此, 基于 Transformer 的端到端的方法被提出, 通过利用多头注意力机制来捕获历史导航轨

迹中不同时间步的长距离依赖关系, 图 15 所示的模型采用了 Actor-Critic 强化学习架构, 以 RGB 图像、深度图像

和任务观测作为输入, 预测导航动作. 然而, 考虑到 Transformer 模型的训练往往依赖大量的数据, 在强化学习框架

下直接利用 [35] 进一步提出了一个辅助任务来预测下一个航路点, 有利

于引导强化学习和对环境的表示学习. 同图 14 所示的方法类似, Li 等人 [35] 的工作也重点强调用于物体目标导航

的视觉语言匹配能力和高效的场景记忆能力. 类似地, 基于辅助任务的方法也存在于 Ye 等人 [31] 的工作中. 该工作

证明了辅助任务通过最小化有效的 RNN 维数来避免模型过拟合, 一个高性能具身智能体必须通过学习平滑的、

低维的循环特征来实现长期的连续规划.

除了采用注意力机制和 Transformer 编码器来隐式地维护导航过程中的历史记忆, Du 等人 [36] 提出了一种物体

关系拓扑图 (object representation graph, ORG), 在基于图像的目标检测过程中提取场景中成对的物体间的关系, 以

重点强调用于物体目标导航的高效的场景记忆能力. 如图 16 所示, ORG 被作为局部拓扑环境表示, 与当前视觉特