Page 321 - 《软件学报》2025年第4期

P. 321

陈铂垒 等: 面向具身人工智能的物体目标导航综述 1727

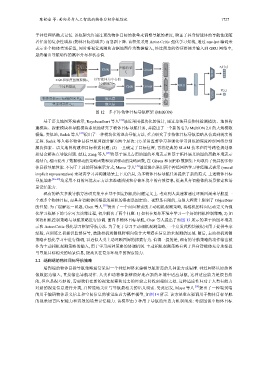

于神经网络隐式记忆. 该框架允许通过更改物体目标的数量来调整导航的难度, 验证了具身智能体的导航性能随

着任务的复杂性增加 (物体目标的增多) 而急剧下降. 该框架采用 Actor-Critic 强化学习架构, 通过 one-hot 编码来

表示多个物体类别标签, 同时将视觉观测和占据地图作为数据输入, 经过简单的特征拼接并输入到 GRU 网络中,

最终输出导航动作的概率分布和状态值.

图像特征 π θ (·|s t )

CNN Linear v i

Actor

I t

以智能体为中心的

RGB和深度图像观测o t

局部地图m t v m GRU

CNN Linear s t

全局地图M t

V(s t )

Critic

v g

嵌入层

物体目标one-hot编码向量g t

先前的动作a t−1 嵌入层 v a

图 12 多 (单) 物体目标导航框架 (MultiON)

与导航目标相关的场景信息, 提高其在复杂环境中的探索能力.

基于语义地图环境表示, Raychaudhuri 等人 [26] 最近采用模块化的设计, 通过单独开发物体检测模块、地图构

建模块、探索模块和导航模块系统地研究了物体目标导航任务, 并提出了一个新的名为 MultiON 2.0 的大规模数

据集. 类似地, Sadek 等人 [27] 提出了一种模块化的混合导航方法, 重点研究了多物体目标导航策略从仿真到现实的

迁移. Sadek 等人将多物体目标导航问题分解为两个层次: (1) 采用监督学习和强化学习训练的深度神经网络分别

解决探索、语义地图构建和目标检索问题; (2) 一旦确定了目标位置, 再将经典的 SLAM 技术和符号路径规划器

相结合解决点导航问题. 最近, Zeng 等人 [28] 将基于语义占用地图的环境表示和基于拓扑语义地图的离散环境表示

相结合, 相应提出了数据驱动的策略函数和知识驱动的策略函数, 在 Gibson 和 MP3D 数据集上均取得了优异的多物

体目标导航性能. 不同于上述的环境表示方式, Marza 等人 [29] 最近提出采用两个神经网络学习神经隐式表示 (neural

implicit representation) 来动态学习并构建场景上下文信息, 为多物体目标导航任务提供了新的范式. 上述物体目标

导航策略 [26−29] 均采用不同的环境表示方法来准确辨别和存储环境中的有效信息, 提高具身智能体的场景探索和场

景记忆能力.

现有的绝大多数导航方法研究集中在基于固定相机的问题定义上. 考虑到人类通常通过环顾四周来导航至一

个或多个物体目标, 而具身智能体所搭载的相机的姿态是固定的、视野是有限的, 这很大程度上限制了 ObjectNav

的性能. 为了缓解这一问题, Chen 等人 [30] 提出了一个面向探索的主动相机观测策略, 将相机的转向运动定义为强

化学习框架下的马尔可夫决策过程, 初步解决了两个问题: 1) 如何在复杂环境中学习一个好的相机控制策略, 2) 如

何将相机控制策略与导航策略进行协调. 面向多物体目标导航, Chen 等人提出了如图 13 所示的基于地图环境表

示和 Actor-Critic 强化学习框架导航方法. 为了便于学习主动相机观测策略, 一个启发式模块被提出用于提供专家

经验, 在训练之初提供监督信号, 鼓励相机观测视野朝向包含大量潜在信息的未观测的区域. 随后, 主动相机观测

策略在强化学习中进行微调, 以近似人类主动环顾四周的探索行为. 值得一提的是, 现有的导航策略的动作输出被

作为主动相机观测策略的输入, 用于学习两种策略的协调机制. 主动相机观测策略有利于具身智能体充分地捕捉

2.2 端到端的物体目标导航策略

端到端的物体目标导航策略通常采用一个神经网络来建模导航所需的几种能力或思维. 神经网络以原始图

像数据为输入, 直接输出导航动作. 人类和动物都能够很好地在新的环境中适应导航, 这种适应能力是很自然

的, 但也是很巧妙的, 需要我们在新的视觉观察和过去的经验之间找到相似之处. 这种适应性归功于人类有能力

对新的视觉信息进行分类, 并智能地关注与导航最相关的语义线索. 受此启发, Mayo 等人 [34] 提出了一种端到端

的用于编码物体语义信息和空间信息的视觉注意力概率模型, 如图 14 所示. 该方法重点强调用于物体目标导航

的视觉语言匹配能力和高效的场景记忆能力. 该模型由 3 种用于导航的注意力机制组成: 考虑图像中物体目标