Page 318 - 《软件学报》2025年第4期

P. 318

1724 软件学报 2025 年第 36 卷第 4 期

助于重建环境中未见过的区域的位置, 并最小化环境重建的误差. 占用预期奖励通常被建模为环境重建质量:

( )

r t ∝ −d V (P), ˆ V t (P) (14)

t

其中, P 表示相机位姿, V (P) 表示环境重建的真实结果, ˆ V t (P) 表示具身智能体在时间步 的实际环境重建, d 表

示距离函数. 不同于好奇心奖励引导具身智能体探索不确定性区域, 占用预期奖励更支持具身智能体访问那些“有

把握”的区域. 早期的环境重建局限于体素重建 [94,95] , 后来通过引入语义的概念扩展到 3D 语义重建, 要求具身智能

体检测环境中的物体级概念. 早期, 基于占用预期奖励的探索方法 [96] 被提出引导具身智能体准确地对场景和物体

进行像素级重建. Ramakrishnan 等人 [95] 的工作使用 pix2pix 模型 [97] 增强重建质量, 展示了探索策略的泛化能力, 能

够广泛地转移至其他任务. 此外, 基于占用预期奖励的探索也可以表述为基于信息增益的探索 [98−100] , 其目标是通

过探索并重建工作空间来降低环境的模糊性, 明确工作空间的占用情况.

内在影响奖励: 鼓励具身智能体对其内部环境表示的改变 [101,102] . 这种改变意味着具身智能体在探索过程中对

环境的认知的改变, 也就是内在影响. 在时间步 t , 内部环境表示的改变被度量为两个连续状态编码 ϕ(s t ) 和 ϕ(s t+1 )

的 l 2 范数:

(15)

r t =∥ ϕ(s t )−ϕ(s t+1 )∥ 2

然而直接使用上述内在影响奖励可能会导致自主探索陷入死循环困境, 即具身智能体陷入一个周期性循环,

虽然内部环境表示的改变很大, 但是无法逃离局部区域. 为了克服这个问题, Raileanu 等人 [101] 使用状态访问计数

N (s t ) 来辅助离散空间中内在影响奖励的度量, 一定程度上缓解了这个问题. 但是在连续空间中, 访问计数的概念

并不直接适用. 最近, Bigazzi 等人 [102] 提出了内在影响奖励的变体, 分别使用网格法 (grid) 和密度模型估计 (density

ˆ N (s t ) , 将内在影响奖励变更为:

model estimation, DME), 在连续空间中实现伪计数

/ √

ˆ N (s t )

r t =∥ ϕ(s t )−ϕ(s t+1 )∥ 2 (16)

ˆ N (s t ) 是估计的伪访问计数, 伪计数权重的引入,

其中, ϕ(s t ) 和 ϕ(s t+1 ) 分别表示相邻时间步状态 s t 和 s t+1 的编码,

有效缓解了具身智能体产生周期性的“高影响、低探索”问题.

在 ObjectNav 任务中, 具身智能体通过自主探索工作空间来捕获环境的先验知识, 基于对环境的认知推理、

搜寻并导航至物体目标. 因此自主探索是 ObjectNav 的前置任务, 对于 ObjectNav 任务至关重要, 为 ObjectNav 任

务提供基础特征. 当然, 过度地探索环境不是 ObjectNav 优势 (explo-

通常被视为一个权衡探索

任务的本意, ObjectNav

ration) 和利用 (exploitation) 的问题, 通过在探索和利用之间切换, 高效地捕捉有助于物体目标定位的信息, 并合理

地利用它们导航至目标.

2 面向具身人工智能的物体目标导航

近年来, 以计算机视觉、深度学习和强化学习等技术为基础, 环境表示学习和视觉自主探索领域取得了丰硕

的成果. 人们期望具身智能体能够基于语义丰富的环境表示进一步执行有目的性的探索和搜索任务, 例如物体目

标导航任务. 本节将从任务类型 (第 2.1 节)、模型结构 (第 2.2 节) 和发展进程 (第 2.3 节) 这 3 个不同的角度分别

梳理和分析面向具身人工智能的物体目标导航方法. 此外, 本节在表 1 中总结了现有的物体目标导航策略的优势

和局限性.

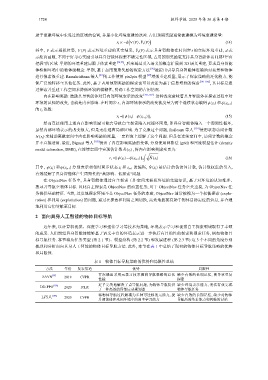

表 1 物体目标导航策略的优势和局限性总结

方法 年份 发表渠道 局限性

首次提出采用元学习技术提高导航策略的泛化 缺少有效的长期记忆, 易导致重复

[39]

SAVN 2019 CVPR

性能 探索

近乎完美地解决了点导航问题, 为物体导航提供 缺少环境表示能力, 无法有效完成

[103]

DD-PPO 2020 ICLR

了一种高效的局部运动规划器 物体导航任务

将物体导航过程解耦为多种可迁移的元能力, 提 缺少有效的长期记忆, 缺少对物体

[104]

Li等人 2020 CVPR

升智能体在未知环境中的自主学习能力 导航所需基本能力和思维的讨论