Page 349 - 《软件学报》2025年第12期

P. 349

5730 软件学报 2025 年第 36 卷第 12 期

多个角度刻画题文不一致的诱惑行为.

(4) 语言特征. 题文不符推文在字面表述上具有鲜明的语言特色和修辞套路, 我们从 6 个角度提取语言特征,

包括 (a) 正文-封面图一致性, 表示为由预训练 CLIP 模型 [70] 提取的正文特征 b 和封面图特征 , 即 [b ; t ]; (b) 正

c

c

c

c

t

文-标题一致性, 首先利用 BERT 编码正文和标题, 并使用带注意力机制的双向 GRU 分别获取其上下文特征 b 和 h,

通过孪生网络 [71] 评估一致性 sim bh = Siamese(b, h); (c) 封面图-标题一致性, 首先使用在 MS COCO 数据集 [72] 上预

训练的图像描述模型 [73] 将封面图转化为文本, 然后基于 BERT 编码来计算该文本与标题的余弦相似度; (d) 标题

情感极性, 利用情感分类器 [74] 输出的两维特征, 分别表示情感极性 (积极/中立/消极) 以及强度值, 每一维的取值被

标准化至范围 [0, 1]; (e) 标题词法分析, 通过统计特征记录推文标题中出现标点符号 (如“!”“?”“~”)、表情符号、

代词、肯定词、模糊词等出现的次数; (f) 常用诱骗词分析, 构建一个常用词统计特征, 用于记录题文不符推文常

用词 [75] (如“震惊”“艳照”“肢解”等) 的出现频次.

(5) 作者画像特征: 推文的作者能一定程度反应推文的质量. 若一个作者在过往历史中频繁发布题文不符的推

文, 则其很可能是恶意创作者, 它后续发布的推文也很大可能是带有偏见和诱骗性的. 为了刻画每个作者 u j 的口

碑度, 我们根据其作者个人资料来提取画像特征, 包括作者的账号年龄、昵称、被关注数、关注数、推文发布数、

过往历史中低质量推文发布数、第 1 篇推文发布距今时间和最后一篇推文发布距今时间 (按天数计算). 昵称项被

输入至 BERTbase 获取词嵌入特征, 其余项则都被表征为一维的数值特征. 通过将这些特征逐项拼接, 我们得以获

取表征作者画像的特征.

3 实验分析

我们进行了定性和定量分析的实验, 以全面评估所本文所提出方法的性能.

3.1 数据集与实验设置

我们在 3 个经典数据集上进行了评估, 包括 CLDInst [76] 、Clickbait17 [77] 和 FakeNewsNet [78] , 它们分别包含

4k/3k、9k/29k 和 5k/17k 的题文不符合正常推文样本. 这些数据集都是通过众包方式收集的, 对应的样本来自

Twitter 和 Instagram 等流行社交媒体平台. 相当一部分样本需要借助复杂的多跳推理和隐藏的常识才能分析出结

果, 这与我们的任务很契合. 表 3 展示了这 3 个数据集的统计结果, 下文对它们进行详细介绍.

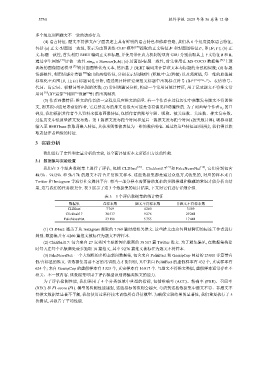

表 3 3 个评估数据集的统计特征

数据集 总样本数 题文不符样本数 非题文不符样本数

CLDInst 7 769 4 260 3 509

Clickbait17 38 517 9 276 29 241

FakeNewsNet 23 196 5 755 17 441

(1) CLDInst: 涵盖了从 Instagram 爬取的 7 769 篇时尚相关推文. 这些推文由众包网站聘用的标注工作者进行

判别. 数据集共有 4 260 篇推文被标注为题文不符样本.

(2) Clickbait17: 包含来自 27 家美国主要新闻出版商的 38 517 篇 Twitter 推文. 为了避免偏见, 在数据集构建

时每天在每个出版商处最多抽取 10 篇推文, 其中 9 276 篇推文被标注为题文不符样本.

(3) FakeNewsNet: 一个大规模的多模态新闻数据集, 包含来自 PolitiFact 和 GossipCop 网站的 23 000 多篇带有

假/真标签的推文. 该数据集需要丰富的常识能力才能判别, 其中来自 PolitiFact 的虚假样本有 432 个, 真实样本有

624 个; 来自 GossipCop 的虚假样本有 5 323 个, 真实样本有 16 817 个. 与题文不符推文类似, 虚假样本通常存在不

相关、不一致内容. 该数据集可用于评估模型识别诱骗类推文的能力.

为了评估检测性能, 我们采用了 4 个分类领域中典型的指标, 包括准确率 (ACC)、精确率 (PRE)、召回率

(REC) 和 F1-score (F1). 模型的检测性能越强, 这些指标的值则会越大. 考虑到这些数据集中题文不符、非题文不

符推文数据量显著不平衡, 我们使用过采样技术训练所有评估模型. 为确保实验结果的显著性, 我们重复执行了 5

次测试, 并报告了平均性能.