Page 344 - 《软件学报》2025年第12期

P. 344

余建兴 等: 基于常识推理问答的多模态题文不符检测 5725

t ∈ T 输入依存解析器 [46] S P .

和推文文本 , 抽取细粒度实体和关系, 形成

2.1.2 推文之外常识线索检索

判断题文不符经常涉及常识, 即文内和文外部常识之间的不一致. 这里常识指大多数人所共享, 包括关于物理

世界、历史、名人、事件等的事实. 尽管推文中没有直接提及这些知识, 但它们却是推理链中不可或缺的组成部

分. 人们通过后天的学习能自然地关联和补充这些隐含的知识, 但机器却不具备这种能力. 因此, 我们需要借助额

外知识源获取与推文相关的常识线索 S C . 一种常用的检索常识策略是借助于知识图谱 (knowledge graph, KG), 但

图谱的构建涉及大量的人工经验, 覆盖范围有限 [47] . 此外, KG 还可能存在过时知识无法匹配推文中讨论的新事物.

由于 LLM 比 KG 覆盖更广泛的常识事实, 我们提出运用提示学习引导 LLM 生成常识线索, 并采用检索增强技术

缓解 LLM 的幻觉问题. 下面介绍检索过程的 3 个步骤.

(1) 从互联网等大知识库中检索与推文相关的内容, 将其作为上下文输入 LLM, 让大模型有据可依, 促使生成

v ∈ V 作为查询, 利用搜索引擎 Google Reverse

更加准确、相关且丰富的常识. 具体地, 我们以推文中的每个图像

v

Image 检索相关度排名前 µ 的文档. 我们抽取文档中的文本, 其描述了与 相关的事件细节, 包括背景、地点、参

t ∈ T 为查询, 利用

与者等. 类似地, 我们以推文中的每段文本 Google Search API 检索并保留排名前 ξ 的文档文本.

然后, 将这些文本输入 RECOMP 模型 [48] 提炼语义并形成精简摘要, 实现去除冗余和噪音的目的.

(2) 从步骤 1 检索获得的结果中提取相关信息用于提示学习. 首先利用多模态编码器 MUSTIE [49] 将每个检索

v

t

结果 g、推文文本 及图像 分别表征为 d e 维度的特征向量 、 e t 及 . MUSTIE 考虑了不同模态的结构特性, 擅

e v

e g

长建模模态特征之间的关系, 具有很好的多模态表征能力. 然后, 我们计算每个检索结果 g 与推文 x 的相关度为

sim(g, x) = λe g ¯e t +(1−λ)e t ¯e g , 并保留前 N 个最相关的检索结果, 其中 λ 是预设权重值.

(3) 每个检索结果 g 是一段与推文相关的常识事件描述文本. 我们将 g 输入到依存解析器中提取其中的实体

g E 构造的提示指令引导 LLM 输出常识线索. 提示模板如表 1 所示, 包括

g

集合 E . 随后, 我们利用根据 g 和

[Context]、[Entity-1] 和 [Relation] 这 3 个输入的占位符, 它们分别由 g、 E 中的实体 e 以及典型的常识关系 r 来

g

g

i

填充. LLM 根据填充后的提示语句给占位符 [Entity-2] 填充合适的实体 e, 由此我们可以获得一条常识线索

g e 填充到 [Entity-1] 则能获得提示, 让 输出更高阶的常识实体 s. 重复这一过程 k 轮, 我们

(e ,r,e) ∈ S C , 继续将 LLM

i

能收集 k 阶的常识线索三元组. 如表 2 所示, 为了确定典型的常识关系, 我们对常见的常识推理提问所涉及的关系

进行了分析与归纳, 并从知识图谱 ConceptNet-5 [50] 中找出对应的 12 组关系.

表 1 用于引出常识知识的提示模板

Prompt Samples

Based on the provided context: [Context]. Given the entity [Entity-1] mentioned in the context and the commonsense relation type

[Relation], please identify a commonsense entity [Entity-2] that relates to the previous entity through the relation.

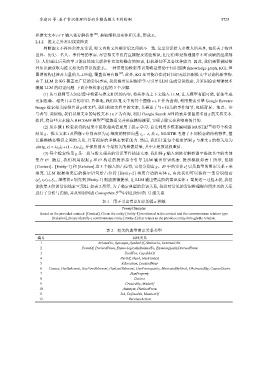

表 2 相关的典型常识关系类型

编号 具体关系

1 RelatedTo, Synonym, SymbolOf, SimilarTo, ExternalURL

2 FormOf, DerivedFrom, Etymo-logicallyRelatedTo, EtymologicallyDerivedFrom

3 UsedFor, CapableOf

4 PartOf, HasA, HasContext

5 AtLocation, LocatedNear

6 Causes, HasSubevent, HasFirstSubevent, HasLastSubevent, HasPrerequisite, MotivatedByGoal, ObstructedBy, CausesDesire

7 HasProperty

8 Desires

9 CreatedBy, MadeOf

10 Antonym, DistinctFrom

11 IsA, DefinedAs, MannerOf

12 ReceivesAction