Page 348 - 《软件学报》2025年第12期

P. 348

余建兴 等: 基于常识推理问答的多模态题文不符检测 5729

的实体通常不同, 我们将 Q i 中的实体替换为其他提问 Q j 中的实体, 从而产生多个负样例. 基于这些正、负样例,

我们使用交叉熵损失来训练校验器. 为弥补训练样本数量不足的缺陷, 我们在第 2 阶段使用来自生成器的增强训

练样本逐渐更新校验器参数. 具体地, 我们使用带有各种示例的思维链提示生成多个候选样本, 并将由校验器评判

后得分最高的样本视为正样例. 针对这些伪正样例, 继续通过前述的实体替换方法来构造负样例. 这些增强数据可

以更好地促进校验器的训练. 同时, 这些经过验证的反馈可以帮助生成器过滤低质量噪音, 输出优质的增强数据.

经过多次迭代, 我们可以得出最优的校验器和生成器.

2.3 一致性验证及预测

C

C A 可

针对生成的提问 Q i , 往往可以从推文 x 中找到一个答案 A . 然而, 题文不符推文包含欺骗性内容, 致使

i i

C

能并非 Q i 的正确答案. 因此, 我们可以通过验证答案 A 的真实性来反推出题文不符. 为了验证, 我们引入具备较

i

强常识推理能力的问答模型 VE [65] . 针对提问 Q i , VE 能够从互联网等开放域知识源中检索相关的常识知识, 并通

O O A 不匹配的时候, 推文很可能存在题文不符

C

过推理来获得答案 A . 当基于全局常识的 A 和基于文本局部语境的

i i i

内容. 这可以作为一种有效的特征, 通过联合其他经典的题文不符特征来提升检测器的鲁棒性, 作为更客观

预测.

2.3.1 答案比较

O

C A , 一种简单的方法是利用 指标来评测单词的匹配度. 但这种基于字面匹配的方法不适用

为了比较 A 和 F1

i i

于无重叠词语的两个近义答案计算. 为了解决这个问题, 我们微调一个 Transformer 模型来进行匹对. 首先使用

(

)

O

C

O

C

B E R T 模 型 将 推 文 上 下 文 线 索 S P 、 生 成 的 提 问 {Q 1 ,...,Q n } 和 答 案 对 { A ,A ,...,(A ,A )} 分 别 编 码 为 e P 、

1 1 n n

q q a a

{z ,...,z n} 和 {z ,...,z }. 随后, 线索、提问和答案对由特殊标记<CLS> 间隔, 而在答案对内部还插入了分隔标记

1 1 n

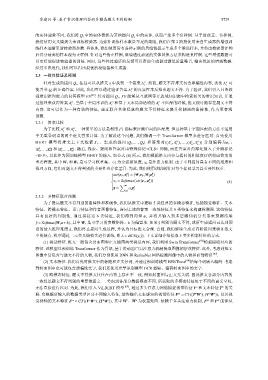

<SEP>, 以此作为预训练模型 BERT 的输入. 如公式 (4) 所示, 我们根据推文内容与提问的相似度评估相应答案的

W 2 是可学习权重集、 ⟨·⟩ 为余弦相似度, α i 是注意力机制. 由于不同提问具有不同的难度和

重要程度, 其中 W 1 和

推理方向, 它们对题文不符判别的重要性也存在差异. 为此, 我们使用该机制针对每个提问学习其重要性权重.

( q ) ⟨ q ⟩

att e P ,z = W 1 e P ,W 2 z

i i

( (

q ))

α i = Softmax att e P ,z (4)

i

∑ m

a

z = α i z

i=1 i

2.3.2 多特征联合预测

为了提高题文不符判别的鲁棒性和准确性, 我们从推文中提取 5 类经典的多模态特征, 包括视觉特征、文本

特征、跨模态特征、语言特征和作者画像特征, 连同上述的答案一致性特征共 6 类特征来构建检测器. 这些特征

具有良好的判别性. 通过拼接这 6 类特征, 我们得到向量 o, 并将其输入到多层感知机分类器来预测结果

W 3 是可学习的参数矩阵、 b 为偏置项. 如果 判别为题文不符, 或所生成提问已达到预

ˆ y

ˆ y = Softmax(W 3 o+b), 其中

d, 我们终止提问生成过程, 并认为目标推文合规. 否则, 我们继续生成更高阶提问来验证推文

设的最大推理难度

中的疑点. 模型通过二元交叉熵损失进行训练, 即 L = BCE(y, ˆy). 下文详细介绍提取 5 类多模态特征的方式.

(1) 视觉特征. 推文一般包含封面图和正文插图两类视觉内容, 我们利用 Swin Transformer [66] 模型提取对应的

特征. 该模型以预训练 Transformer 作为骨架, 基于滑动窗口自注意力机制提取图像的层次特征. 此外, 考虑到推文

图像中常包含与题文不符的人物, 我们分别使用 DNN 和 RetinaNet 网络检测图像中的人物和面部特征 [67] .

(2) 文本特征. 我们首先对推文中的标题和正文分词, 并通过预训练模型 BERTbase [68] 给每个词嵌入编码. 考虑

到封面图中也可能包含诱骗性文字, 我们还使用光学识别模型 OCR 提取、编码封面图中的文字.

(3) 跨模态特征. 题文不符推文往往在内容上存在不一致, 例如封面图与正文无关联. 因此推文各部分内容的

一致性是题文不符判别的重要依据之一. 考虑到各部分数据模态不同, 所获取的多模态特征处于不同的语义空间,

无法直接进行匹对. 为此, 我们引入 ViLBERT 模型 [69] , 通过多头注意力网络捕捉视觉特征 V 和文本特征 T 的关

b

s

)

(

F = CT( T W ,(V W )), 以及视

v

s

t

vt

b

联. 它根据所输入的数据类型区分不同输入特征, 最终输出文本感知的视觉特征

tv s v ( b t ) W 、 v vt tv 能够从

t

觉感知的文本特征 F = CT((V W ), T W ), 其中 W 为权重矩阵. 依赖于多头注意力机制, F 和 F