Page 350 - 《软件学报》2025年第12期

P. 350

余建兴 等: 基于常识推理问答的多模态题文不符检测 5731

3.2 与基准模型的性能比较实验

我们将所提出方法与 6 个主流的基准模型进行了比较, 包括: ① HPFN [79] , 根据帖子在社交网络上的传播行为

特征做判断; ② FCQA [80] , 生成关于标题的提问来验证真实性; ③ MCAN [81] , 通过堆叠的协同注意力层捕获文本和

视觉特征的相关度来判断; ④ CPDM [82] , 使用集成分类器来判断内容、标题和封面图之间的不一致性; ⑤ CCD [83] ,

基于因果干预和反事实推理来判断; ⑥ VLP [84] , 基于多模态预训练特征进行检测.

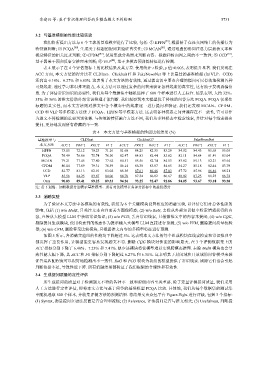

表 4 展示了在 4 个评估指标上的比较结果及其方差. 使用统计 t 检验, p 值<0.005, 表明提升显著. 我们发现在

ACC 方面, 本文方法的得分比在 CLDInst、Clickbait17 和 FakeNewsNet 等上比最佳的基准模型 (如 VLP、CCD)

还高出 6.16%、6.27% 和 6.85%. 这表明了本文方法的有效性, 通过提出切中要点合理的提问可以有效地检测各种

可疑线索. 通过学习常识推理能力, 本文方法可以通过复杂的问答来验证各种线索的真实性, 这有助于发现诱骗信

息. 为了评估常识知识的必要性, 我们从每个数据集中随机选择了 600 个样本进行人工标注. 结果表明, 大约 32%、

35% 和 36% 的推文借助外部常识推理才能判断. 我们观察到本文模型优于传统的问答方法 FCQA. FCQA 仅聚焦

标题的真实性, 而本文方法则对推文中各个模态中的线索逐一进行提问和验证. 我们还发现 MCAN、CPDM、

CCD 和 VLP 等多模态方法优于 FCQA、HPFN 等单模态方法. 这表明各种模态之间普遍存在不一致性, 它可以作

为题文不符检测的重要判别依据. 与传统的特征融合方法不同, 我们从多种模态中检索线索, 并针对每个线索提出

提问, 更好地发现所有潜藏的不一致.

表 4 本文方法与基准模型的性能比较结果 (%)

基准模型与 CLDInst Clickbait17 FakeNewsNet

本文方法 ACC ↑ PRE ↑ REC ↑ F1 ↑ ACC ↑ PRE ↑ REC ↑ F1 ↑ ACC ↑ PRE ↑ REC ↑ F1 ↑

HPFN 73.15 72.12 70.23 71.16 81.68 84.25 82.35 83.29 84.82 84.43 85.68 85.05

FCQA 76.49 76.86 75.74 76.30 82.47 84.83 82.44 83.62 82.11 84.64 81.49 83.04

MCAN 79.21 77.45 77.80 77.62 84.51 85.56 82.74 84.13 83.82 85.13 82.21 83.64

CPDM 80.04 77.89 79.31 78.59 86.14 86.30 83.07 84.65 84.27 85.18 82.44 83.79

CCD 82.77 83.13 82.91 83.02 88.36 87.61 86.46 87.03 87.72 85.96 86.46 86.21

VLP 85.56 84.25 83.87 84.06 88.70 87.34 86.02 86.67 88.02 87.25 86.23 86.74

Ours 90.83 89.41 89.25 89.33 94.26 93.25 92.47 92.86 94.05 93.67 93.10 93.38

注: 带下划线、加粗数据分别表示基准模型、所有对比模型在各评分指标中的最优得分

3.3 消融实验

为了验证本文方法中各模块的有效性, 我们为 6 个关键模块设置相应的消融实验, 以评估它们对总体性能的

影响, 包括 (1) w/o MulR, 只关注文本内容而丢弃图像模态; (2) w/o RaG, 去除从外部知识源中检索增强获得的内

容, 直接从大模型 LLM 中获取常识知识; (3) w/o PCO, 丢弃常识线索, 只根据推文中的内容来提问; (4) w/o CQG,

剔除提问生成模块, 使用检索到的线索作为提示输入大模型 LLM 直接进行预测; (5) w/o VVM, 删除提问质量校验

器; (6) w/o CVM, 删除答案比较模块, 只根据推文内容的多模型特征进行预测.

如图 5 所示, 各消融实验组的性能均下降超过 5%. 这表明本文方法的每个组成模块在线索检索和常识推理中

都发挥了重要作用, 让模型能更容易发现题文不符. 删除 CQG 模块对性能的影响最大, 在 3 个评测数据集上的

ACC 指标分别下降了 6.48%、7.23% 和 7.41%. 缺少该模块将使模型难以实现跨模态推理. 去除 MulR 模块也会导

致性能大幅下降, 其 ACC 和 F1 指标分别下降超过 6.27% 和 6.31%. 这表明基于封闭域和开放域的问答模型来验

证答案匹配程度可以很好地检测出不一致性. RaG 和 PCO 模块为我们的模型提供了常识线索. 剔除它们也会引起

判断依据不足, 导致性能下降. 所有消融结果都验证了我们框架的合理性和有效性.

3.4 生成提问质量的定性评估

所生成提问的质量对于检测题文不符的各种不一致和虚假内容至关重要. 除了定量评测提问质量, 我们采用

人工方法进行定性评估, 即将本文方法与基于问答的基准模型 FCQA 比较. 具体地, 我们从每个数据集的测试集

中随机选取 600 个样本, 并收集评测方法的预测结果. 将结果交由众包平台 Figure-Eight 进行评级, 包括 3 个指标:

(1) Syntax, 衡量提问在语法层面是否合理和流畅; (2) Relevance, 评估提问是否与推文相关; (3) Usefulness, 判断提