Page 218 - 《软件学报》2025年第9期

P. 218

王鑫澳 等: 基于联邦学习的 BERT 模型高效训练框架 4129

FedBT 选择了一个平衡的层数, 通过渐进式训练算法与深层采样映射算法, 帮助模型获得更好的表现, 同时兼顾了

模型训练过程中的计算开销和联邦学习聚合过程中的通信开销.

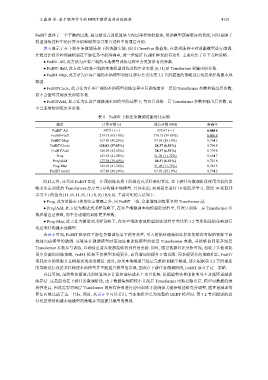

表 6 展示了在下游任务微调场景下的消融实验, 使用 ChemProt 数据集, 在联邦场景中对消融模型进行微调,

并通过比较各种消融模型在下游任务中的准确率, 进一步验证 FedBT 框架的有效性. 主要对比了以下几种策略.

● FedBT-All, 此方法为在客户端的本地模型训练过程中会更新所有的参数.

[6,11] 层 Transformer 和输出层参数.

● FedBT-Half, 此方法为在客户端的本地模型训练过程中会更新

● FedBT-Map, 此方法为在客户端的本地模型训练过程中会类比第 3.2 节所描述的策略进行浅层采样构建本地

模型.

● FedBT\Circle, 此方法为在客户端的本地模型训练过程中只训练最后一层的 Transformer 参数和输出层参数,

而不会循环式地改变训练参数.

● FedBT\Add, 此方法为在客户端微调本地模型的过程中, 每次只训练一层 Transformer 参数和输出层参数, 而

不会递增的训练更多参数.

表 6 FedBT 下游任务微调消融对比实验

模型 计算开销 (s) 通信开销 (MB) 准确率

FedBT-All 347.91 (-) 435.67 (-) 0.808 6

FedBT-Half 219.75 (63.16%) 170.15 (39.05%) 0.806 6

FedBT-Map 167.89 (48.26%) 87.95 (20.19%) 0.764 5

FedBT\Circle 128.83 (37.03%) 28.37 (6.51%) 0.706 8

FedBT\Add 148.29 (42.62%) 28.37 (6.51%) 0.770 8

Prog 143.63 (41.28%) 51.05 (11.72%) 0.664 7

Porg\Add 137.38 (39.49%) 28.37 (6.51%) 0.721 8

Prog-Map 143.63 (41.28%) 51.05 (11.72%) 0.742 3

FedBT (ours) 167.89 (48.26%) 87.95 (20.19%) 0.794 2

除此之外, 还类比 FedBT 在进一步预训练场景下的渐进式采样映射算法, 在下游任务微调阶段使用类似的策

略来决定训练的 Transformer 层序号 l 并构建本地模型. 具体来说, 如果需要进行 10 轮联邦学习, 那这 10 轮联邦

学习中 l 的值为 [11,11,11,11,11,10,10,10,9,8]. 主要对比的方法如下.

l 值的决定策略之外, 同 FedBT 一致, 会递增地训练更多的 Transformer 层;

● Prog, 此方法除去

● Prog\Add, 此方法为渐进式采样策略下, 在客户端微调本地模型的过程中, 每次只训练一层 Transformer 参

数和输出层参数, 而不会递增的训练更多参数;

● Prog-Map, 此方法为渐进式采样策略下, 在客户端的本地模型训练过程中类比第 3.2 节所描述的策略进行

浅层采样构建本地模型.

由表 6 可知, FedBT 框架在下游任务微调场景下的有效性, 引入的循环递减训练算法能够在有限的资源下高

效地完成模型的微调. 该算法在微调模型时更加注重训练模型的深层 Transformer 参数, 并能够协同更多深层

Transformer 参数参与训练, 以确保重要参数都能够得到有效更新. 同时, 通过数据对比分析可知, 相较于其他消耗

更少资源的训练策略, FedBT 框架不仅模型表现更佳, 而且增加的额外开销有限. 同表现更佳的策略相比, FedBT

消耗更少的资源并且模型表现效果接近. 此外, 如果本地模型已经是完整的 BERT 模型, 那么根据第 3.2 节所描述

的策略进行浅层采样构建本地模型并不能提升模型的表现, 因此在下游任务微调阶段, FedBT 放弃了这一策略.

并且可知, 虽然整体渐进式训练算法在计算和通信成本上更具优势, 但模型整体性能却明显不及循环递减训

练算法. 这是因为在下游任务微调阶段, 由于数据集规模较小且深层 Transformer 更贴近输出层, 模型对数据的敏

感性更高, 因此需要对深层 Transformer 的所有参数进行协同训练才能确保关键参数能够充分调整, 循环递减训练

算法有效达成了这一目标. 同时, 从表 6 中可以看出, 当本地模型已为完整的 BERT 模型时, 第 3.2 节所描述的进

行浅层采样构建本地模型的策略并不能提升模型的表现.