Page 213 - 《软件学报》2025年第9期

P. 213

4124 软件学报 2025 年第 36 卷第 9 期

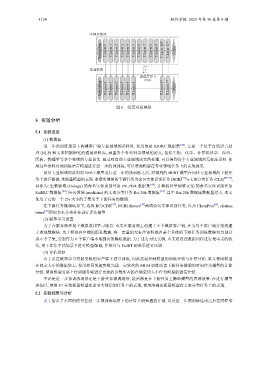

本地参数池

Embedding T-Layer 0 T-Layer 1 T-Layer 2 T-Layer 3 T-Layer 4 T-Layer 5 T-Layer 6 T-Layer 7 T-Layer 8 T-Layer 9 T-Layer 10* T-Layer 11* Output*

本地模型 l

训练层序号

l=10

Embedding T-Layer 0 T-Layer 1 T-Layer 2 T-Layer 3 T-Layer 4 T-Layer 5 T-Layer 6* T-Layer 7* Output*

图 6 浅层对应映射

5 实验分析

5.1 实验设置

(1) 数据集

进一步预训练场景下构建客户端专业领域的语料时, 使用的是 S2ORC 数据集 [40] , 它是一个用于自然语言处

理 (NLP) 和文本挖掘研究的通用语料库, 涵盖各个专业科学领域的论文, 包括生物、化学、计算机科学、经济、

医药、物理学等多个领域的专业论文. 通过对这些专业领域论文的处理, 可以得到各个专业领域的无标注语料. 使

用这些语料对预训练语言模型进行进一步的预训练, 可以增强模型在专业领域任务上的表现效果.

使用专业领域的语料对 BERT 模型进行进一步的预训练之后, 对得到的 BERT 模型在同样专业领域的下游任

[41]

务上进行微调, 来衡量模型的表现. 本章所使用的下游任务为命名实体识别任务 (NER) 与文本分类任务 (CLS) [42−44] ,

具体为: 生物领域 (biology) 的命名实体识别任务 JNLPBA 数据集 [45] , 计算机科学领域 (CS) 的命名实体识别任务

SciERC 数据集 [46] , 医药领域 (medicine) 的文本分类任务 Rct-20k 数据集 [10] . 其中 Rct-20k 数据集数据量过大, 本文

使用了它的一个 2% 大小的子集用于下游任务的微调.

在下游任务微调场景下, 选择 BC5CDR [47] , NCBI disease [48] 两项命名实体识别任务, 以及 ChemProt [49] , citation

intent [50] 两项文本分类任务进行评估模型.

(2) 联邦学习设置

为了在服务器环境下模拟联邦学习场景, 本文在服务器上创建了 6 个模拟客户端, 并为每个客户端分别构建

了本地数据集. 为了模拟客户端的隐私数据, 将一定量的无标注语料或者某个具体的下游任务训练数据均匀划分

成 6 个子集, 分别作为 6 个客户端本地拥有的隐私数据. 为了进行对比实验, 本文将这些数据同样进行集中式的收

集, 用于在集中式场景下进行模型微调, 并将其与 FedBT 的效果进行比较.

(3) 评估指标

由于是在联邦学习资源受限的客户端上进行训练, 因此需要控制模型的训练开销与计算开销. 本文使用模型

在固定大小的数据集上, 使用相同的超参数完成一定轮次的 MLM 训练或者下游任务微调的时间作为模型的计算

开销, 使用模型需要上传到服务端进行更新的参数所占的存储空间大小作为模型的通信开销.

不论是进一步预训练场景还是下游任务微调场景, 最后都是在下游任务上衡量模型的表现效果. 在进行模型

评估时, 使用 F1 分数衡量模型在命名实体识别任务上的表现, 使用准确率衡量模型在文本分类任务上的表现.

5.2 实验结果与分析

表 1 给出了不同的模型在进一步预训练场景下的计算开销和通信开销, 以及进一步预训练结束之后在同样专